- 前言

- I 简介

- II 使用

libvirt管理虚拟机 - III 与超visor无关的功能

- IV 使用 Xen 管理虚拟机

- V 使用 QEMU 管理虚拟机

- VI 故障排除

- 词汇表

- A 配置 NVIDIA 卡的 GPU 直通

- B GNU 许可协议

- 3.1 Xen 虚拟化架构

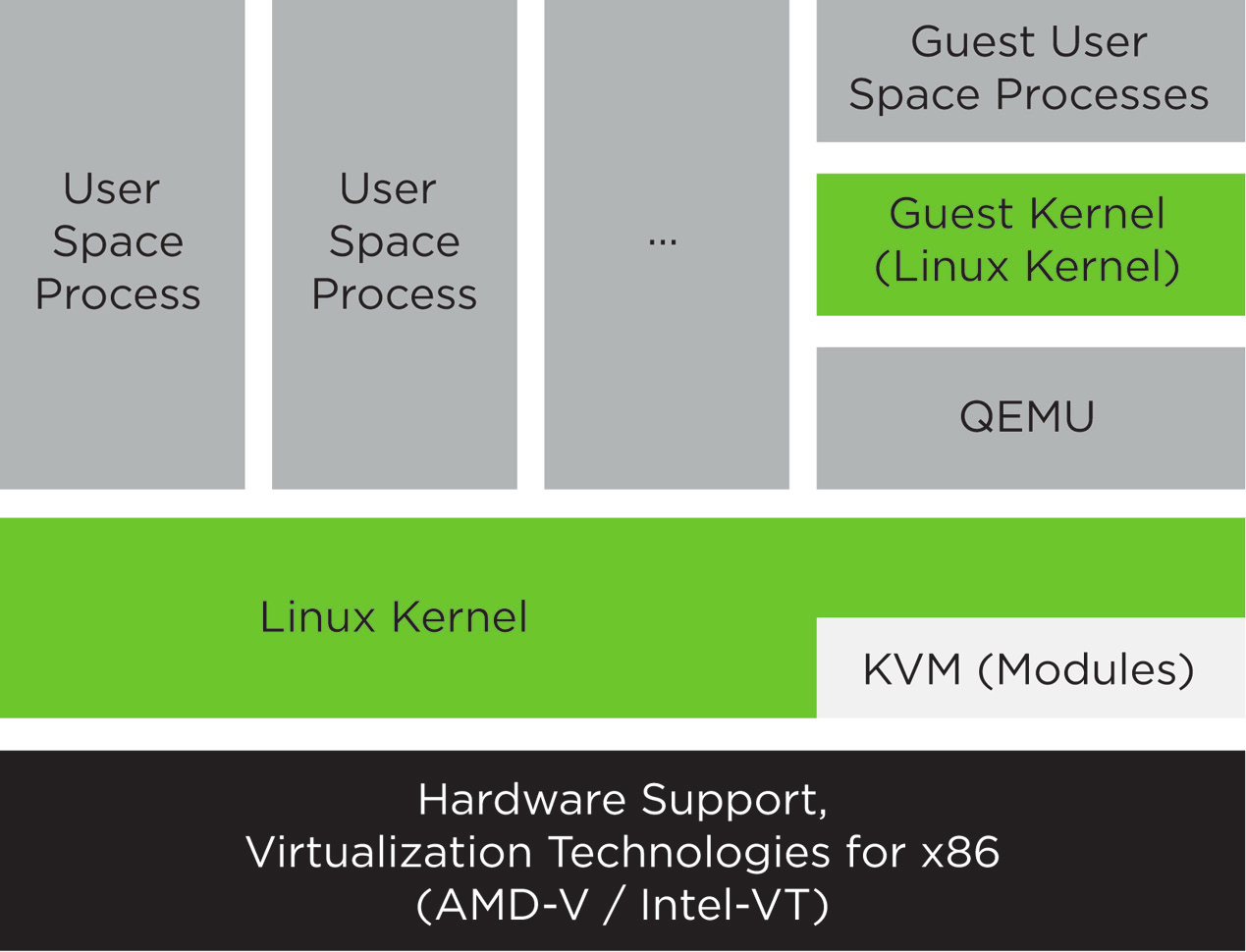

- 4.1 KVM 虚拟化架构

- 6.1 系统角色屏幕

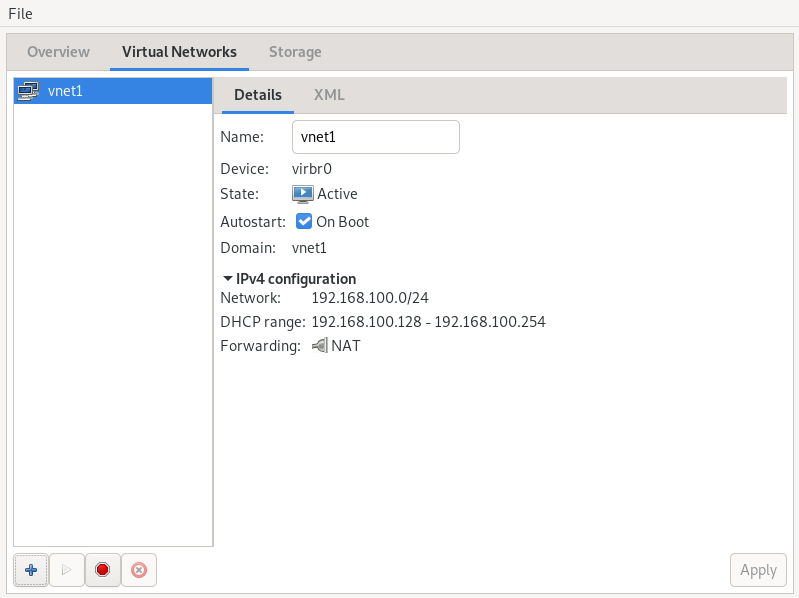

- 8.1 连接详细信息

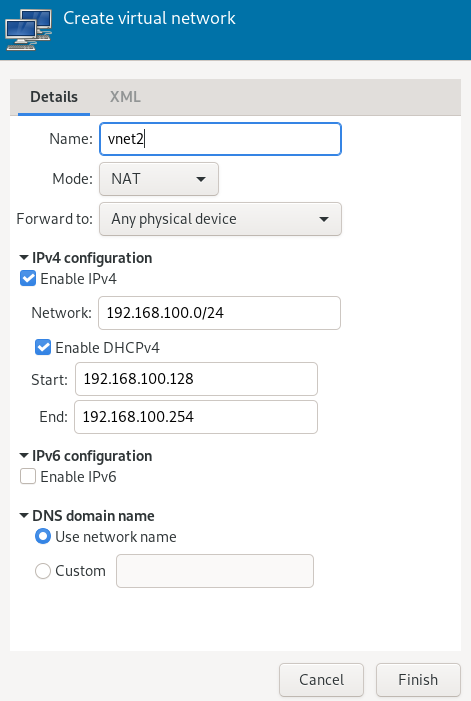

- 8.2 创建虚拟网络

- 9.1 为新虚拟机指定默认选项

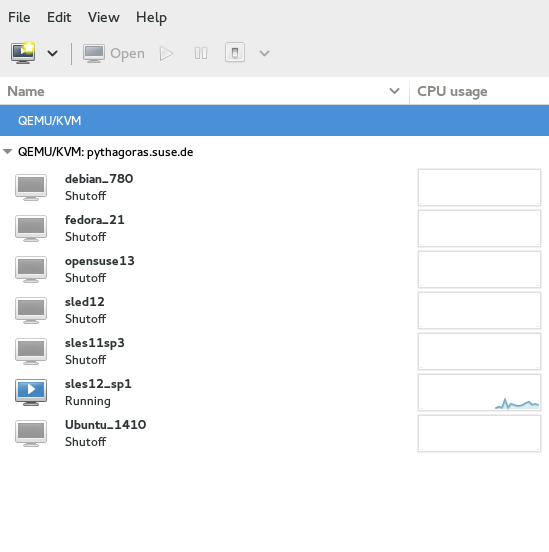

- 13.1 视图中的虚拟机客户机

- 13.2 概述详细信息

- 13.3 虚拟机客户机标题和描述

- 13.4 性能

- 13.5 统计图表

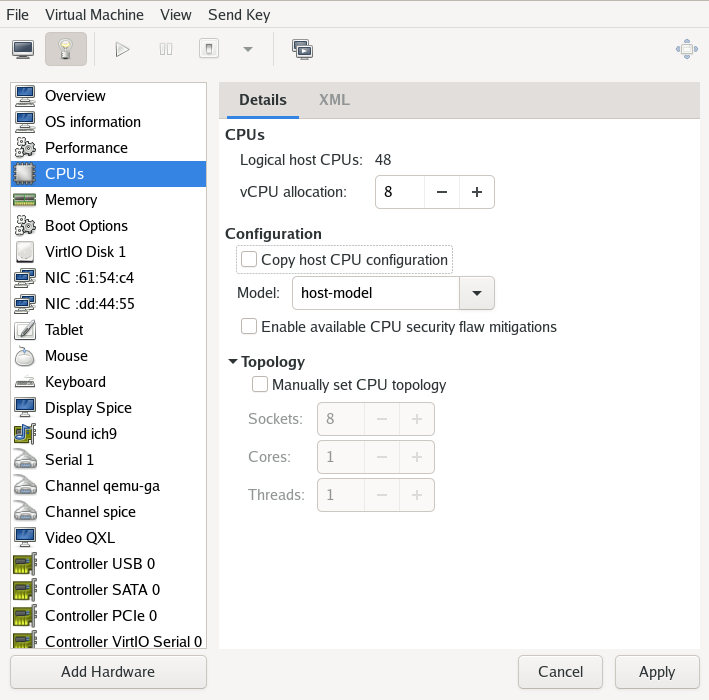

- 13.6 处理器视图

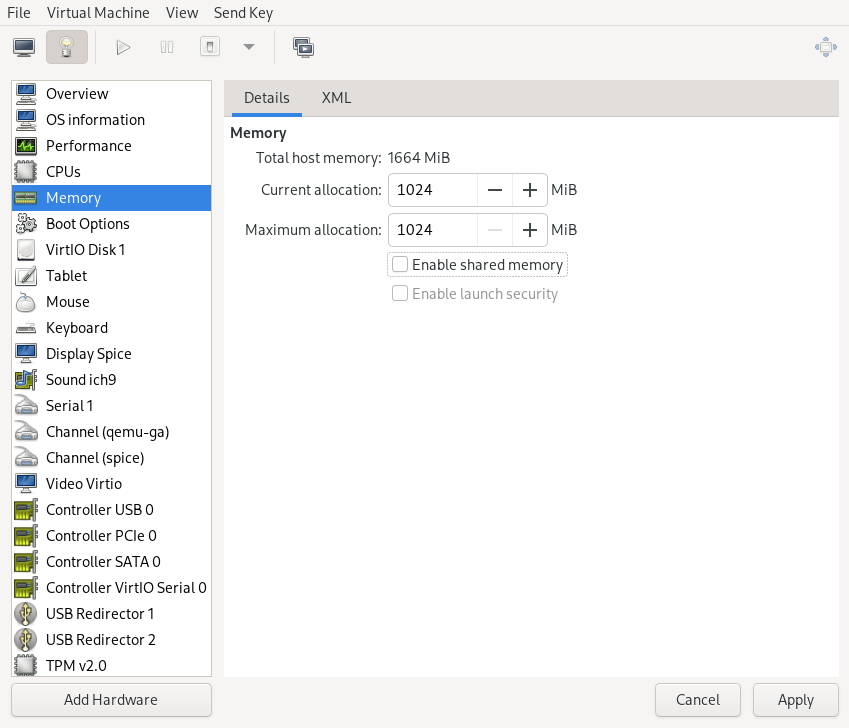

- 13.7 内存视图

- 13.8 启动选项

- 13.9 添加新存储

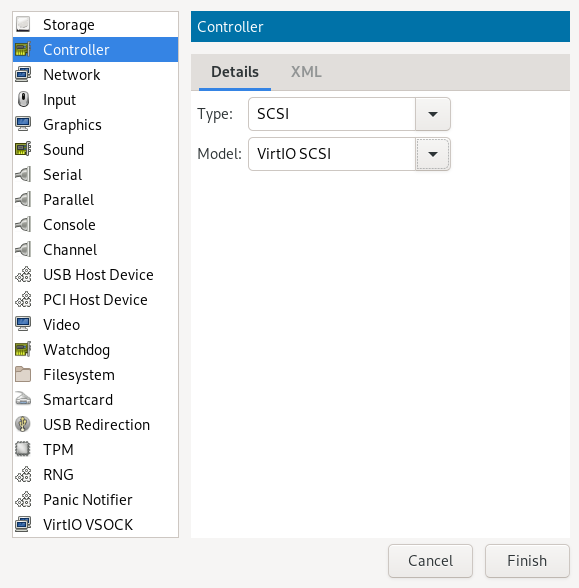

- 13.10 添加新控制器

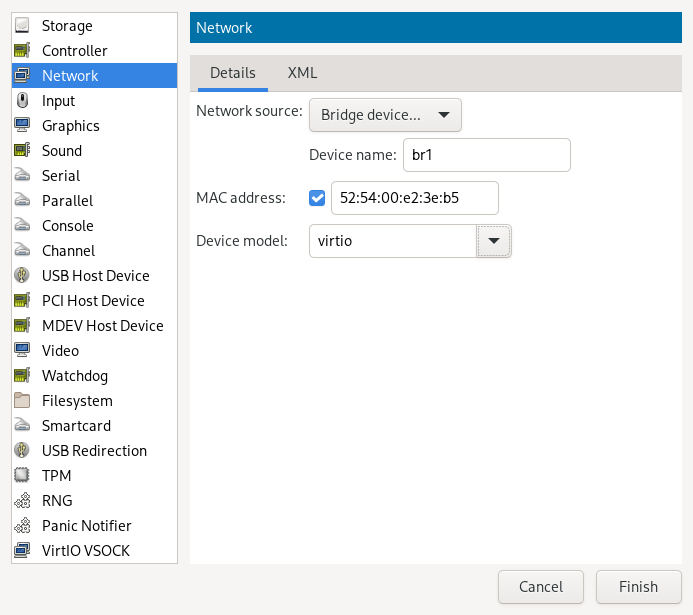

- 13.11 添加新网络接口

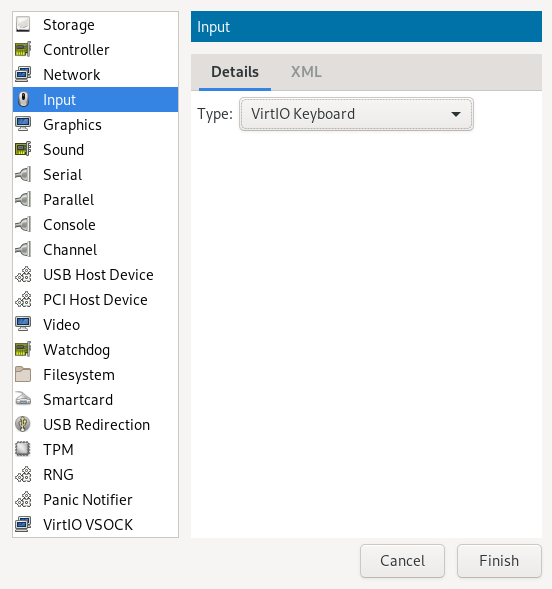

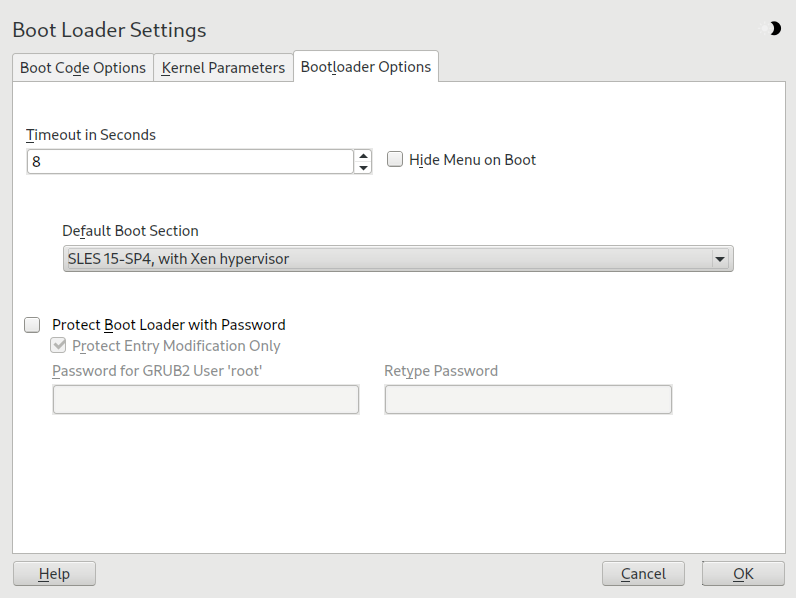

- 13.12 添加新输入设备

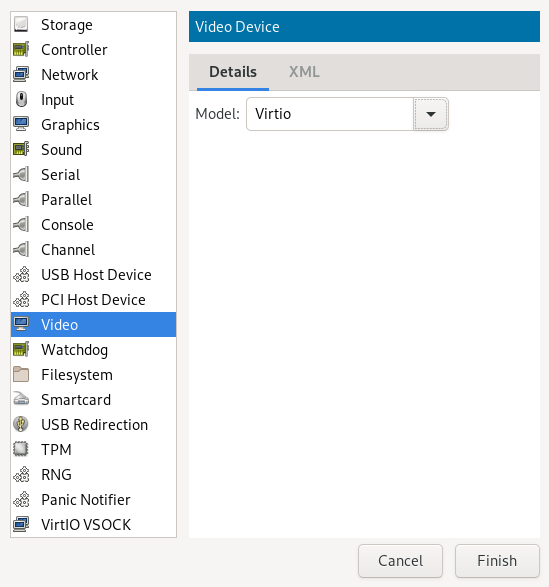

- 13.13 添加新视频设备

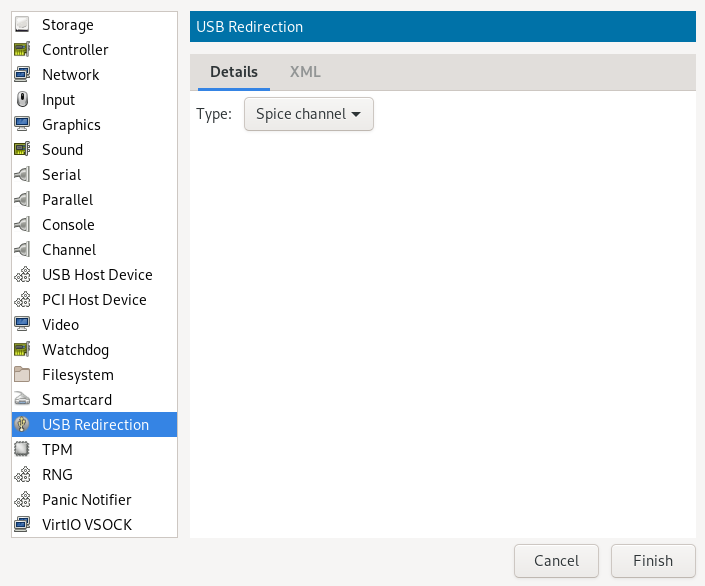

- 13.14 添加新 USB 重定向器

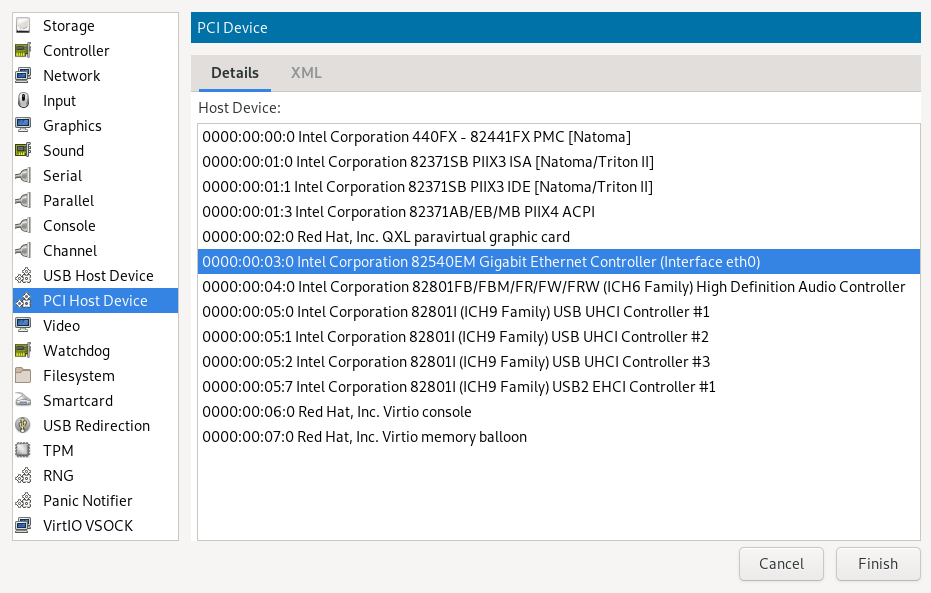

- 13.15 添加 PCI 设备

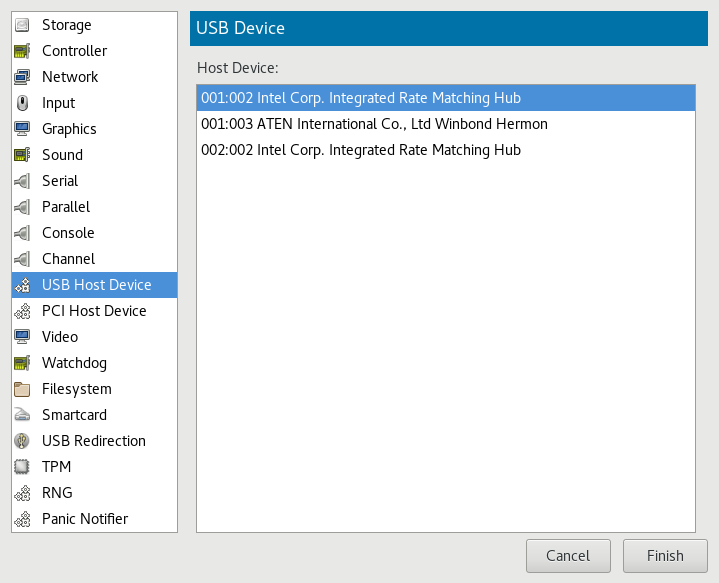

- 13.16 添加 USB 设备

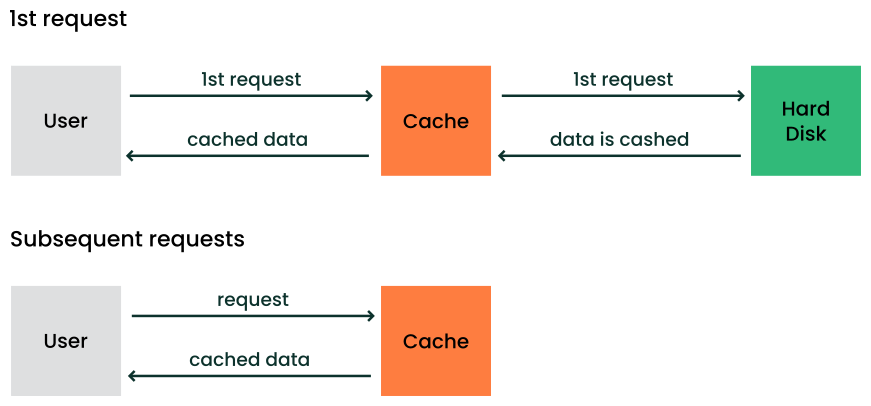

- 16.1 缓存机制

- 27.1 引导加载程序设置

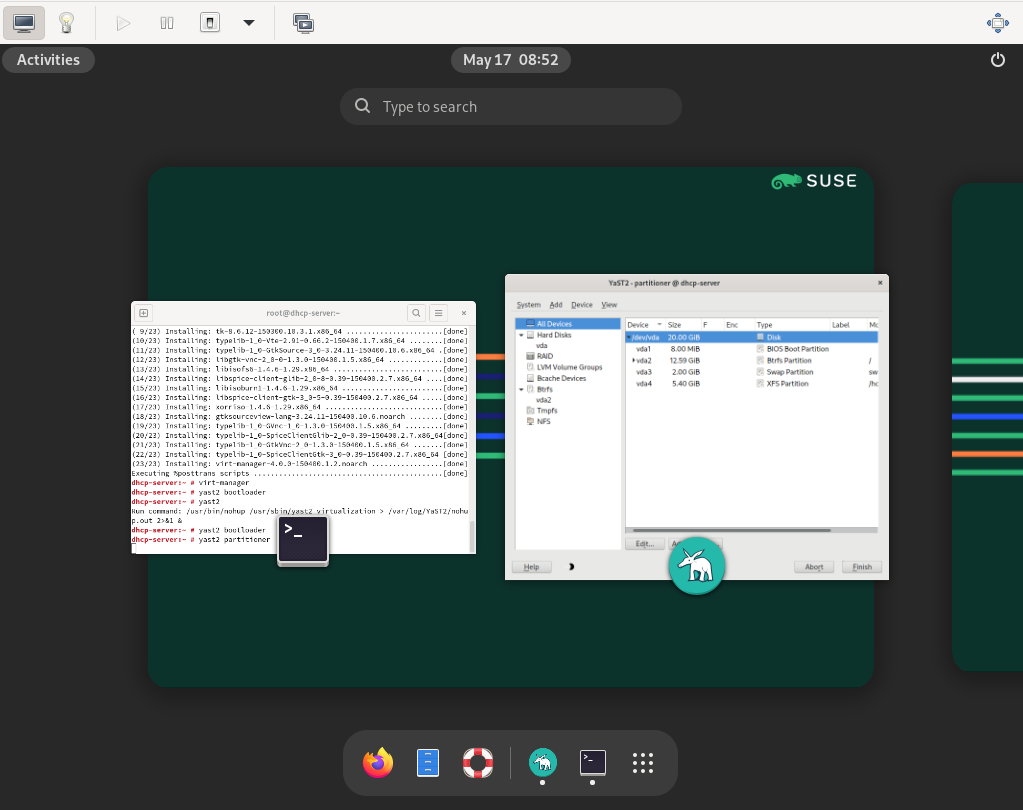

- 32.1 安装 KVM 虚拟机监控程序和工具

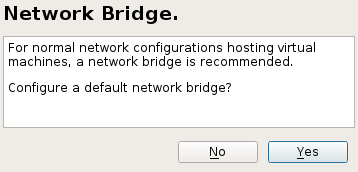

- 32.2 网络桥接

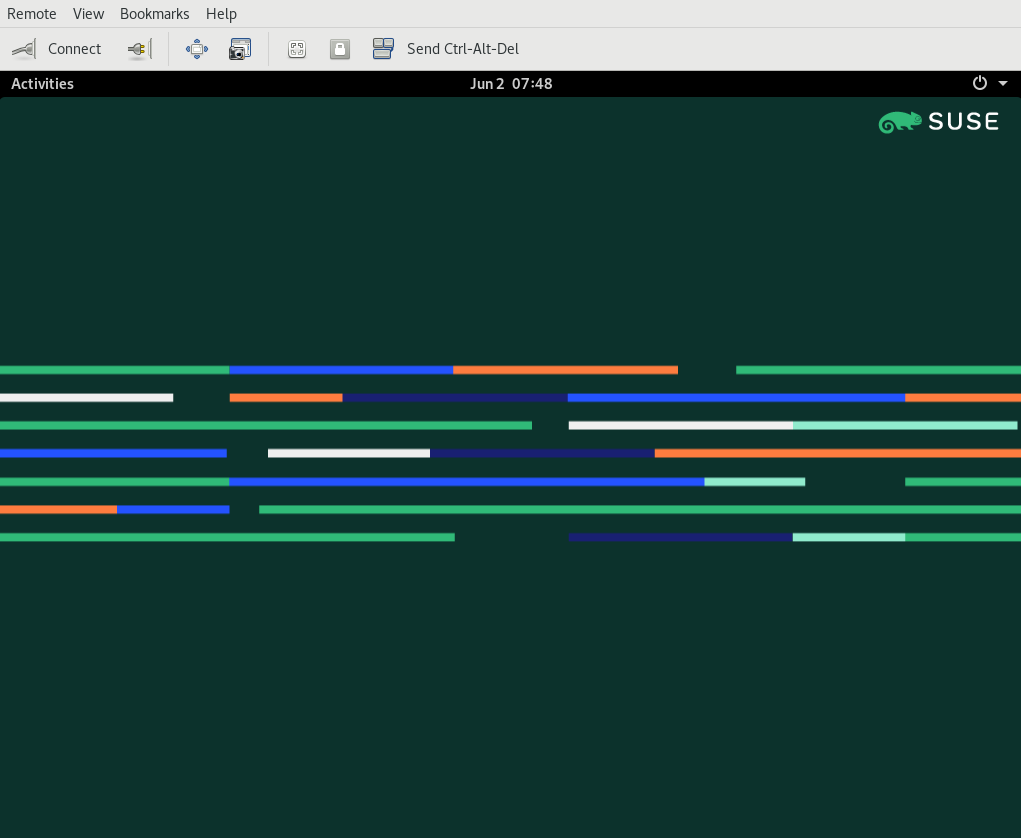

- 34.1 QEMU 窗口,SLES 作为虚拟机客户机

- 34.2 QEMU VNC 会话

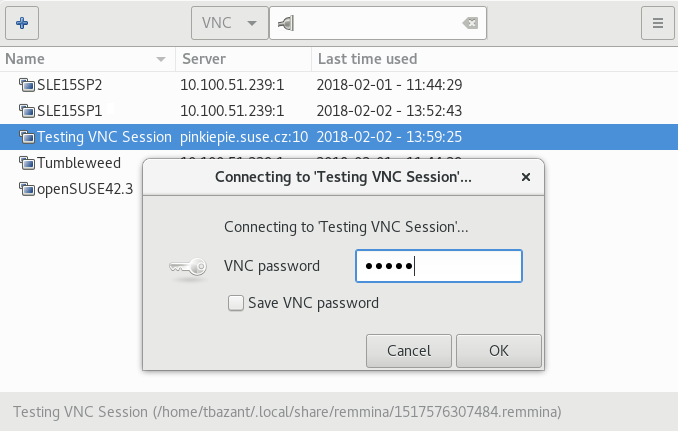

- 34.3 Remmina 中的身份验证对话框

- 8.1 基于 NAT 的网络

- 8.2 路由网络

- 8.3 隔离网络

- 8.4 在虚拟机主机服务器上使用现有桥接

- 9.1 从 HTTP 服务器加载内核和 initrd

- 9.2

virt-install命令行的示例 - 10.1

kvm_stat的典型输出 - 14.1 示例 XML 配置文件

- 24.1 SLED 12 的客户机域配置文件:

/etc/xen/sled12.cfg - 32.1 使用 VirtFS 导出主机文件系统

- 34.1 受限用户模式网络

- 34.2 自定义 IP 范围的用户模式网络

- 34.3 带网络启动和 TFTP 的用户模式网络

- 34.4 带主机端口转发的用户模式网络

- 34.5 密码身份验证

- 34.6 x509 证书身份验证

- 34.7 x509 证书和密码身份验证

- 34.8 SASL 身份验证

版权所有 © 2006–2023 SUSE LLC 及贡献者。保留所有权利。

在 GNU 自由文档许可协议第 1.2 版或(可选)第 1.3 版的条款下,允许复制、分发和/或修改本文档,其中本版权声明和许可协议为不变部分。许可协议第 1.2 版的副本包含在题为 “GNU 自由文档许可协议” 的章节中。

有关 SUSE 商标,请参阅 http://www.suse.com/company/legal/。所有第三方商标均为其各自所有者的财产。商标符号(®、™ 等)表示 SUSE 及其关联公司的商标。星号(*)表示第三方商标。

本书中的所有信息均经过仔细核实。但是,这不能保证完全准确。SUSE LLC、其关联公司、作者和译者对可能出现的错误或由此产生的后果不承担任何责任。

- 在线文档

我们的文档可在 https://doc.opensuse.net.cn 上在线获取。浏览或下载各种格式的文档。

注意:最新更新

最新的更新通常可在本文档的英文版本中获得。

- 在您的系统中

为了离线使用,发布说明也可用在您的系统上的

/usr/share/doc/release-notes下。各个软件包的文档可用在/usr/share/doc/packages下。许多命令也在其 手册页 中进行了描述。要查看它们,请运行

man,后跟特定的命令名称。如果您的系统上未安装man命令,请使用sudo zypper install man进行安装。

欢迎您对本文档提出反馈和贡献。以下是提供反馈的渠道:

- 错误报告

请在 https://bugzilla.opensuse.org/ 上报告文档问题。

为了简化此过程,请单击 HTML 版本本文档中标题旁边的 图标。这将预先选择 Bugzilla 中的正确产品和类别,并添加指向当前章节的链接。您可以立即开始编写错误报告。

需要一个 Bugzilla 帐户。

- 贡献

要贡献本文档,请单击 HTML 版本本文档中标题旁边的 图标。这将带您到 GitHub 上的源代码,您可以在那里打开一个拉取请求。

需要一个 GitHub 帐户。

注意: 仅适用于英文

“”图标仅适用于每份文档的英文版本。对于所有其他语言,请改用“”图标。

有关用于此文档的文档环境的更多信息,请参阅 https://github.com/SUSE/doc-sle 上的存储库 README。

- 邮件

您还可以将错误报告和有关文档的反馈发送至 <doc-team@suse.com>。请包含文档标题、产品版本和文档的发布日期。此外,请包含相关的章节编号和标题(或提供 URL),并提供问题的简洁描述。

- 帮助

如果您在 openSUSE Leap 上需要进一步的帮助,请参阅 https://en.opensuse.net.cn/Portal:Support。

本文档中使用了以下通知和排版约定:

/etc/passwd:目录名和文件名占位符:将 占位符 替换为实际值

PATH:环境变量ls、--help:命令、选项和参数user:用户名或组名软件包名:软件包的名称

Alt、Alt–F1:要按下的键或键组合。键以键盘上的大写字母显示。

、 › :菜单项、按钮

第 1 章,《“示例章节”:对本指南中另一个章节的交叉引用。

必须以

root权限运行的命令。通常,您也可以在这些命令前加上sudo命令,以非特权用户的身份运行它们。#command>sudocommand可以由非特权用户运行的命令。

>command通知

警告:警告通知

在继续之前您必须了解的重要信息。警告您有关安全问题、潜在的数据丢失、硬件损坏或物理危害。

重要:重要通知

在继续之前您应该了解的重要信息。

注意:注意通知

其他信息,例如关于软件版本差异的信息。

提示:提示通知

有用的信息,例如指南或实用建议。

紧凑型通知

其他信息,例如关于软件版本差异的信息。

有用的信息,例如指南或实用建议。

- 1 虚拟化技术

虚拟化是一种技术,它允许一台机器(主机)在其主机操作系统之上运行另一个操作系统(客户虚拟机)。

- 2 虚拟化场景

虚拟化为您的组织提供了几个有用的功能,例如

更高效的硬件使用

对旧版软件的支持

操作系统隔离

实时迁移

灾难恢复

负载均衡

- 3 Xen 虚拟化简介

本章介绍并解释了设置和管理基于 Xen 的虚拟化环境所需的组件和技术。

- 4 KVM 虚拟化简介

- 5 虚拟化工具

libvirt是一个库,它为管理流行的虚拟化解决方案(包括 KVM 和 Xen)提供了一个通用的 API。该库为这些虚拟化解决方案提供了一个规范化的管理 API,从而为更高级别的管理工具提供了一个稳定、跨虚拟化管理程序的接口。该库还提供用于管理虚拟机主机服务器上虚拟网络和存储的 API。每个虚拟机客户机的配置都存储在一个 XML 文件中。使用

libvirt,您还可以远程管理虚拟机客户机。它支持 TLS 加密、x509 证书和使用 SASL 进行身份验证。这使得能够从单个工作站集中管理虚拟机主机服务器,从而无需单独访问每个虚拟机主机服务器。使用基于

libvirt的工具是管理虚拟机客户机的推荐方法。libvirt和基于libvirt的应用程序之间的互操作性经过测试,并且是 SUSE 支持的重要组成部分。- 6 虚拟化组件的安装

要运行一个虚拟化服务器(VM 主机服务器),它可以托管一个或多个客户系统(VM 客户机),您需要在服务器上安装所需的虚拟化组件。这些组件因您想要使用的虚拟化技术而异。

openSUSE Leap 包含最新的开源虚拟化技术 Xen 和 KVM。借助这些虚拟机监控程序,openSUSE Leap 可用于在单个物理系统上配置、取消配置、安装、监视和管理多个虚拟机(VM 客户机)(有关更多信息,请参阅 虚拟机监控程序)。openSUSE Leap 可以创建运行经过修改、高度优化的半虚拟化操作系统以及完全虚拟化的未修改操作系统的虚拟机。

启用虚拟化的操作系统主要组件是虚拟机监控程序(或虚拟机管理器),它是直接运行在服务器硬件上的软件层。它通过向每个虚拟机客户机呈现虚拟化的硬件接口来控制平台资源,并与多个虚拟机客户机及其操作系统共享这些资源。

openSUSE 是一个 Linux 服务器操作系统,提供两种类型的虚拟机监控程序:Xen 和 KVM。

openSUSE Leap 配合 Xen 或 KVM 可作为虚拟化主机服务器(VHS),它通过自己的客户机操作系统支持虚拟机客户机。SUSE VM 客户机架构由虚拟机监控程序和管理组件组成,这些组件构成了 VHS,运行着许多应用程序托管的虚拟机客户机。

在 Xen 中,管理组件运行在一个特权虚拟机客户机中,通常称为 Dom0。在 KVM 中,Linux 内核充当虚拟机监控程序,管理组件直接运行在 VHS 上。

虚拟化在提供与硬件服务器相同的服务的同时,带来了许多优势。

首先,它降低了基础设施的成本。服务器主要用于向客户提供服务,而虚拟化操作系统可以提供相同的服务,具有

更少的硬件:您可以在一台主机上运行多个操作系统,因此减少了所有硬件维护。

更少的电力/冷却:更少的硬件意味着您不需要在电力、备用电源和冷却方面进行更多投资,以获得更多服务。

节省空间:您的数据中心空间得以节省,因为您不需要更多的硬件服务器(相比运行的服务,服务器数量更少)。

更少的管理:使用虚拟机客户机简化了您基础设施的管理。

灵活性和生产力:虚拟化提供了 迁移、实时迁移 和 快照 功能。这些功能减少了停机时间,并提供了一种在不中断服务的情况下轻松将服务从一个地方移动到另一个地方的方法。

客户机操作系统以完全虚拟化(FV)模式或半虚拟化(PV)模式托管在虚拟机中。每种虚拟化模式都有其优缺点。

完全虚拟化模式允许虚拟机运行未修改的操作系统,例如 Windows* Server 2003。它可以利用二进制翻译或硬件辅助虚拟化技术,例如 AMD* Virtualization 或 Intel* Virtualization Technology。使用硬件辅助技术可以提高支持它的处理器上的性能。

为了能够在半虚拟化模式下运行,客户机操作系统通常需要针对虚拟化环境进行修改。然而,在半虚拟化模式下运行的操作系统比在完全虚拟化下运行的操作系统性能更好。

目前已修改为在半虚拟化模式下运行的操作系统称为半虚拟化操作系统,包括 openSUSE Leap。

虚拟机客户机不仅共享主机系统的 CPU 和内存资源,还共享 I/O 子系统。由于软件 I/O 虚拟化技术提供的性能不如裸机,最近开发了能够提供接近“原生”性能的硬件解决方案。openSUSE Leap 支持以下 I/O 虚拟化技术:

- 完全虚拟化

完全虚拟化(FV)驱动程序模拟广泛支持的真实设备,这些设备可以与虚拟机客户机中的现有驱动程序一起使用。客户机也称为硬件虚拟机(HVM)。由于虚拟机主机服务器上的物理设备可能与模拟设备不同,因此虚拟机监控程序需要在将所有 I/O 操作移交给物理设备之前对其进行处理。因此,所有 I/O 操作都需要经过两个软件层,这个过程不仅显著影响 I/O 性能,还会消耗 CPU 时间。

- 半虚拟化

半虚拟化(PV)允许虚拟机监控程序与虚拟机客户机之间直接通信。由于开销较小,性能比完全虚拟化要好。然而,半虚拟化要求客户机操作系统要么经过修改以支持半虚拟化 API,要么需要半虚拟化驱动程序。

- PVHVM

这种虚拟化类型通过半虚拟化(PV)驱动程序以及 PV 中断和计时器处理来增强 HVM(请参阅 完全虚拟化)。

- VFIO

VFIO 代表虚拟函数 I/O,是 Linux 的一种新的用户级别驱动程序框架。它取代了传统的 KVM PCI 直通设备分配。VFIO 驱动程序在安全的内存(IOMMU)保护环境中向用户空间公开直接设备访问。通过 VFIO,虚拟机客户机可以直接访问虚拟机主机服务器上的硬件设备(直通),从而避免了在性能关键路径中由仿真引起的性能问题。此方法不允许共享设备——每个设备只能分配给一个虚拟机客户机。VFIO 需要虚拟机主机服务器 CPU、芯片组和 BIOS/EFI 支持。

与旧的 KVM PCI 设备分配相比,VFIO 具有以下优点:

资源访问与 UEFI 安全启动兼容。

设备隔离且其内存访问受到保护。

提供具有更灵活设备所有权模型的用户空间设备驱动程序。

独立于 KVM 技术,不限于 x86 架构。

在 openSUSE Leap 中,USB 和 PCI 直通设备分配方法已弃用,并被 VFIO 模型取代。

- SR-IOV

最新的 I/O 虚拟化技术,单根 I/O 虚拟化 SR-IOV 结合了上述技术的优点——性能以及与多个虚拟机客户机共享设备的能力。SR-IOV 需要特殊的 I/O 设备,这些设备能够复制资源,使其显示为多个独立设备。每个这样的“伪”设备都可以由单个客户机直接使用。然而,例如对于网卡,并发队列的数量是有限的,与半虚拟化驱动程序相比,可能会降低虚拟机客户机的性能。在虚拟机主机服务器上,SR-IOV 必须得到 I/O 设备、CPU 和芯片组、BIOS/EFI 和虚拟机监控程序的支持——有关设置说明,请参阅 第 13.12 节,“将主机 PCI 设备分配给虚拟机客户机”。

重要:VFIO 和 SR-IOV 的要求

要能够使用 VFIO 和 SR-IOV 功能,虚拟机主机服务器需要满足以下要求:

需要在 BIOS/EFI 中启用 IOMMU。

对于 Intel CPU,需要在内核命令行中提供内核参数

intel_iommu=on。有关更多信息,请参阅 https://github.com/torvalds/linux/blob/master/Documentation/admin-guide/kernel-parameters.txt#L1951。需要提供 VFIO 基础设施。这可以通过加载内核模块

vfio_pci来实现。有关更多信息,请参阅 《参考》一书,第 10 章,“systemd守护进程”,第 10.6.4 节,“加载内核模块”

许多服务器可以被一台大型物理服务器替换,从而整合了硬件,并将客户机操作系统转换为虚拟机。这也支持在新硬件上运行旧版软件。

更好地利用未满 100% 使用率的资源

需要更少的服务器位置

更有效地利用计算机资源:同一台服务器上的多个工作负载

简化数据中心基础设施

简化将工作负载迁移到其他主机,避免服务中断

更快、更灵活的虚拟机配置

多个客户机操作系统可以在一台主机上运行

重要提示

服务器整合需要特别注意以下几点:

应仔细规划维护窗口

存储是关键:它必须能够支持迁移和不断增长的磁盘使用

您必须验证您的服务器能否支持额外的负载

客户机操作系统与运行它们的宿主机完全隔离。因此,如果虚拟机内部出现问题,宿主机不会受到损害。同样,一个虚拟机内部的问题也不会影响其他虚拟机。虚拟机之间不共享任何数据。

UEFI 安全启动可用于虚拟机。

应避免使用 KSM。有关 KSM 的更多详细信息,请参阅 KSM。

可以为虚拟机分配单个 CPU 核心。

应禁用超线程 (HT) 以避免潜在的安全问题。

虚拟机不应共享网络、存储或网络硬件。

使用高级虚拟机监控程序功能(如 PCI 直通或 NUMA)会对虚拟机迁移能力产生不利影响。

使用半虚拟化和

virtio驱动程序可以提高虚拟机性能和效率。

AMD 提供了关于虚拟化安全的特定功能。

虚拟机监控程序可以创建虚拟机快照,从而可以恢复到已知良好状态,或任何期望的早期状态。由于虚拟化操作系统比直接运行在裸机上的操作系统对硬件配置的依赖性较低,因此这些快照可以恢复到不同的服务器硬件上,只要它运行的是相同的虚拟机监控程序。

本章介绍并解释了设置和管理基于 Xen 的虚拟化环境所需的组件和技术。

基于 Xen 的虚拟化环境的基本组件是:

Xen 虚拟机监控程序

Dom0

任何数量的其他虚拟机客户机

用于管理虚拟化的工具、命令和配置文件

集体而言,运行所有这些组件的物理计算机称为虚拟机主机服务器,因为这些组件共同构成了一个托管虚拟机的平台。

- Xen 虚拟机监控程序

Xen 虚拟机监控程序,有时简称为虚拟机监视器,是一个开源软件程序,它协调虚拟机和物理硬件之间的低级交互。

- Dom0

虚拟机主机环境,也称为Dom0或控制域,由几个组件组成,例如:

openSUSE Leap 提供图形和命令行环境来管理虚拟机主机组件及其虚拟机。

注意

术语“Dom0”指的是一个提供管理环境的特殊域。它可以以图形模式或命令行模式运行。

基于 xenlight 库(libxl)的 xl 工具堆栈。使用它来管理 Xen 客户机域。

QEMU——一个开源软件,它模拟完整的计算机系统,包括处理器和多个外围设备。它提供了以完全虚拟化或半虚拟化模式托管操作系统的能力。

- 基于 Xen 的虚拟机

基于 Xen 的虚拟机,也称为VM 客户机或DomU,由以下组件组成:

至少一个包含可引导操作系统的虚拟磁盘。虚拟磁盘可以基于文件、分区、卷或其他类型的块设备。

每个客户机域的配置文件。它是一个遵循手册页

man 5 xl.conf中描述的语法的文本文件。几个网络设备,连接到控制域提供的虚拟网络。

- 管理工具、命令和配置文件

有一系列 GUI 工具、命令和配置文件可以帮助您管理和自定义您的虚拟化环境。

KVM 是一个完全虚拟化解决方案,适用于支持硬件虚拟化的硬件架构。

虚拟机客户机(虚拟机)、虚拟存储和虚拟网络可以通过 QEMU 工具直接管理,或者通过基于 libvirt 的堆栈进行管理。QEMU 工具包括 qemu-system-ARCH、QEMU monitor、qemu-img 和 qemu-ndb。基于 libvirt 的堆栈包括 libvirt 本身,以及 libvirt 应用程序,如 virsh、virt-manager、virt-install 和 virt-viewer。

摘要#

libvirt 是一个库,它为管理流行的虚拟化解决方案(包括 KVM 和 Xen)提供了一个通用的 API。该库为这些虚拟化解决方案提供了一个规范化的管理 API,从而为更高级别的管理工具提供了一个稳定、跨虚拟化管理程序的接口。该库还提供用于管理虚拟机主机服务器上虚拟网络和存储的 API。每个虚拟机客户机的配置都存储在一个 XML 文件中。

使用 libvirt,您还可以远程管理虚拟机客户机。它支持 TLS 加密、x509 证书和使用 SASL 进行身份验证。这使得能够从单个工作站集中管理虚拟机主机服务器,从而无需单独访问每个虚拟机主机服务器。

使用基于 libvirt 的工具是管理虚拟机客户机的推荐方法。 libvirt 和基于 libvirt 的应用程序之间的互操作性经过测试,并且是 SUSE 支持的重要组成部分。

libvirt 包含多个用于管理虚拟机的命令行实用程序。其中最重要的有:

virsh(软件包:libvirt-client)一个命令行工具,用于管理虚拟机客户机,功能与虚拟机管理器类似。

virsh允许您更改虚拟机客户机的状态,设置新客户机和设备,或编辑现有配置。virsh对于脚本化虚拟机客户机管理操作也很有用。virsh将第一个参数作为命令,后续参数作为该命令的选项。virsh [-c URI] COMMAND DOMAIN-ID [OPTIONS]

与

zypper类似,virsh也可以在没有命令的情况下调用。在这种情况下,它会启动一个等待您输入命令的 shell。当需要运行后续命令时,此模式很有用。~> virsh -c qemu+ssh://wilber@mercury.example.com/system Enter passphrase for key '/home/wilber/.ssh/id_rsa': Welcome to virsh, the virtualization interactive terminal. Type: 'help' for help with commands 'quit' to quit virsh # hostname mercury.example.comvirt-install(软件包:virt-install)一个命令行工具,用于使用

libvirt库创建新的虚拟机客户机。它支持通过 VNC 或SPICE 协议进行图形化安装。给定合适的命令行参数,virt-install可以无人值守运行。这使得安装客户机可以轻松自动化。virt-install是虚拟机管理器使用的默认安装工具。remote-viewer(软件包:virt-viewer)一个简单的远程桌面查看器。它支持 SPICE 和 VNC 协议。

virt-clone(软件包:virt-install)一个用于使用

libvirt虚拟机监控程序管理库克隆现有虚拟机映像的工具。virt-host-validate(软件包:libvirt-client)一个工具,用于验证主机是否已配置为适合运行

libvirt虚拟机监控程序驱动程序。

以下基于 libvirt 的图形工具在 openSUSE Leap 上可用。所有工具都由带有工具名称的软件包提供。

- 虚拟机管理器 (软件包:virt-manager)

虚拟机管理器是一个用于管理虚拟机客户机的桌面工具。它提供了控制现有机器的生命周期(启动/关闭、暂停/恢复、保存/恢复)以及创建新虚拟机客户机的能力。它允许管理多种类型的存储和虚拟网络。它通过内置的 VNC 查看器提供对虚拟机客户机图形控制台的访问,并可用于查看性能统计信息。

virt-manager支持连接到本地libvirtd,管理本地虚拟机主机服务器,或远程libvirtd管理远程虚拟机主机服务器。要启动虚拟机管理器,请在命令提示符下输入

virt-manager。注意

要禁用通过 spice 使用的虚拟机客户机的自动 USB 设备重定向,请使用

--spice-disable-auto-usbredir参数启动virt-manager,或运行以下命令以永久更改默认行为:>dconf write /org/virt-manager/virt-manager/console/auto-redirect falsevirt-viewer(软件包:virt-viewer)虚拟机客户机图形控制台的查看器。它使用 SPICE(默认在虚拟机客户机上配置)或 VNC 协议,并支持 TLS 和 x509 证书。可以通过名称、ID 或 UUID 访问虚拟机客户机。如果客户机尚未运行,可以在尝试连接控制台之前让查看器等待客户机启动。

virt-viewer默认未安装,在安装virt-viewer软件包后可用。注意

要禁用通过 spice 使用的虚拟机客户机的自动 USB 设备重定向,请使用

--spice-usbredir-auto-redirect-filter=''参数添加一个空过滤器。yast2 vm(软件包:yast2-vm)一个 YaST 模块,用于简化虚拟化工具的安装并可以设置网络桥接。

您可以通过以下任一方式安装运行虚拟机主机服务器所需的虚拟化工具:

在虚拟机主机服务器上安装 openSUSE Leap 时选择特定的系统角色

在已安装并运行的 openSUSE Leap 上运行YaST 虚拟化模块。

在已安装并运行的 openSUSE Leap 上安装特定的安装模式。

您可以在安装 openSUSE Leap 到虚拟机主机服务器的过程中安装所有必需的虚拟化工具。在安装过程中,您会看到屏幕。

图 6.1: 系统角色屏幕 #

在这里,您可以选择或角色。相应的软件选择和设置会在 openSUSE Leap 安装期间自动执行。

提示

两种虚拟化系统角色都会创建一个专用的 /var/lib/libvirt 分区,并启用 firewalld 和 Kdump 服务。

根据虚拟机主机服务器上 openSUSE Leap 的安装范围,您的系统上可能未安装任何虚拟化工具。当使用YaST 虚拟化模块配置虚拟机监控程序时,它们会自动安装。

提示

YaST 虚拟化模块包含在 yast2-vm 软件包中。在安装虚拟化组件之前,请验证它是否已在虚拟机主机服务器上安装。

过程 6.1: 安装 KVM 环境 #

要安装 KVM 虚拟化环境及相关工具,请按以下步骤操作:

启动 YaST 并选择 › 。

选择以最小化安装 QEMU 和 KVM 环境。如果您想使用基于

libvirt的管理堆栈,请选择。然后按确认。YaST 会询问是否自动在虚拟机主机服务器上配置网络桥接。它确保虚拟机客户机具有正确的网络功能。选择以同意,否则选择。

设置完成后,您可以开始创建和配置虚拟机客户机。无需重启虚拟机主机服务器。

过程 6.2: 安装 Xen 环境 #

要安装 Xen 虚拟化环境,请按以下步骤操作:

启动 YaST 并选择 › 。

选择以最小化安装 Xen 环境。如果您想使用基于

libvirt的管理堆栈,请选择。然后按确认。YaST 会询问是否自动在虚拟机主机服务器上配置网络桥接。它确保虚拟机客户机具有正确的网络功能。选择以同意,否则选择。

设置完成后,您需要重启机器以使用Xen 内核。

提示:默认启动内核

如果一切按预期工作,请使用 YaST 更改默认启动内核,并将 Xen 内核设置为默认。有关更改默认内核的更多信息,请参阅《参考》一书,第 12 章,“引导加载程序 GRUB 2”,第 12.3 节,“使用 YaST 配置引导加载程序”

来自 openSUSE Leap 软件存储库的相关软件包被组织成安装模式。您可以使用这些模式在已运行的 openSUSE Leap 上安装特定的虚拟化组件。使用 zypper 安装它们:

zypper install -t pattern PATTERN_NAME

要安装 KVM 环境,请考虑以下模式:

kvm_server安装带有 KVM 和 QEMU 环境的基本虚拟机主机服务器。

kvm_tools安装用于在 KVM 环境中管理和监视虚拟机客户机的

libvirt工具。

要安装 Xen 环境,请考虑以下模式:

xen_server安装基本 Xen 虚拟机主机服务器。

xen_tools安装用于在 Xen 环境中管理和监视虚拟机客户机的

libvirt工具。

注意

我们仅在 AMD64/Intel 64 客户机上支持 UEFI 安全启动。KVM 客户机通过使用 OVMF 固件支持 UEFI 安全启动。Xen HVM 客户机也支持从 OVMF 固件启动,但它们不支持 UEFI 安全启动。

UEFI 支持由OVMF(Open Virtual Machine Firmware)提供。要启用 UEFI 启动,请首先安装qemu-ovmf-x86_64或qemu-uefi-aarch64软件包,具体取决于客户机的架构。

虚拟机使用的固件是自动选择的。自动选择基于上述固件包中的 JSON 文件。libvirt QEMU 驱动程序在加载时会解析这些文件,以了解多种固件类型的能力。然后,当用户选择固件类型和任何所需功能(例如,UEFI 安全启动支持)时,libvirt 可以找到满足用户要求的固件文件。

例如,要指定带有 UEFI 安全启动的 EFI,请使用以下配置:

<os firmware='efi'> <loader secure='yes'/> </os>

qemu-ovmf-x86_64软件包包含以下重要的 UEFI 固件映像。它们为虚拟机客户机提供 UEFI 安全启动功能:

#rpm -ql qemu-ovmf-x86_64[...] /usr/share/qemu/ovmf-x86_64-smm-ms-code.bin /usr/share/qemu/ovmf-x86_64-smm-ms-vars.bin /usr/share/qemu/ovmf-x86_64-smm-opensuse-code.bin /usr/share/qemu/ovmf-x86_64-smm-opensuse-vars.bin /usr/share/qemu/ovmf-x86_64-smm-suse-code.bin /usr/share/qemu/ovmf-x86_64-smm-suse-vars.bin [...]

要为 SUSE Linux Enterprise 客户机使用 UEFI 安全启动,请使用

ovmf-x86_64-smm-suse-code.bin固件。要为 openSUSE 客户机使用 UEFI 安全启动,请使用

ovmf-x86_64-smm-opensuse-code.bin固件。要为 Microsoft Windows 客户机使用 UEFI 安全启动,请使用

ovmf-x86_64-smm-ms-code.bin固件。

对于 AArch64 架构,软件包名为 qemu-uefi-aarch32。

#rpm -ql qemu-uefi-aarch32[...] /usr/share/qemu/aavmf-aarch32-code.bin /usr/share/qemu/aavmf-aarch32-vars.bin /usr/share/qemu/firmware /usr/share/qemu/firmware/60-aavmf-aarch32.json /usr/share/qemu/qemu-uefi-aarch32.bin

文件名 *-code.bin 是 UEFI 固件文件。文件名 *-vars.bin 是相应的变量存储映像,可用作每个 VM 非易失性存储的模板。libvirt 在首次创建 VM 时,会将指定的 vars 模板复制到 /var/lib/libvirt/qemu/nvram/ 下的每个 VM 路径。文件名中不包含 code 或 vars 的文件可用作单个 UEFI 映像。它们不太有用,因为 VM 每次重启后 UEFI 变量都不会持久化。

文件名 *-ms*.bin 文件包含真实硬件上的 UEFI CA 密钥。因此,它们在 libvirt 中被配置为默认值。同样,文件名 *-suse*.bin 文件包含预装的 SUSE 密钥。还有一组不包含预装密钥的文件。

有关详细信息,请参阅 使用 UEFI 安全启动 和 http://www.linux-kvm.org/downloads/lersek/ovmf-whitepaper-c770f8c.txt。

重要:技术预览

KVM 的嵌套虚拟化仍处于技术预览阶段。它仅用于测试目的,不提供支持。

嵌套客户机是在 KVM 客户机中运行的 KVM 客户机。在描述嵌套客户机时,我们使用以下虚拟化层:

- L0

运行 KVM 的裸金属主机。

- L1

运行在 L0 上的虚拟机。因为它还可以运行另一个 KVM,所以它被称为客户机虚拟机监控程序。

- L2

运行在 L1 上的虚拟机。它被称为嵌套客户机。

嵌套虚拟化有许多优点。您可以在以下场景中受益:

在云环境中直接使用您选择的虚拟机监控程序管理自己的虚拟机。

将虚拟机监控程序及其客户机虚拟机作为一个整体进行实时迁移。

注意

不支持嵌套虚拟机客户机的实时迁移。

用于软件开发和测试。

要临时启用嵌套,请删除模块并使用 KVM 模块参数nested重新加载它:

对于 Intel CPU,运行:

>sudomodprobe -r kvm_intel && modprobe kvm_intel nested=1对于 AMD CPU,运行:

>sudomodprobe -r kvm_amd && modprobe kvm_amd nested=1

要永久启用嵌套,请根据您的 CPU 在 /etc/modprobe.d/kvm_*.conf 文件中启用 KVM 模块参数nested:

对于 Intel CPU,编辑

/etc/modprobe.d/kvm_intel.conf并添加以下行:options kvm_intel nested=1

对于 AMD CPU,编辑

/etc/modprobe.d/kvm_amd.conf并添加以下行:options kvm_amd nested=1

当您的 L0 主机具备嵌套能力后,您可以通过以下任一方式启动 L1 客户机:

使用 QEMU 命令行选项

-cpu host。将

vmx(Intel CPU)或svm(AMD CPU)CPU 功能添加到 QEMU 命令行选项-cpu中,该选项为虚拟 CPU 启用虚拟化。

如果您使用 VMware ESX 作为 KVM 裸金属虚拟机监控程序之上的客户机虚拟机监控程序,您可能会遇到不稳定的网络通信。此问题尤其发生在嵌套 KVM 客户机与 KVM 裸金属虚拟机监控程序或外部网络之间。嵌套 KVM 客户机的以下默认 CPU 配置导致了此问题:

<cpu mode='host-model' check='partial'/>

要修复它,请按照以下方式修改 CPU 配置:

[...] <cpu mode='host-passthrough' check='none'> <cache mode='passthrough'/> </cpu> [...]

- 7

libvirt守护进程 用于访问 KVM 或 Xen 的 libvirt 部署需要在一个或多个守护进程在主机上安装并激活。libvirt 提供了两种守护进程部署选项:整体式或模块化守护进程。libvirt 一直提供单一的整体式守护进程 libvirtd。它包括主要的虚拟机监控程序驱动…

- 8 准备 VM 主机服务器

在安装访客虚拟机之前,您需要准备 VM 主机服务器,以便为访客提供它们运行所需资源。具体来说,您需要配置

- 9 客户机安装

VM 访客由包含操作系统和数据文件的镜像以及描述 VM 访客虚拟硬件资源的配置文件组成。VM 访客托管在 VM 主机服务器上并由其控制。本节提供有关安装 VM 访客的通用说明。

- 10 基本的 VM 客户机管理

大多数管理任务,例如启动或停止 VM 客户机,都可以使用图形应用程序 Virtual Machine Manager 或在命令行中使用

virsh来完成。 只能从图形用户界面通过 VNC 连接到图形控制台。- 11 连接和授权

管理多个 VM 主机服务器,每个服务器托管多个 VM 访客,很快就会变得困难。

libvirt的一个好处是能够同时连接到多个 VM 主机服务器,从而提供一个用于管理所有 VM 访客并连接到其图形控制台的单一界面。- 12 高级存储主题

本章介绍有关从 VM 主机服务器的角度操作存储的高级主题。

- 13 使用虚拟机器管理器配置虚拟机

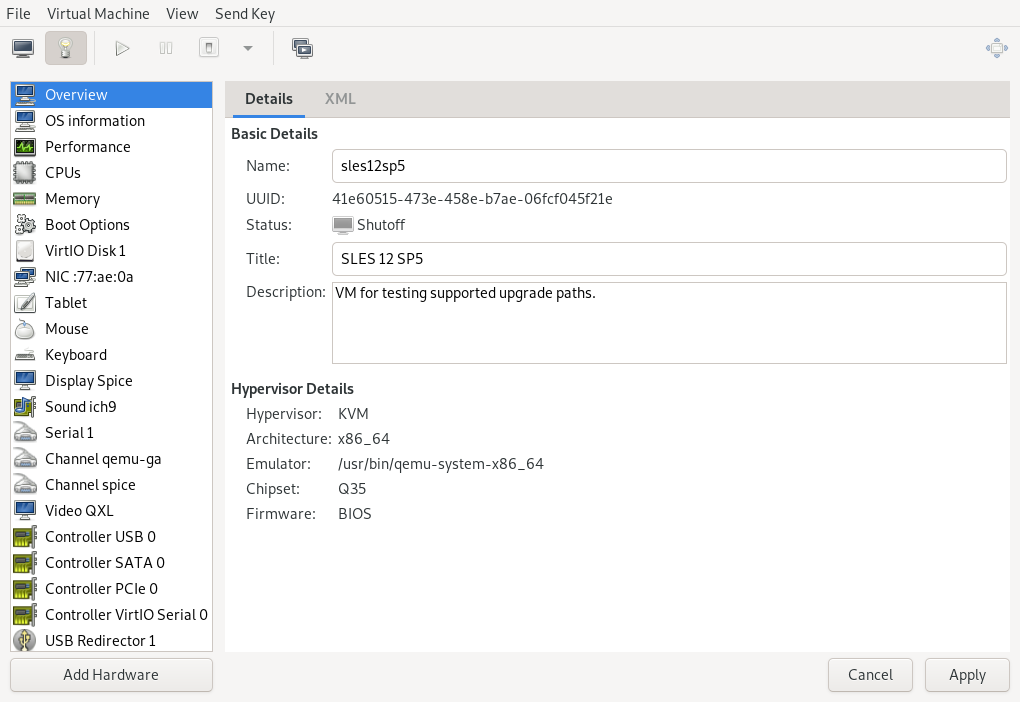

Virtual Machine Manager 的 视图提供有关 VM 访客完整配置和硬件设备的深入信息。使用此视图,您还可以更改访客配置或添加和修改虚拟硬件。要访问此视图,请在 Virtual Machine Manager 中打开访客的控制台,然后选择 › 从菜单中,或单击工具栏中的 。

- 14 使用

virsh配置虚拟机 您可以使用

virsh在命令行上配置虚拟机 (VM),作为使用 Virtual Machine Manager 的替代方法。使用virsh,您可以控制 VM 的状态、编辑 VM 的配置,甚至将 VM 迁移到另一个主机。以下部分介绍如何使用virsh管理 VM。- 15 Xen 到 KVM 迁移指南

随着 KVM 虚拟化解决方案在服务器管理员中越来越受欢迎,许多管理员需要一种路径将现有的基于 Xen 的环境迁移到 KVM。目前,还没有成熟的工具可以自动转换 Xen VM 到 KVM。然而,存在一个技术解决方案 th…

用于访问 KVM 或 Xen 的 libvirt 部署需要在主机上安装并激活一个或多个守护进程。libvirt 提供了两种守护进程部署选项:整体式或模块化守护进程。libvirt 一直提供单一的整体式守护进程 libvirtd。它包括主要的虚拟机监控程序驱动程序以及所有所需的二级驱动程序,如存储、网络、节点设备和管理。libvirtd 整体式守护进程还为外部客户端提供安全的远程访问。使用模块化守护进程时,每个驱动程序运行在自己的守护进程中,允许用户自定义其 libvirt 部署。默认情况下,整体式守护进程是启用的,但可以通过管理相应的 systemd 服务文件将部署切换到模块化守护进程。

模块化守护进程部署在只需要最少 libvirt 支持的场景中很有用。例如,如果虚拟机存储和网络不由 libvirt 提供,则不需要 libvirt-daemon-driver-storage 和 libvirt-daemon-driver-network 这类软件包。Kubernetes 是一个极端示例,它处理所有网络、存储、cgroups 和命名空间集成等。只需要安装提供 virtqemud 的 libvirt-daemon-driver-QEMU 软件包。模块化守护进程允许配置一个自定义的 libvirt 部署,其中仅包含用例所需的组件。

整体式守护进程称为 libvirtd,并通过 /etc/libvirt/libvirtd.conf 进行配置。libvirtd 使用多个 systemd 单元文件进行管理:

libvirtd.service - 用于启动

libvirtd的主systemd单元文件。如果虚拟机也配置为在主机启动时启动,我们建议配置libvirtd.service在启动时自动启动。libvirtd.socket - 与主读写 UNIX 套接字

/var/run/libvirt/libvirt-sock对应的单元文件。我们建议在启动时启用此单元。libvirtd-ro.socket - 与主只读 UNIX 套接字

/var/run/libvirt/libvirt-sock-ro对应的单元文件。我们建议在启动时启用此单元。libvirtd-admin.socket - 与管理 UNIX 套接字

/var/run/libvirt/libvirt-admin-sock对应的单元文件。我们建议在启动时启用此单元。libvirtd-tcp.socket - 用于非 TLS 远程访问的 TCP 16509 端口的单元文件。在管理员配置了适当的身份验证机制之前,不应在启动时配置此单元。

libvirtd-tls.socket - 用于 TLS 远程访问的 TCP 16509 端口的单元文件。在管理员部署了 x509 证书并可选地配置了适当的身份验证机制之前,不应在启动时配置此单元。

当使用 systemd 套接字激活时,libvirtd.conf 中的某些配置设置不再生效。相反,这些设置必须通过系统单元文件进行控制:

listen_tcp - 通过启动

libvirtd-tcp.socket单元文件来启用 TCP 套接字使用。listen_tls - 通过启动

libvirtd-tls.socket单元文件来启用 TLS 套接字使用。tcp_port - 非 TLS TCP 套接字端口,通过

libvirtd-tcp.socket单元文件中的ListenStream参数控制。tls_port - TLS TCP 套接字端口,通过

libvirtd-tls.socket单元文件中的ListenStream参数控制。listen_addr - 要监听的 IP 地址,通过

libvirtd-tcp.socket或libvirtd-tls.socket单元文件中的ListenStream参数独立控制。unix_sock_group - UNIX 套接字组所有者,通过

libvirtd.socket和libvirtd-ro.socket单元文件中的SocketGroup参数控制。unix_sock_ro_perms - 只读 UNIX 套接字权限,通过

libvirtd-ro.socket单元文件中的SocketMode参数控制。unix_sock_rw_perms - 读写 UNIX 套接字权限,通过

libvirtd.socket单元文件中的SocketMode参数控制。unix_sock_admin_perms - 管理 UNIX 套接字权限,通过

libvirtd-admin.socket单元文件中的SocketMode参数控制。unix_sock_dir - 创建所有 UNIX 套接字的目录,通过

libvirtd.socket、libvirtd-ro.socket和libvirtd-admin.socket单元文件中的ListenStream参数独立控制。

重要:冲突服务:libvirtd 和 xendomains

如果 libvirtd 启动失败,请检查服务 xendomains 是否已加载。

> systemctl is-active xendomains active如果命令返回active,则在启动 libvirtd 守护进程之前,您需要停止 xendomains。如果您希望 libvirtd 在重启后也自动启动,请另外阻止 xendomains 自动启动。禁用该服务:

>sudosystemctl stop xendomains>sudosystemctl disable xendomains>sudosystemctl start libvirtd

xendomains 和 libvirtd 提供相同服务,并且并行使用时可能会相互干扰。例如,xendomains 可能会尝试启动 libvirtd 已经启动的 domU。

模块化守护进程以其运行的驱动程序的名称命名,模式为“virtDRIVERd”。它们通过文件 /etc/libvirt/virtDRIVERd.conf 进行配置。SUSE 支持 virtqemud 和 virtxend 虚拟机监控程序守护进程,以及所有支持的二级守护进程:

virtnetworkd - 提供

libvirt虚拟网络管理 API 的虚拟网络管理守护进程。例如,virtnetworkd 可用于在主机上创建 NAT 虚拟网络供虚拟机使用。virtnodedevd - 提供

libvirt节点设备管理 API 的主机物理设备管理守护进程。例如,virtnodedevd 可用于将 PCI 设备从主机分离出来供虚拟机使用。virtnwfilterd - 提供

libvirt防火墙管理 API 的主机防火墙管理守护进程。例如,virtnwfilterd 可用于配置虚拟机的网络流量过滤规则。virtsecretd - 提供

libvirt密钥管理 API 的主机密钥管理守护进程。例如,virtsecretd 可用于存储与 LUKs 卷关联的密钥。virtstoraged - 提供

libvirt存储管理 API 的主机存储管理守护进程。virtstoraged 可用于创建存储池并从这些池中创建卷。virtinterfaced - 提供

libvirt主机网络接口管理 API 的主机 NIC 管理守护进程。例如,virtinterfaced 可用于在主机上创建绑定网络设备。SUSE 不推荐使用libvirt的接口管理 API,而是推荐使用 wicked 或 NetworkManager 等默认网络工具。建议禁用 virtinterfaced。virtproxyd - 一个用于在传统

libvirtd套接字和模块化守护进程套接字之间代理连接的守护进程。使用模块化libvirt部署时,virtproxyd 允许远程客户端访问libvirtAPI,类似于整体式libvirtd。它也可以供连接到整体式libvirtd套接字进行本地访问的本地客户端使用。virtlogd - 一个用于管理虚拟机控制台日志的守护进程。整体式

libvirtd也使用 virtlogd。整体式守护进程和 virtqemudsystemd单元文件需要 virtlogd,因此无需显式启动 virtlogd。virtlockd - 一个用于管理虚拟机资源(如磁盘)锁定的守护进程。整体式

libvirtd也使用 virtlockd。整体式守护进程、virtqemud 和 virtxendsystemd单元文件需要 virtlockd,因此无需显式启动 virtlockd。

libvirt 包含两个模块化守护进程,它们也被整体式 libvirtd 使用:virtlockd 和 virtlogd。

默认情况下,模块化守护进程在 /var/run/libvirt/virtDRIVERd-sock 和 /var/run/libvirt/virtDRIVERd-sock-ro Unix 域套接字上监听连接。客户端库优先使用这些套接字,而不是传统的 /var/run/libvirt/libvirtd-sock。virtproxyd 守护进程可用于远程客户端或期望传统 libvirtd 套接字的本地客户端。

与整体式守护进程类似,模块化守护进程使用多个 systemd 单元文件进行管理:

virtDRIVERd.service - 用于启动 virtDRIVERd 守护进程的主单元文件。如果虚拟机也配置为在主机启动时启动,我们建议将该服务配置为在启动时自动启动。

virtDRIVERd.socket - 与主读写 UNIX 套接字

/var/run/libvirt/virtDRIVERd-sock对应的单元文件。我们建议默认在启动时启动此套接字。virtDRIVERd-ro.socket - 与主只读 UNIX 套接字

/var/run/libvirt/virtDRIVERd-sock-ro对应的单元文件。我们建议默认在启动时启动此套接字。virtDRIVERd-admin.socket - 与管理 UNIX 套接字

/var/run/libvirt/virtDRIVERd-admin-sock对应的单元文件。我们建议默认在启动时启动此套接字。

当使用 systemd 套接字激活时,virtDRIVERd.conf 中的几个配置设置不再生效。相反,这些设置必须通过系统单元文件进行控制:

unix_sock_group - UNIX 套接字组所有者,通过

virtDRIVERd.socket和virtDRIVERd-ro.socket单元文件中的SocketGroup参数控制。unix_sock_ro_perms - 只读 UNIX 套接字权限,通过

virtDRIVERd-ro.socket单元文件中的SocketMode参数控制。unix_sock_rw_perms - 读写 UNIX 套接字权限,通过

virtDRIVERd.socket单元文件中的SocketMode参数控制。unix_sock_admin_perms - 管理 UNIX 套接字权限,通过

virtDRIVERd-admin.socket单元文件中的SocketMode参数控制。unix_sock_dir - 创建所有 UNIX 套接字的目录,通过

virtDRIVERd.socket、virtDRIVERd-ro.socket和virtDRIVERd-admin.socket单元文件中的ListenStream参数独立控制。

在整体式和模块化守护进程之间切换时,需要更改多个服务。建议在切换守护进程选项之前停止或驱逐任何正在运行的虚拟机。

停止整体式守护进程及其套接字:

>sudosystemctl stop libvirtd.service>sudosystemctl stop libvirtd{,-ro,-admin}.socket禁用整体式守护进程的未来启动:

>sudosystemctl disable libvirtd.service>sudosystemctl disable libvirtd{,-ro,-admin}.socket启用 KVM 或 Xen 的新守护进程,包括所需的二级驱动程序。以下示例启用了 KVM 的 QEMU 驱动程序以及所有必需的二级驱动程序:

for drv in qemu network nodedev nwfilter secret storage do

>sudosystemctl enable virt${drv}d.service>sudosystemctl enable virt${drv}d{,-ro,-admin}.socket done启动同一组守护进程的套接字

for drv in qemu network nodedev nwfilter secret storage do

>sudosystemctl start virt${drv}d{,-ro,-admin}.socket done如果需要支持来自远程主机的连接,则必须启用并启动 virtproxyd 守护进程

>sudosystemctl enable virtproxyd.service>sudosystemctl enable virtproxyd{,-ro,-admin}.socket>sudosystemctl start virtproxyd{,-ro,-admin}.socket

在安装访客虚拟机之前,您需要准备 VM 主机服务器,以便为访客提供它们运行所需资源。具体来说,您需要配置

网络,以便虚拟机可以使用主机提供的网络连接。

主机可访问的 存储池,以便虚拟机可以存储其磁盘映像。

提供虚拟机连接到网络的两种常见配置

网络桥接。这是为虚拟机提供网络连接的默认且推荐的方式。

启用转发的虚拟网络。

网络桥接配置为主机提供了一个二层交换机,用于虚拟机,该交换机根据与桥接端口关联的 MAC 地址在桥接端口之间切换二层以太网数据包。这使得虚拟机能够访问主机服务器的网络。此配置类似于将虚拟机虚拟以太网电缆连接到与主机和其他在主机上运行的虚拟机共享的集线器。此配置通常被称为共享物理设备。

网络桥接配置是openSUSE Leap在配置为 KVM 或 Xen hypervisor 时的默认配置。当您只想将虚拟机连接到主机服务器的 LAN 时,这是首选配置。

使用哪种工具创建网络桥接取决于您用于管理虚拟机主机服务器上网络连接的服务

如果网络连接由

wicked管理,请使用 YaST 或命令行来创建网络桥接。wicked是服务器主机上的默认设置。如果网络连接由 NetworkManager 管理,请使用 NetworkManager 命令行工具

nmcli创建网络桥接。NetworkManager 是桌面和笔记本电脑上的默认设置。

本节包括使用 YaST 添加或删除网络桥接的过程。

要在虚拟机主机服务器上添加网络桥接,请按照以下步骤操作

启动 › › 。

激活 选项卡,然后单击 。

从 列表中选择 ,并在 条目中输入桥接设备接口名称。单击 按钮继续。

在 选项卡中,指定网络详细信息,例如 DHCP/静态 IP 地址、子网掩码或主机名。

仅当还为连接到 DHCP 服务器的桥接分配设备时,使用 才有用。

如果您打算创建一个与真实网络设备无关的虚拟桥接,请使用 。在这种情况下,最好使用私有 IP 地址范围内的地址,例如,

192.168.0.0/16、172.16.0.0/12或10.0.0.0/8。要创建仅用作不同虚拟机之间连接而与主机系统无关的桥接,请将 IP 地址设置为

0.0.0.0,并将子网掩码设置为255.255.255.255。网络脚本将此特殊地址处理为未设置的 IP 地址。激活 选项卡,并激活您要包含在网络桥接中的网络设备。

单击 返回 选项卡,然后单击 进行确认。新的网络桥接现在应在虚拟机主机服务器上处于活动状态。

本节包括使用命令行添加或删除网络桥接的过程。

要在虚拟机主机服务器上添加新的网络桥接设备,请按照以下步骤操作

以

root用户身份登录到您要创建新网络桥接的虚拟机主机服务器。为新桥接选择一个名称—在我们的示例中是virbr_test—然后运行

#ip link add name VIRBR_TEST type bridge检查桥接是否已在虚拟机主机服务器上创建

#bridge vlan [...] virbr_test 1 PVID Egress Untaggedvirbr_test存在,但未与任何物理网络接口关联。启动网络桥接并将网络接口添加到桥接

#ip link set virbr_test up#ip link set eth1 master virbr_test重要提示:网络接口必须未使用

您只能分配一个尚未被其他网络桥接使用的网络接口。

可选地,启用 STP(参见 生成树协议)

#bridge link set dev virbr_test cost 4

本节包括使用 NetworkManager 的命令行工具 nmcli 添加网络桥接的过程。

列出活动的网络连接

>sudonmcli connection show --active NAME UUID TYPE DEVICE Ethernet connection 1 84ba4c22-0cfe-46b6-87bb-909be6cb1214 ethernet eth0添加一个名为

br0的新桥接设备并验证其创建>sudonmcli connection add type bridge ifname br0 Connection 'bridge-br0' (36e11b95-8d5d-4a8f-9ca3-ff4180eb89f7) \ successfully added.>sudonmcli connection show --active NAME UUID TYPE DEVICE bridge-br0 36e11b95-8d5d-4a8f-9ca3-ff4180eb89f7 bridge br0 Ethernet connection 1 84ba4c22-0cfe-46b6-87bb-909be6cb1214 ethernet eth0可选地,您可以查看桥接设置

>sudonmcli -f bridge connection show bridge-br0 bridge.mac-address: -- bridge.stp: yes bridge.priority: 32768 bridge.forward-delay: 15 bridge.hello-time: 2 bridge.max-age: 20 bridge.ageing-time: 300 bridge.group-forward-mask: 0 bridge.multicast-snooping: yes bridge.vlan-filtering: no bridge.vlan-default-pvid: 1 bridge.vlans: --将桥接设备链接到物理以太网设备

eth0>sudonmcli connection add type bridge-slave ifname eth0 master br0禁用

eth0接口并启用新桥接>sudonmcli connection down "Ethernet connection 1">sudonmcli connection up bridge-br0 Connection successfully activated (master waiting for slaves) \ (D-Bus active path: /org/freedesktop/NetworkManager/ActiveConnection/9)

有时需要创建私有连接,无论是连接两个虚拟机主机服务器之间,还是虚拟机系统之间。例如,将虚拟机迁移到不同网络段中的主机。或者创建一个虚拟机系统(即使它们运行在不同的虚拟机主机服务器系统上)才能连接的私有桥接。构建此类连接的简单方法是设置 VLAN 网络。

VLAN 接口通常在虚拟机主机服务器上设置。它们要么互连不同的虚拟机主机服务器系统,要么可以设置为物理接口,连接到一个完全虚拟化的桥接。甚至可以创建一个以 VLAN 作为物理接口的桥接,该桥接在虚拟机主机服务器上没有 IP 地址。这样,虚拟机系统就无法通过此网络访问主机。

运行 YaST 模块 › 。按照此过程设置 VLAN 设备

过程 8.1: 使用 YaST 设置 VLAN 接口 #

单击 以创建新的网络接口。

在 中,选择 。

更改 的值为您的 VLAN ID。请注意,VLAN ID

1通常用于管理目的。单击 。

在 下选择 VLAN 设备应连接到的接口。如果所需的接口未出现在列表中,请先设置该接口而不分配 IP 地址。

选择要为 VLAN 设备分配 IP 地址的首选方法。

单击 以完成配置。

还可以将 VLAN 接口用作桥接的物理接口。这使得连接多个仅限虚拟机主机服务器的网络成为可能,并允许对连接到此类网络的虚拟机系统进行实时迁移。

YaST 并不总是允许设置无 IP 地址。但是,这可能是一个期望的功能,尤其是在应该连接仅限虚拟机主机服务器的网络时。在这种情况下,使用特殊地址 0.0.0.0 和 netmask 255.255.255.255。系统脚本将此地址处理为未设置 IP 地址。

libvirt 管理的虚拟网络类似于桥接网络,但通常与虚拟机主机服务器没有二层连接。通过三层转发实现与虚拟机主机服务器物理网络的连接,与二层桥接网络相比,这在虚拟机主机服务器上引入了额外的报文处理。虚拟网络还为虚拟机提供 DHCP 和 DNS 服务。有关 libvirt 虚拟网络的更多信息,请参阅 https://libvirt.org/formatnetwork.html 上的网络 XML 格式文档。

openSUSE Leap 上的标准 libvirt 安装已预定义了一个名为 default 的虚拟网络。它为网络提供 DHCP 和 DNS 服务,并使用网络地址转换 (NAT) 转发模式连接到虚拟机主机服务器的物理网络。尽管它是预定义的,但 default 虚拟网络需要由管理员显式启用。有关 libvirt 支持的转发模式的更多信息,请参阅 https://libvirt.org/formatnetwork.html#elementsConnect 上的 网络 XML 格式文档的连接部分。

libvirt 管理的虚拟网络可用于满足广泛的用例,但通常用于具有无线连接或动态/零星网络连接(如笔记本电脑)的虚拟机主机服务器。当虚拟机主机服务器的网络 IP 地址有限时,虚拟网络也很有用,它允许在虚拟网络和虚拟机主机服务器的网络之间转发数据包。然而,大多数服务器用例更适合网络桥接配置,其中虚拟机连接到虚拟机主机服务器的 LAN。

警告:启用转发模式

在 libvirt 虚拟网络中启用转发模式会通过将 /proc/sys/net/ipv4/ip_forward 和 /proc/sys/net/ipv6/conf/all/forwarding 设置为 1 来在虚拟机主机服务器中启用转发,这会将虚拟机主机服务器变成路由器。重新启动虚拟机主机服务器的网络可能会重置值并禁用转发。为避免此行为,请通过编辑 /etc/sysctl.conf 文件并添加以下内容来显式启用虚拟机主机服务器中的转发

net.ipv4.ip_forward = 1

net.ipv6.conf.all.forwarding = 1

您可以使用虚拟机管理器定义、配置和操作虚拟网络。

启动虚拟机管理器。在可用连接列表中,右键单击需要配置虚拟网络连接的名称,然后选择 。

在 窗口中,单击 选项卡。您可以看到当前连接的所有可用虚拟网络的列表。右侧显示所选虚拟网络的详细信息。

图 8.1: 连接详细信息 #

要添加新的虚拟网络,请单击 。

为新虚拟网络指定一个名称。

图 8.2: 创建虚拟网络 #

指定网络模式。对于 和 类型,您可以指定将网络通信转发到哪个设备。(网络地址转换)重新映射虚拟网络地址空间并允许共享单个 IP 地址,而 则将数据包从虚拟网络转发到虚拟机主机服务器的物理网络,不进行转换。

如果您需要 IPv4 网络,请激活 并指定 IPv4 网络地址。如果您需要 DHCP 服务器,请激活 并指定可分配的 IP 地址范围。

如果您需要 IPv6 网络,请激活 并指定 IPv6 网络地址。如果您需要 DHCP 服务器,请激活 并指定可分配的 IP 地址范围。

要指定与虚拟网络名称不同的域名,请选择 在 下,并在此处输入。

单击 以创建新的虚拟网络。在虚拟机主机服务器上,将有一个新的虚拟网络桥接

virbrX,它对应于新创建的虚拟网络。您可以使用bridge link进行检查。libvirt会自动添加 iptables 规则,以允许与新virbrX设备连接的虚拟机之间以及它们之间的流量。

要启动临时停止的虚拟网络,请按照以下步骤操作

启动虚拟机管理器。在可用连接列表中,右键单击需要配置虚拟网络连接的名称,然后选择 。

在 窗口中,单击 选项卡。您可以看到当前连接的所有可用虚拟网络的列表。

要启动虚拟网络,请单击 。

要停止活动的虚拟网络,请按照以下步骤操作

启动虚拟机管理器。在可用连接列表中,右键单击需要配置虚拟网络连接的名称,然后选择 。

在 窗口中,单击 选项卡。您可以看到当前连接的所有可用虚拟网络的列表。

选择要停止的虚拟网络,然后单击 。

要从虚拟机主机服务器删除虚拟网络,请按照以下步骤操作

启动虚拟机管理器。在可用连接列表中,右键单击需要配置虚拟网络连接的名称,然后选择 。

在 窗口中,单击 选项卡。您可以看到当前连接的所有可用虚拟网络的列表。

选择要删除的虚拟网络,然后单击 。

在虚拟机主机服务器上,安装 libvirt-nss,它提供 libvirt 的 NSS 支持

>sudozypper in libvirt-nss将

libvirt添加到/etc/nsswitch.conf... hosts: files libvirt mdns_minimal [NOTFOUND=return] dns ...

如果 NSCD 正在运行,请重新启动它

>sudosystemctl restart nscd

现在您可以从主机通过名称访问虚拟机系统。

NSS 模块功能有限。它读取 /var/lib/libvirt/dnsmasq/*.status 文件以查找 JSON 记录中的主机名和相应 IP 地址,该记录描述了 dnsmasq 提供的每个租约。主机名转换只能在那些使用由 dnsmasq 支持的 libvirt 管理的桥接网络的虚拟机主机服务器上完成。

您可以使用 virsh 命令行工具管理 libvirt 提供的虚拟网络。要查看所有与网络相关的 virsh 命令,请运行

>sudovirsh help network Networking (help keyword 'network'): net-autostart autostart a network net-create create a network from an XML file net-define define (but don't start) a network from an XML file net-destroy destroy (stop) a network net-dumpxml network information in XML net-edit edit XML configuration for a network net-event Network Events net-info network information net-list list networks net-name convert a network UUID to network name net-start start a (previously defined) inactive network net-undefine undefine an inactive network net-update update parts of an existing network's configuration net-uuid convert a network name to network UUID

要查看特定 virsh 命令的简要帮助信息,请运行 virsh help VIRSH_COMMAND

>sudovirsh help net-create NAME net-create - create a network from an XML file SYNOPSIS net-create <file> DESCRIPTION Create a network. OPTIONS [--file] <string> file containing an XML network description

要创建新的正在运行的虚拟网络,请运行

>sudovirsh net-create VNET_DEFINITION.xml

VNET_DEFINITION.xml XML 文件包含 libvirt 接受的虚拟网络的定义。

要定义新虚拟网络而不激活它,请运行

>sudovirsh net-define VNET_DEFINITION.xml

以下示例说明了不同类型的虚拟网络的定义。

示例 8.1: 基于 NAT 的网络 #

以下配置允许虚拟机在虚拟机主机服务器上有可用连接的情况下进行出站连接。如果没有虚拟机主机服务器网络,它允许虚拟机直接相互通信。

<network> <name>vnet_nated</name>1 <bridge name="virbr1"/>2 <forward mode="nat"/>3 <ip address="192.168.122.1" netmask="255.255.255.0">4 <dhcp> <range start="192.168.122.2" end="192.168.122.254"/>5 <host mac="52:54:00:c7:92:da" name="host1.testing.com" \ ip="192.168.1.101"/>6 <host mac="52:54:00:c7:92:db" name="host2.testing.com" \ ip="192.168.1.102"/> <host mac="52:54:00:c7:92:dc" name="host3.testing.com" \ ip="192.168.1.103"/> </dhcp> </ip> </network>

新虚拟网络的名称。 | |

用于构建虚拟网络的桥接设备的名称。当使用 | |

包含 <forward> 元素表示虚拟网络已连接到物理 LAN。 | |

网络桥接的 IP 地址和子网掩码。 | |

为虚拟网络启用 DHCP 服务器,提供指定 | |

<host> 可选元素指定了由内置 DHCP 服务器赋予名称和预定义 IP 地址的主机。任何 IPv4 主机元素都必须指定以下内容:要分配给定名称的主机的 MAC 地址、要分配给该主机、以及 DHCP 服务器要为该主机分配的名称。IPv6 主机元素与 IPv4 的略有不同:没有 |

示例 8.2: 路由网络 #

以下配置将流量从虚拟网络路由到 LAN,而无需应用任何 NAT。IP 地址范围必须预先配置在虚拟机主机服务器网络上的路由器的路由表中。

<network>

<name>vnet_routed</name>

<bridge name="virbr1"/>

<forward mode="route" dev="eth1"/>1

<ip address="192.168.122.1" netmask="255.255.255.0">

<dhcp>

<range start="192.168.122.2" end="192.168.122.254"/>

</dhcp>

</ip>

</network>虚拟机流量只能通过虚拟机主机服务器上的 |

示例 8.3: 隔离网络 #

此配置提供了一个隔离的私有网络。虚拟机可以相互通信,也可以与虚拟机主机服务器通信,但无法到达 LAN 上的任何其他计算机,因为 XML 描述中缺少 <forward> 元素。

<network> <name>vnet_isolated</name> <bridge name="virbr3"/> <ip address="192.168.152.1" netmask="255.255.255.0"> <dhcp> <range start="192.168.152.2" end="192.168.152.254"/> </dhcp> </ip> </network>

示例 8.4: 使用虚拟机主机服务器上的现有桥接 #

此配置显示了如何使用虚拟机主机服务器上的现有网络桥接 br0。虚拟机直接连接到物理网络。它们的 IP 地址都在物理网络的子网上,并且对传入或传出连接没有限制。

<network>

<name>host-bridge</name>

<forward mode="bridge"/>

<bridge name="br0"/>

</network>要列出 libvirt 可用的所有虚拟网络,请运行

>sudovirsh net-list --all Name State Autostart Persistent ---------------------------------------------------------- crowbar active yes yes vnet_nated active yes yes vnet_routed active yes yes vnet_isolated inactive yes yes

要列出可用的域,请运行

>sudovirsh list Id Name State ---------------------------------------------------- 1 nated_sles12sp3 running ...

要获取正在运行的域的接口列表,请运行 domifaddr DOMAIN,或选择性地指定接口以限制输出到该接口。默认情况下,它还会输出其 IP 和 MAC 地址

>sudovirsh domifaddr nated_sles12sp3 --interface vnet0 --source lease Name MAC address Protocol Address ------------------------------------------------------------------------------- vnet0 52:54:00:9e:0d:2b ipv6 fd00:dead:beef:55::140/64 - - ipv4 192.168.100.168/24

要打印与指定域关联的所有虚拟接口的简要信息,请运行

>sudovirsh domiflist nated_sles12sp3 Interface Type Source Model MAC --------------------------------------------------------- vnet0 network vnet_nated virtio 52:54:00:9e:0d:2b

要获取有关网络的详细信息,请运行

>sudovirsh net-info vnet_routed Name: vnet_routed UUID: 756b48ff-d0c6-4c0a-804c-86c4c832a498 Active: yes Persistent: yes Autostart: yes Bridge: virbr5

要启动一个已定义的非活动网络,请使用以下命令查找其名称(或唯一标识符,UUID)

>sudovirsh net-list --inactive Name State Autostart Persistent ---------------------------------------------------------- vnet_isolated inactive yes yes

然后运行

>sudovirsh net-start vnet_isolated Network vnet_isolated started

要停止一个活动的网络,请使用以下命令查找其名称(或唯一标识符,UUID)

>sudovirsh net-list --inactive Name State Autostart Persistent ---------------------------------------------------------- vnet_isolated active yes yes

然后运行

>sudovirsh net-destroy vnet_isolated Network vnet_isolated destroyed

在虚拟机主机服务器本身上管理虚拟机时,您可以访问虚拟机主机服务器的完整文件系统,以附加或创建虚拟硬盘,或将现有映像附加到虚拟机。但是,从远程主机管理虚拟机时无法做到这一点。因此,libvirt 支持所谓的“存储池”,这些存储池可以从远程机器访问。

提示:CD/DVD ISO 映像

要能够从远程客户端访问虚拟机主机服务器上的 CD/DVD ISO 映像,它们也需要放置在存储池中。

libvirt 知道两种不同的存储类型:卷和池。

- 存储卷

存储卷是可分配给虚拟机的存储设备—虚拟磁盘或 CD/DVD/软盘映像。物理上,它可以是块设备—例如,分区或逻辑卷—或虚拟机主机服务器上的文件。

- 存储池

存储池是虚拟机主机服务器上的存储资源,可用于存储卷,类似于桌面机器的网络存储。物理上,它可以是以下类型之一

- 文件系统目录 ()

用于托管映像文件的目录。文件可以是支持的磁盘格式(raw 或 qcow2)之一,也可以是 ISO 映像。

- 物理磁盘设备 ()

使用完整的物理磁盘作为存储。为添加到池中的每个卷创建一个分区。

- 预格式化的块设备 ()

指定一个分区,该分区以与文件系统目录池相同的方式使用(用于托管映像文件的目录)。与使用文件系统目录的区别在于

libvirt负责挂载设备。- iSCSI 目标 (iscsi)

在 iSCSI 目标上设置池。您需要先登录卷一次才能将其与

libvirt一起使用。使用 YaST 检测和登录卷。不支持在 iSCSI 池上创建卷;相反,每个现有的逻辑单元号 (LUN) 都代表一个卷。每个卷/LUN 在使用之前也需要一个有效的(空)分区表或磁盘标签。如果缺失,请使用fdisk添加它>sudofdisk -cu /dev/disk/by-path/ip-192.168.2.100:3260-iscsi-iqn.2010-10.com.example:[...]-lun-2 Device contains neither a valid DOS partition table, nor Sun, SGI or OSF disklabel Building a new DOS disklabel with disk identifier 0xc15cdc4e. Changes will remain in memory only, until you decide to write them. After that, of course, the previous content won't be recoverable. Warning: invalid flag 0x0000 of partition table 4 will be corrected by w(rite) Command (m for help): w The partition table has been altered! Calling ioctl() to re-read partition table. Syncing disks.- LVM 卷组 (logical)

使用 LVM 卷组作为池。您可以使用预定义的卷组,或者通过指定要使用的设备来创建卷组。存储卷作为卷上的分区创建。

警告:删除基于 LVM 的池

在存储管理器中删除基于 LVM 的池时,卷组也会被删除。这将导致存储在池中的所有数据丢失,并且无法恢复。

- 多路径设备 ()

目前,多路径支持仅限于将现有设备分配给虚拟机。不支持在

libvirt中创建卷或配置多路径。- 网络导出的目录 ()

指定一个网络目录,该目录以与文件系统目录池相同的方式使用(用于托管映像文件的目录)。与使用文件系统目录的区别在于

libvirt负责挂载目录。支持的协议是 NFS。- SCSI 主机适配器 ()

使用 SCSI 主机适配器,其方式与 iSCSI 目标几乎相同。我们建议使用来自

/dev/disk/by-*的设备名称,而不是/dev/sdX。后者可能会更改(例如,在添加或删除硬盘时)。不支持在 iSCSI 池上创建卷。相反,每个现有的 LUN(逻辑单元号)代表一个卷。

警告:安全注意事项

为避免数据丢失或数据损坏,请勿尝试使用虚拟机主机服务器上用于构建存储池的 LVM 卷组、iSCSI 目标等资源。没有必要从虚拟机主机服务器连接到这些资源或在虚拟机主机服务器上挂载它们—libvirt 会处理这些。

不要按标签挂载虚拟机主机服务器上的分区。在某些情况下,有可能从虚拟机内部使用与虚拟机主机服务器上名称相同的名称来标记分区。

也可以通过使用 virsh 从命令行管理存储。但是,SUSE 目前不支持创建存储池。因此,本节仅限于记录启动、停止和删除池以及卷管理等功能。

通过运行 virsh help pool 和 virsh help volume 分别可以获得用于管理池和卷的所有 virsh 子命令的列表。

通过执行以下命令列出当前活动的所有池。要也列出非活动池,请添加选项 --all

> virsh pool-list --details有关特定池的详细信息可以通过 pool-info 子命令获得

> virsh pool-info POOL默认情况下,卷只能按池列出。要列出池中的所有卷,请输入以下命令。

> virsh vol-list --details POOL目前 virsh 不提供显示卷是否被虚拟机使用的工具。以下过程描述了一种列出当前被虚拟机使用的所有池中的卷的方法。

过程 8.2: 列出虚拟机主机服务器上当前使用的所有存储卷 #

创建一个 XSLT 样式表,将以下内容保存到一个文件中,例如,~/libvirt/guest_storage_list.xsl

<?xml version="1.0" encoding="UTF-8"?> <xsl:stylesheet version="1.0" xmlns:xsl="http://www.w3.org/1999/XSL/Transform"> <xsl:output method="text"/> <xsl:template match="text()"/> <xsl:strip-space elements="*"/> <xsl:template match="disk"> <xsl:text> </xsl:text> <xsl:value-of select="(source/@file|source/@dev|source/@dir)[1]"/> <xsl:text> </xsl:text> </xsl:template> </xsl:stylesheet>在 shell 中运行以下命令。假设虚拟机的 XML 定义都存储在默认位置(

/etc/libvirt/qemu)。xsltproc由libxslt包提供。SSHEET="$HOME/libvirt/guest_storage_list.xsl" cd /etc/libvirt/qemu for FILE in *.xml; do basename $FILE .xml xsltproc $SSHEET $FILE done

使用 virsh 池子命令启动、停止或删除池。在以下示例中,用池的名称或其 UUID 替换 POOL

- 停止池

>virsh pool-destroy POOL注意:池的状态不影响已附加的卷

池中的卷,即使已附加到虚拟机,也始终可用,无论池的状态如何((已停止)或(已启动))。池的状态仅影响通过远程管理将卷附加到虚拟机的能力。

- 删除池

>virsh pool-delete POOL- 启动池

>virsh pool-start POOL- 启用池自动启动

>virsh pool-autostart POOL只有标记为自动启动的池才会在虚拟机主机服务器重启时自动启动。

- 禁用池自动启动

>virsh pool-autostart POOL --disable

virsh 提供两种添加卷到存储池的方法:一种是使用 XML 定义,通过 vol-create 和 vol-create-from;另一种是通过命令行参数,使用 vol-create-as。前两种方法目前不被 SUSE 支持,因此本节将重点介绍 vol-create-as 子命令。

要将卷添加到现有池,请输入以下命令

> virsh vol-create-as POOL1NAME2 12G --format3raw|qcow24 --allocation 4G5要添加卷的池的名称 | |

卷的名称 | |

映像的大小,本例中为 12 GB。使用后缀 k、M、G、T 分别表示千字节、兆字节、千兆字节和太字节。 | |

卷的格式。SUSE 目前支持 | |

可选参数。默认情况下, 如果不指定此参数,则生成一个没有分配的稀疏映像文件。要创建非稀疏卷,请使用此参数指定整个映像大小(在本例中为 |

要将卷永久从池中删除,请使用子命令 vol-delete

> virsh vol-delete NAME --pool POOL

--pool 是可选的。libvirt 会尝试自动定位卷。如果失败,请指定此参数。

在创建卷(如第 8.2.1.3 节,“向存储池添加卷”中所述)后,您可以将其附加到虚拟机并用作硬盘

> virsh attach-disk DOMAIN SOURCE_IMAGE_FILE TARGET_DISK_DEVICE例如

> virsh attach-disk sles12sp3 /virt/images/example_disk.qcow2 sda2要检查新磁盘是否已附加,请检查 virsh dumpxml 命令的结果

# virsh dumpxml sles12sp3

[...]

<disk type='file' device='disk'>

<driver name='qemu' type='raw'/>

<source file='/virt/images/example_disk.qcow2'/>

<backingStore/>

<target dev='sda2' bus='scsi'/>

<alias name='scsi0-0-0'/>

<address type='drive' controller='0' bus='0' target='0' unit='0'/>

</disk>

[...]要从域中分离磁盘,请使用 virsh detach-disk

# virsh detach-disk DOMAIN TARGET_DISK_DEVICE例如

# virsh detach-disk sles12sp3 sda2您可以根据第 8.2.1.5 节,“将卷附加到虚拟机”中所述,使用 --live 和 --config 选项控制附件。

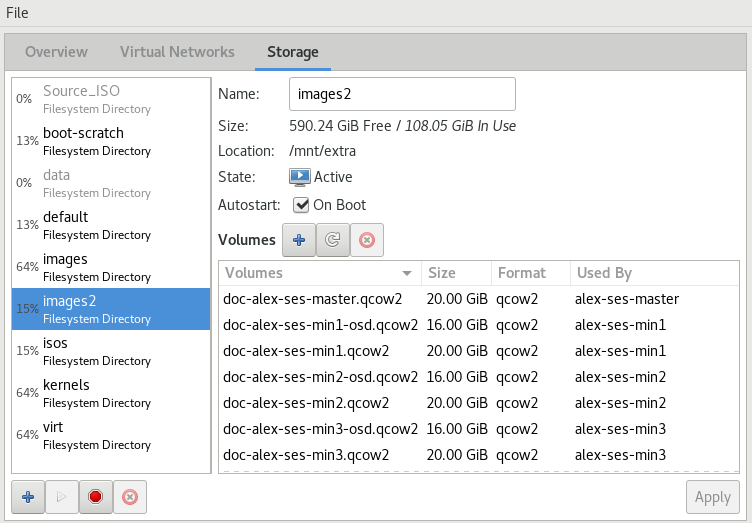

虚拟机管理器提供了一个图形界面—存储管理器—用于管理存储卷和池。要访问它,请右键单击连接并选择 ,或者突出显示一个连接并选择 › 。选择 选项卡。

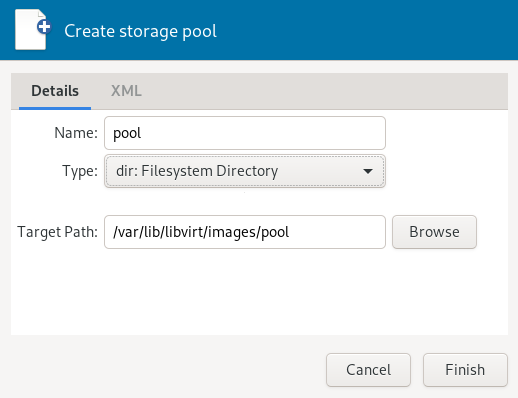

要添加存储池,请按以下步骤操作

单击左下角的 。将出现 对话框。

为池提供一个(仅包含字母数字字符和

_、-或.),然后选择一个。在下方指定所需的详细信息。它们取决于您创建的池类型。

重要提示

不支持 ZFS 池。

- 类型

:指定现有目录。

- 类型

:设备分区表的格式。通常使用 。如果不行,请通过在虚拟机主机服务器上运行命令

parted-l来获取所需的格式。:设备路径。建议使用来自

/dev/disk/by-*的设备名称,而不是简单的/dev/sdX,因为后者可能会更改(例如,在添加或删除硬盘时)。您需要指定类似于整个磁盘的路径,而不是磁盘上的分区(如果存在)。

- 类型

:虚拟机主机服务器文件系统上的挂载点。

设备的文件系统格式。默认值

auto应该有效。:设备文件的路径。建议使用来自

/dev/disk/by-*的设备名称,而不是/dev/sdX,因为后者可能会更改(例如,在添加或删除硬盘时)。

- 类型

在虚拟机主机服务器上运行以下命令以获取所需数据

>sudoiscsiadm --mode node它返回 iSCSI 卷列表,格式如下。粗体文本中的元素是必需的

IP_ADDRESS:PORT,TPGT TARGET_NAME_(IQN)

:包含设备文件的目录。使用

/dev/disk/by-path(默认)或/dev/disk/by-id。:iSCSI 服务器的主机名或 IP 地址。

:iSCSI 目标名称(iSCSI 限定名称)。

:iSCSI 发起方名称。

- 类型

:指定现有卷组的设备路径。

- 类型

:目前对多路径的支持仅限于使所有多路径设备可用。因此,在此处指定任意字符串。路径是必需的,否则 XML 解析器会失败。

- 类型

:虚拟机主机服务器文件系统上的挂载点。

:导出网络文件系统的服务器的 IP 地址或主机名。

:服务器上被导出的目录。

- 类型

:导出 RADOS 块设备的服务器的主机名。

:服务器上 RADOS 块设备的名称。

- 类型

:包含设备文件的目录。使用

/dev/disk/by-path(默认)或/dev/disk/by-id。:SCSI 适配器的名称。

注意:文件浏览

远程操作时,使用文件浏览器通过单击 是不可能的。

单击 以添加存储池。

虚拟机管理器的存储管理器允许您在池中创建或删除卷。您还可以暂时停用或永久删除现有的存储池。SUSE 目前不支持更改池的基本配置。

存储池的目的是在虚拟机主机服务器上提供可以添加到虚拟机中的块设备,当从远程管理它时。要使池暂时无法从远程访问,请单击存储管理器左下角的 。停止的池会标记为,并在列表窗格中显示为灰色。默认情况下,新创建的池会在虚拟机主机服务器自动启动。

要启动不活动的池并使其再次可从远程访问,请单击存储管理器左下角的 。

注意:池的状态不影响已附加的卷

池中的卷,即使已附加到虚拟机,也始终可用,无论池的状态如何((已停止)或(已启动))。池的状态仅影响通过远程管理将卷附加到虚拟机的能力。

要永久使池无法访问,请单击存储管理器左下角的 。您只能删除不活动的池。删除池不会物理擦除其在虚拟机主机服务器上的内容—它只删除池配置。但是,删除池时需要格外小心,尤其是在删除基于 LVM 卷组的工具时

警告:删除存储池

删除基于本地文件系统目录、本地分区或磁盘的存储池对当前附加到虚拟机的这些池中的卷的可用性没有影响。

位于 iSCSI、SCSI、LVM 组或网络导出目录类型的池中的卷,如果池被删除,将变得无法从虚拟机访问。尽管卷本身不会被删除,但虚拟机主机服务器将无法访问这些资源。

iSCSI/SCSI 目标或网络导出目录上的卷在创建新的相应池或直接从主机系统挂载/访问这些资源时将再次可用。

删除基于 LVM 组的存储池时,LVM 组定义将被擦除,并且 LVM 组将不再存在于主机系统中。该配置是不可恢复的,该池中的所有卷都将丢失。

虚拟机管理器允许您在所有存储池中创建卷,除了多路径、iSCSI 或 SCSI 类型的池。这些池中的卷等同于 LUN,无法在 libvirt 中更改。

可以通过存储管理器或在向虚拟机添加新存储设备时创建新卷。在这两种情况下,请从左侧面板选择一个存储池,然后单击 。

为映像指定并选择映像格式。

SUSE 目前仅支持

raw或qcow2映像。后一种选项在基于 LVM 组的池上不可用。在 旁边,指定磁盘映像允许达到的最大大小。除非您正在使用

qcow2映像,否则您还可以设置量,该量应在初始时分配。如果两个值不同,则会创建一个稀疏映像文件,该文件按需增长。对于

qcow2映像,您可以使用(也称为“后备文件”),它构成一个基本映像。新创建的qcow2映像随后仅记录对基本映像所做的更改。通过单击 开始卷创建。

VM 访客由包含操作系统和数据文件的镜像以及描述 VM 访客虚拟硬件资源的配置文件组成。VM 访客托管在 VM 主机服务器上并由其控制。本节提供有关安装 VM 访客的通用说明。

虚拟机对运行操作系统的要求几乎没有额外要求。如果操作系统未针对虚拟机主机环境进行优化,则它只能在硬件辅助虚拟化计算机硬件上运行,处于完全虚拟化模式,并且需要加载特定的设备驱动程序。呈现给虚拟机的硬件取决于主机的配置。

您应该注意与在多个虚拟机上运行单个许可的操作系统的任何许可问题。有关更多信息,请查阅操作系统许可协议。

提示:更改新虚拟机的默认选项

您可以更改创建新虚拟机时应用的默认值。例如,要将 UEFI 设置为新虚拟机的主目录固件类型,请从虚拟机管理器的菜单中选择 › ,单击 ,然后将 设置为默认固件。

图 9.1: 为新虚拟机指定默认选项 #

新建虚拟机向导将引导您完成创建虚拟机和安装其操作系统的步骤。要启动它,请打开虚拟机管理器并选择 › 。或者,启动 YaST 并选择 › 。

从 YaST 或虚拟机管理器启动向导。

选择一个安装源—可以是本地可用媒体,也可以是网络安装源。要从现有映像设置您的虚拟机,请选择。

在运行 Xen hypervisor 的虚拟机主机服务器上,您可以选择安装半虚拟化还是完全虚拟化的虚拟机。相应的选项在下可用。根据此选择,并非所有安装选项都可用。

根据您在上一步中的选择,您需要提供以下数据

指定虚拟机主机服务器上包含安装数据的 ISO 映像的路径。如果它在 libvirt 存储池中可用,您也可以使用进行选择。有关更多信息,请参阅 第 12 章, 高级存储主题。

或者,选择插入虚拟机主机服务器光驱中的物理 CD-ROM 或 DVD。

提供指向安装源的。有效的 URL 前缀例如为

ftp://、http://和https://。在 下,提供自动安装文件(例如 AutoYaST 或 Kickstart)的路径和内核参数。提供 URL 后,操作系统应能正确自动检测。如果不是这种情况,请取消选中,然后手动选择和。

要从现有映像设置虚拟机,您需要指定虚拟机主机服务器上映像的路径。如果它在 libvirt 存储池中可用,您也可以使用进行选择。有关更多信息,请参阅 第 12 章, 高级存储主题。

此安装方法适用于创建虚拟机,手动配置其组件,然后稍后安装其操作系统。要将虚拟机调整为特定产品版本,请开始键入其名称—例如,

sles—当匹配出现时选择所需版本。

选择新虚拟机的内存大小和 CPU 数量。

如果第一步选择了,则此步骤将被省略。

为虚拟机设置虚拟硬盘。可以创建新的磁盘映像,或从存储池中选择一个现有映像(有关更多信息,请参阅 第 12 章, 高级存储主题)。如果您选择创建磁盘,则默认情况下将在

/var/lib/libvirt/images下创建一个qcow2映像并存储。设置磁盘是可选的。例如,如果您直接从 CD 或 DVD 运行实时系统,则可以通过禁用来省略此步骤。

在向导的最后一个屏幕上,为虚拟机指定名称。要获得查看和修改虚拟硬件选择的可能性,请激活。在下指定网络设备。使用时,主机上找到的第一个桥接设备将预填充。要使用不同的桥接,请手动更新文本框中的名称。

单击 。

(可选) 如果您保留了上一步中的默认设置,则安装将开始。如果您选择了,将打开一个虚拟机配置对话框。有关配置虚拟机的更多信息,请参阅 第 13 章, 使用虚拟机管理器配置虚拟机。

完成配置后,单击。

提示:将按键组合传递给虚拟机

安装在虚拟机管理器控制台窗口中开始。某些按键组合,如Ctrl–Alt–F1,被虚拟机主机服务器识别但未传递给虚拟机。要绕过虚拟机主机服务器,虚拟机管理器提供了“粘滞键”功能。连续按三次Ctrl、Alt 或 Shift 键,键就会变成粘滞键,然后您可以按下剩余的键将组合键传递给虚拟机。

例如,要将Ctrl–Alt–F2 传递给 Linux 虚拟机,请按三次Ctrl 键,然后按Alt–F2。您也可以按三次Alt 键,然后按Ctrl–F2。

虚拟机管理器在虚拟机安装期间和之后都提供了粘滞键功能。

PXE 启动使您的虚拟机能够通过网络从安装介质启动,而不是从物理介质或安装磁盘映像启动。

要让您的虚拟机从 PXE 服务器启动,请按照以下步骤操作

按照第 9.1 节,“基于 GUI 的虚拟机安装”中所述启动安装向导。

选择方法。

继续进行向导的最后一步,并激活。通过进行确认。

在屏幕上,选择。

检查并激活旁边的框。

在下,激活,然后通过进行确认。

通过单击启动安装。如果 PXE 服务器已正确配置,则会显示 PXE 菜单屏幕。

virt-install 是一个命令行工具,可帮助您使用 libvirt 库创建新的虚拟机。如果您无法使用图形用户界面,或者需要自动化创建虚拟机的过程,它会很有用。

virt-install 是一个复杂的脚本,包含大量命令行开关。以下是必需的。有关更多信息,请参阅 virt-install (1) 的手册页。

- 通用选项

--name VM_GUEST_NAME:指定新虚拟机的名称。该名称在同一连接的所有虚拟机管理器已知的所有虚拟机之间必须是唯一的。它用于创建和命名虚拟机的配置文件,您可以通过此名称从virsh访问该虚拟机。允许使用字母数字字符以及_-.:+字符。--memory REQUIRED_MEMORY:以兆字节为单位指定要为新虚拟机分配的内存量。--vcpus NUMBER_OF_CPUS:指定虚拟 CPU 的数量。为获得最佳性能,虚拟处理器数量应小于或等于物理处理器数量。

- 虚拟化类型

--paravirt:设置半虚拟化虚拟机。如果虚拟机主机服务器支持半虚拟化和完全虚拟化,则这是默认设置。--hvm:设置完全虚拟化虚拟机。--virt-type HYPERVISOR:指定虚拟机管理器。支持的值为kvm或xen。

- 虚拟机存储

为新虚拟机指定

--disk、--filesystem或--nodisks中的一种存储类型。例如,--disk size=10在虚拟机管理器的默认映像位置创建 10 GB 的磁盘并将其用于虚拟机。--filesystem /export/path/on/vmhost指定虚拟机主机服务器上要导出到虚拟机的目录。--nodisks设置一个没有本地存储的虚拟机(适用于 Live CD)。- 安装方法

使用

--location、--cdrom、--pxe、--import或--boot中的一种指定安装方法。- 访问安装

使用

--graphics VALUE选项指定如何访问安装。 openSUSE Leap 支持vnc或none值。如果使用 VNC,

virt-install会尝试启动virt-viewer。如果未安装或无法运行,请手动连接到虚拟机以使用您喜欢的查看器。要明确阻止virt-install启动查看器,请使用--noautoconsole。要为访问 VNC 会话定义密码,请使用以下语法:--graphics vnc,password=PASSWORD。如果您使用

--graphics none,则可以通过操作系统支持的服务(如 SSH 或 VNC)访问虚拟机。有关如何设置这些服务的信息,请参阅操作系统安装手册。- 传递内核和 initrd 文件

可以直接指定安装程序的 Kernel 和 Initrd,例如,从网络源。

要传递其他引导参数,请使用

--extra-args选项。这可用于指定网络配置。有关详细信息,请参阅 https://en.opensuse.net.cn/SDB:Linuxrc。示例 9.1:从 HTTP 服务器加载内核和 initrd #

#virt-install--location \ "http://download.opensuse.org/pub/opensuse/distribution/leap/15.0/repo/oss" \ --extra-args="textmode=1" --name "Leap15" --memory 2048 --virt-type kvm \ --connect qemu:///system --disk size=10 --graphics vnc --network \ network=vnet_nated- 启用控制台

默认情况下,使用

virt-install安装的新虚拟机未启用控制台。要启用它,请使用--extra-args="console=ttyS0 textmode=1",如以下示例所示>virt-install --virt-type kvm --name sles12 --memory 1024 \ --disk /var/lib/libvirt/images/disk1.qcow2 --os-variant sles12 --extra-args="console=ttyS0 textmode=1" --graphics none安装完成后,虚拟机映像中的

/etc/default/grub文件会在GRUB_CMDLINE_LINUX_DEFAULT行上更新console=ttyS0选项。- 使用 UEFI 安全启动

按照 第 6.3 节,“安装 UEFI 支持” 中的说明安装 OVMF。然后将

--boot uefi选项添加到virt-install命令。在设置新虚拟机与 OVMF 时,UEFI 安全启动会自动使用。要使用特定固件,请使用

--boot loader=PATH_TO_FIRMWARE。例如,对于 AArch64 架构

--boot loader=/usr/share/qemu/qemu-uefi-aarch32.bin

对于 AMD64/Intel 64; 架构

--boot loader=/usr/share/qemu/ovmf-x86_64-opensuse.bin

示例 9.2: virt-install 命令行的示例 #

以下命令行示例创建了一个新的 SUSE Linux Enterprise 15 SP2 虚拟机,具有 virtio 加速的磁盘和网卡。它创建了一个新的 10 GB qcow2 磁盘映像作为存储,源安装介质是主机 CD-ROM 驱动器。它使用 VNC 图形,并自动启动图形客户端。

- KVM

>virt-install --connect qemu:///system --virt-type kvm \ --name sle15sp2 --memory 1024 --disk size=10 --cdrom /dev/cdrom --graphics vnc \ --os-variant sle15sp2- Xen

>virt-install --connect xen:// --virt-type xen --hvm \ --name sle15sp2 --memory 1024 --disk size=10 --cdrom /dev/cdrom --graphics vnc \ --os-variant sle15sp2

本节提供有关超出正常安装范围的操作的说明,例如内存气球和安装附加产品。

某些操作系统,例如 openSUSE Leap,提供在安装过程中包含附加产品的选项。如果附加产品安装源通过 SUSE Customer Center 提供,则无需特殊的虚拟机配置。如果通过 CD/DVD 或 ISO 映像提供,则必须同时为虚拟机安装系统提供标准安装介质映像和附加产品映像。

如果您使用基于 GUI 的安装,请在向导的最后一步选择 ,并通过 › 添加附加产品 ISO 映像。指定映像路径并将 设置为 。

如果您从命令行安装,您需要使用 --disk 参数而不是 --cdrom 来设置虚拟 CD/DVD 驱动器。首先指定的设备用于引导。以下示例安装 SUSE Linux Enterprise Server 15 以及 SUSE Enterprise Storage 扩展

> virt-install \

--name sles15+storage \

--memory 2048 --disk size=10 \

--disk /path/to/SLE-15-SP5-Full-ARCH-GM-media1.iso-x86_64-GM-DVD1.iso,device=cdrom \

--disk /path/to/SUSE-Enterprise-Storage-VERSION-DVD-ARCH-Media1.iso,device=cdrom \

--graphics vnc --os-variant sle15大多数管理任务,例如启动或停止 VM 客户机,都可以使用图形应用程序 Virtual Machine Manager 或在命令行中使用 virsh 来完成。 只能从图形用户界面通过 VNC 连接到图形控制台。

注意:在远程虚拟机主机服务器上管理虚拟机

如果在虚拟机主机服务器上启动,则 libvirt 工具 Virtual Machine Manager、virsh 和 virt-viewer 可用于管理主机上的虚拟机。但是,也可以管理远程虚拟机主机服务器上的虚拟机。这需要配置主机上的 libvirt 远程访问。有关说明,请参阅 第 11 章,“连接和授权”。

要使用 Virtual Machine Manager 连接到此类远程主机,您需要设置一个连接,如 第 11.2.2 节,“使用 Virtual Machine Manager 管理连接” 中所述。如果使用 virsh 或 virt-viewer 连接到远程主机,您需要使用参数 -c 指定连接 URI(例如,virsh -c qemu+tls://saturn.example.com/system 或 virsh -c xen+ssh://)。连接 URI 的形式取决于连接类型和虚拟机管理器——有关详细信息,请参阅 第 11.2 节,“连接到虚拟机主机服务器”。

本章中的示例均未包含连接 URI。

虚拟机列表显示虚拟机管理器在虚拟机主机服务器上管理的所有虚拟机。

Virtual Machine Manager 的主窗口列出了它连接到的每个虚拟机主机服务器的所有虚拟机。每个虚拟机条目包含机器名称、其状态(、 或 ),显示为图标和文字,以及 CPU 使用率条。

虚拟机可以通过 VNC 连接(图形控制台)访问,或者,如果虚拟机操作系统支持,可以通过串行控制台访问。

打开虚拟机的图形控制台可让您通过 VNC 连接与物理主机进行交互。如果访问 VNC 服务器需要身份验证,您将被要求输入用户名(如果适用)和密码。

当您单击 VNC 控制台时,光标会被 “捕获”,并且无法在控制台外部使用。要释放它,请按 Alt–Ctrl。

某些组合键,如 Ctrl–Alt–Del,会被主机系统解释,并且不会传递给虚拟机。要将此类组合键传递给虚拟机,请从 VNC 窗口打开 菜单并选择所需的组合键条目。 菜单仅在使用 Virtual Machine Manager 和 virt-viewer 时可用。使用 Virtual Machine Manager,您还可以选择 “粘滞键” 功能,如 提示:将组合键传递给虚拟机 中所述。

注意:支持的 VNC 查看器

原则上,所有 VNC 查看器都可以连接到虚拟机的控制台。但是,如果您使用 SASL 身份验证和/或 TLS/SSL 连接来访问虚拟机,则选项将受到限制。常见的 VNC 查看器,如 tightvnc 或 tigervnc,既不支持 SASL 身份验证,也不支持 TLS/SSL。 Virtual Machine Manager 和 virt-viewer 之外唯一支持的替代方案是 Remmina(请参阅 《参考》手册,第 4 章 “使用 VNC 进行远程图形会话”,第 4.2 节 “Remmina:远程桌面客户端”)。

virt-viewer 是一个简单的 VNC 查看器,具有显示虚拟机控制台的附加功能。例如,它可以以 “等待” 模式启动,在该模式下,它会在虚拟机启动后再连接。它还支持自动重新连接到已重启的虚拟机。

virt-viewer 通过名称、ID 或 UUID 来寻址虚拟机。使用 virsh list --all 获取此数据。

要连接到正在运行或已暂停的虚拟机,请使用 ID、UUID 或名称。已关闭的虚拟机没有 ID—您只能通过 UUID 或名称连接到它们。

- 连接到 ID 为

8的虚拟机 >virt-viewer 8- 连接到名为

sles12的非活动虚拟机;一旦虚拟机启动,连接窗口就会打开 >virt-viewer --wait sles12使用

--wait选项,即使虚拟机当前未运行,连接也会保持。当虚拟机启动时,会启动查看器。

有关更多信息,请参阅 virt-viewer --help 或 man 1 virt-viewer。

注意:通过 SSH 进行远程连接时的密码输入

当使用 virt-viewer 通过 SSH 打开到远程主机的连接时,SSH 密码需要输入两次。第一次用于向 libvirt 进行身份验证,第二次用于向 VNC 服务器进行身份验证。第二次密码需要在启动 virt-viewer 的命令行上提供。

访问虚拟机的图形控制台需要访问虚拟机的客户端上存在图形环境。作为替代方案,可以通过串行控制台和 virsh 从 shell 访问由 libvirt 管理的虚拟机。要打开名为 “sles12” 的虚拟机的串行控制台,请运行以下命令

> virsh console sles12

virsh console 接受两个可选标志:--safe 确保对控制台的独占访问,--force 在连接前断开任何现有会话。这两个功能都需要虚拟机操作系统支持。

能够通过串行控制台连接到虚拟机需要虚拟机操作系统支持串行控制台访问并得到正确支持。有关更多信息,请参阅虚拟机操作系统手册。

提示:为 SUSE Linux Enterprise 和 openSUSE 虚拟机启用串行控制台访问

SUSE Linux Enterprise 和 openSUSE 中的串行控制台访问默认是禁用的。要启用它,请按以下步骤操作

- SLES 12、15 和 openSUSE

启动 YaST Boot Loader 模块并切换到 选项卡。将

console=ttyS0添加到 字段。- SLES 11

启动 YaST Boot Loader 模块并选择要激活串行控制台访问的引导项。选择 并将

console=ttyS0添加到 字段。此外,编辑/etc/inittab并取消注释包含以下内容的行#S0:12345:respawn:/sbin/agetty -L 9600 ttyS0 vt102

启动、停止或暂停虚拟机可以使用 Virtual Machine Manager 或 virsh 完成。您还可以配置虚拟机以便在虚拟机主机服务器启动时自动启动。

关闭虚拟机时,您可以选择正常关闭,也可以强制关闭。后者等同于拔掉物理主机的电源插头,仅在别无选择时推荐。强制关闭可能会导致虚拟机上的文件系统损坏和数据丢失。

提示:正常关机

要能够执行正常关机,虚拟机必须配置为支持 ACPI。如果您使用 Virtual Machine Manager 创建了虚拟机,则 ACPI 应该在虚拟机中可用。

根据虚拟机操作系统,ACPI 的可用性可能不足以执行正常关机。强烈建议在生产环境中使用虚拟机之前先测试关机和重启。例如,openSUSE 或 SUSE Linux Enterprise Desktop 可能需要 Polkit 授权才能关机和重启。请确保在所有虚拟机上关闭此策略。

如果在 Windows XP/Windows Server 2003 虚拟机安装过程中启用了 ACPI,则仅在虚拟机配置中启用 ACPI 并不足够。有关更多信息,请参阅

无论虚拟机如何配置,始终可以从虚拟机操作系统内部执行正常关机。

更改虚拟机状态可以从 Virtual Machine Manager 的主窗口或从 VNC 窗口完成。

过程 10.1:从 Virtual Machine Manager 窗口更改状态 #

右键单击虚拟机条目。

从弹出菜单中选择 、 或 中的一项。

过程 10.2:从 VNC 窗口更改状态 #

按照 第 10.2.1.1 节,“使用 Virtual Machine Manager 打开图形控制台” 中的说明打开 VNC 窗口。

从工具栏或 菜单中选择 、 或 选项之一。

保存虚拟机可保留虚拟机内存的精确状态。此操作类似于计算机的 休眠。已保存的虚拟机可以快速恢复到先前保存的运行状态。

保存时,虚拟机将被暂停,其当前内存状态将保存到磁盘,然后虚拟机将停止。此操作不会复制虚拟机虚拟磁盘的任何部分。保存虚拟机所需的时间取决于分配的内存量。保存后,虚拟机的内存会返回到虚拟机主机服务器上的可用内存池。

恢复操作会加载虚拟机先前保存的内存状态文件并启动它。虚拟机不会启动,而是恢复到先前保存的点。此操作类似于从休眠中唤醒。

虚拟机将被保存到状态文件。确保您要保存的分区上有足够的空间。要估算预期的文件大小(以兆字节为单位),请在虚拟机上运行以下命令

> free -mh | awk '/^Mem:/ {print $3}'警告:始终恢复已保存的虚拟机

使用保存操作后,请勿启动或运行已保存的虚拟机。这样做会导致机器的虚拟磁盘和已保存的内存状态不同步。这可能导致恢复虚拟机时出现严重错误。

要再次处理已保存的虚拟机,请使用恢复操作。如果您使用 virsh 保存了虚拟机,则无法使用 Virtual Machine Manager 恢复它。在这种情况下,请确保使用 virsh 进行恢复。

重要:恢复虚拟机后同步其时间

如果您在保存虚拟机后长时间(数小时)暂停后恢复它,其时间同步服务—例如 chronyd—可能会拒绝同步其时间。在这种情况下,请手动同步虚拟机的时间。例如,对于 KVM 主机,您可以使用 QEMU 虚拟机代理并使用 guest-set-time 指示虚拟机。有关更多详细信息,请参阅 第 19 章,“QEMU 虚拟机代理”。

重要:仅适用于磁盘类型为 raw、qcow2 的虚拟机

只有当虚拟机使用 raw(.img)或 qcow2 类型的虚拟磁盘时,才能保存和恢复虚拟机。

过程 10.3:保存虚拟机 #

打开到虚拟机的 VNC 连接窗口。确保虚拟机正在运行。

选择 › › 。

过程 10.4:恢复虚拟机 #

打开到虚拟机的 VNC 连接窗口。确保虚拟机未运行。

选择 › 。

如果虚拟机先前是使用 Virtual Machine Manager 保存的,则不会提供 该虚拟机的选项。但是,请注意 警告:始终恢复已保存的虚拟机 中概述的

virsh保存的机器的注意事项。

虚拟机快照是完整虚拟机的快照,包括 CPU、RAM、设备状态以及所有可写磁盘的内容。要使用虚拟机快照,所有附加的硬盘都必须使用 qcow2 磁盘映像格式,并且至少有一个必须是可写的。

快照允许您在特定时间点恢复机器的状态。当撤销错误的配置或大量软件包的安装时,这很有用。启动创建于虚拟机关闭时拍摄的快照后,您需要启动它。之后写入磁盘的任何更改在启动快照时都会丢失。

注意

快照仅在 KVM 虚拟机主机服务器上受支持。

有几个特定的术语用于描述快照的类型

- 内部快照

保存在原始虚拟机 qcow2 文件中的快照。该文件同时保存了快照的已保存状态以及自快照拍摄以来所做的更改。内部快照的主要优点是它们都存储在一个文件中,因此很容易在多台机器之间复制或移动。

- 外部快照

创建外部快照时,原始 qcow2 文件将被保存并设为只读,同时创建一个新的 qcow2 文件来保存更改。原始文件有时称为 backing 或 base 文件,而包含所有更改的新文件称为 overlay 或 derived 文件。外部快照对于备份虚拟机很有用。但是,Virtual Machine Manager 不支持外部快照,并且

virsh不能直接删除它们。有关 QEMU 中外部快照的更多信息,请参阅 第 33.2.4 节,“有效地操作磁盘映像”。- 实时快照

在原始虚拟机运行时创建的快照。内部实时快照支持保存设备、内存和磁盘状态,而外部实时快照与

virsh支持保存内存状态、磁盘状态或两者。- 离线快照

从已关闭的虚拟机创建的快照。这确保了数据完整性,因为所有虚拟机进程都已停止,没有内存在使用。

重要:仅内部快照

Virtual Machine Manager 仅支持内部快照,包括实时或离线快照。

要打开 Virtual Machine Manager 中的快照管理视图,请按照 第 10.2.1.1 节,“使用 Virtual Machine Manager 打开图形控制台” 中的说明打开 VNC 窗口。现在,选择 › 或单击工具栏中的 。

窗口左侧显示所选虚拟机的现有快照列表。最后一个启动的快照用绿色勾号标记。窗口右侧显示当前列表中标记的快照的详细信息。这些详细信息包括快照的标题和时间戳、拍摄快照时虚拟机的状态以及描述。正在运行的虚拟机的快照还包括屏幕截图。 可以直接从该视图更改。其他快照数据无法更改。

要拍摄虚拟机的新快照,请按以下步骤操作

可选地,关闭虚拟机以创建离线快照。

单击 VNC 窗口左下角的 。

将打开 窗口。

提供一个 ,可选地提供描述。拍摄快照后,无法更改名称。为了以后能够轻松识别快照,请使用一个 “易于理解的名称”。

单击 进行确认。

要列出域(以下为 admin_server)的所有现有快照,请运行 snapshot-list 命令

> virsh snapshot-list --domain sle-ha-node1

Name Creation Time State

------------------------------------------------------------

sleha_12_sp2_b2_two_node_cluster 2016-06-06 15:04:31 +0200 shutoff

sleha_12_sp2_b3_two_node_cluster 2016-07-04 14:01:41 +0200 shutoff

sleha_12_sp2_b4_two_node_cluster 2016-07-14 10:44:51 +0200 shutoff

sleha_12_sp2_rc3_two_node_cluster 2016-10-10 09:40:12 +0200 shutoff

sleha_12_sp2_gmc_two_node_cluster 2016-10-24 17:00:14 +0200 shutoff

sleha_12_sp3_gm_two_node_cluster 2017-08-02 12:19:37 +0200 shutoff

sleha_12_sp3_rc1_two_node_cluster 2017-06-13 13:34:19 +0200 shutoff

sleha_12_sp3_rc2_two_node_cluster 2017-06-30 11:51:24 +0200 shutoff

sleha_15_b6_two_node_cluster 2018-02-07 15:08:09 +0100 shutoff

sleha_15_rc1_one-node 2018-03-09 16:32:38 +0100 shutoff最后启动的快照显示在 snapshot-current 命令:

> virsh snapshot-current --domain admin_server

Basic installation incl. SMT for CLOUD4通过运行 snapshot-info 命令可以获取特定快照的详细信息

> virsh snapshot-info --domain admin_server \

-name "Basic installation incl. SMT for CLOUD4"

Name: Basic installation incl. SMT for CLOUD4

Domain: admin_server

Current: yes

State: shutoff

Location: internal

Parent: Basic installation incl. SMT for CLOUD3-HA

Children: 0

Descendants: 0

Metadata: yes要拍摄虚拟机的内部快照(实时或离线),请使用 snapshot-create-as 命令,如下所示

> virsh snapshot-create-as --domain admin_server1 --name "Snapshot 1"2 \

--description "First snapshot"3使用 virsh,您可以拍摄虚拟机内存状态、磁盘状态或两者的外部快照。

要拍摄虚拟机磁盘的实时和离线外部快照,请指定 --disk-only 选项

> virsh snapshot-create-as --domain admin_server --name \

"Offline external snapshot" --disk-only您可以指定 --diskspec 选项来控制外部文件的创建方式

> virsh snapshot-create-as --domain admin_server --name \

"Offline external snapshot" \

--disk-only --diskspec vda,snapshot=external,file=/path/to/snapshot_file要拍摄虚拟机内存的实时外部快照,请指定 --live 和 --memspec 选项

> virsh snapshot-create-as --domain admin_server --name \

"Offline external snapshot" --live \

--memspec snapshot=external,file=/path/to/snapshot_file要拍摄虚拟机磁盘和内存状态的实时外部快照,请组合使用 --live、--diskspec 和 --memspec 选项

> virsh snapshot-create-as --domain admin_server --name \

"Offline external snapshot" --live \

--memspec snapshot=external,file=/path/to/snapshot_file

--diskspec vda,snapshot=external,file=/path/to/snapshot_file有关更多详细信息,请参阅 man 1 virsh 中的 SNAPSHOT COMMANDS 部分。

外部快照不能用 virsh 删除。要删除虚拟机的内部快照并释放其占用的磁盘空间,请使用 snapshot-delete 命令

> virsh snapshot-delete --domain admin_server --snapshotname "Snapshot 2"默认情况下,使用 virsh 删除虚拟机仅删除其 XML 配置。由于附加存储默认不会被删除,您可以将其与其他虚拟机重用。使用 Virtual Machine Manager,您还可以删除虚拟机的存储文件。

在 Virtual Machine Manager 中,右键单击虚拟机条目。

从上下文菜单中选择 。

将打开一个确认窗口。单击 将永久擦除虚拟机。删除不可恢复。

您还可以通过激活 来永久删除虚拟机的虚拟磁盘。删除也不可恢复。

要删除虚拟机,需要先将其关闭。无法删除正在运行的虚拟机。有关关机的信息,请参阅 第 10.3 节,“更改虚拟机状态:启动、停止、暂停”。

要使用 virsh 删除虚拟机,请运行 virsh undefine VM_NAME。

> virsh undefine sles12没有自动删除附加存储文件的选项。如果它们由 libvirt 管理,请按 第 8.2.1.4 节,“从存储池删除卷” 中的说明删除它们。

虚拟化的主要优点之一是虚拟机是可移植的。当虚拟机主机服务器需要进行维护或主机过载时,虚拟机可以轻松地移动到另一台虚拟机主机服务器。KVM 和 Xen 甚至支持 “实时” 迁移,在此期间虚拟机一直可用。

要成功将虚拟机迁移到另一台虚拟机主机服务器,需要满足以下要求

重要提示

要使用 post-copy 实时迁移选项,内核版本 5.11 或更高版本的 KVM 主机需要将 unprivileged_userfaultfd 系统值设置为 1

>sudosysctl -w vm.unprivileged_userfaultfd=1

由于 5.11 之前的内核版本不需要设置 unprivileged_userfaultfd 来使用 post-copy 选项,libvirt 在 /usr/lib/sysctl.d/60-qemu-postcopy-migration.conf 文件中提供了该设置以保留旧行为。

源系统和目标系统必须具有相同的架构。

存储设备必须可以从两台机器访问(例如,通过 NFS 或 iSCSI),并且必须在两台机器上配置为存储池。有关更多信息,请参阅 第 12 章,“高级存储主题”。

CD-ROM 或软盘映像在移动过程中连接时也是如此。但是,您可以在移动前断开它们,如 第 13.11 节,“使用 Virtual Machine Manager 弹出和更改软盘或 CD/DVD-ROM 介质” 中所述。

libvirtd必须在两台虚拟机主机服务器上运行,并且您必须能够打开目标主机和源主机(或反之)之间的远程libvirt连接。有关详细信息,请参阅 第 11.3 节,“配置远程连接”。如果目标主机上正在运行防火墙,则需要打开端口以允许迁移。如果您在迁移过程中未指定端口,

libvirt将从 49152:49215 的范围内选择一个端口。确保在 目标主机 上的防火墙中打开此范围(推荐)或您选择的专用端口。主机和目标机器应位于网络上的同一子网中,否则迁移后网络将失败。

参与迁移的所有虚拟机主机服务器必须具有相同的 qemu 用户 UID 和 kvm、qemu 和 libvirt 组相同的 GID。

目标主机上不得存在同名运行或暂停的虚拟机。如果存在同名的已关闭虚拟机,其配置将被覆盖。

迁移虚拟机时支持所有 CPU 模型,除了 host cpu 模型。

SATA 磁盘设备类型不可迁移。

文件系统直通功能与迁移不兼容。

虚拟机主机服务器和虚拟机需要安装正确的时间设置。请参阅 第 17 章,“虚拟机时钟设置”。

不能将物理设备从主机传递给虚拟机。实时迁移目前不支持使用具有 PCI 直通或 SR-IOV 的设备。如果需要支持实时迁移,您需要使用软件虚拟化(半虚拟化或完全虚拟化)。

缓存模式设置是迁移的重要设置。请参阅:第 16.6 节,“缓存模式和实时迁移”。

映像目录应位于两台主机上的同一路径中。

所有主机应处于同一级别的微码(特别是 spectre 微码更新)。这可以通过在所有主机上安装 openSUSE Leap 的最新更新来实现。

使用 Virtual Machine Manager 迁移虚拟机时,在哪台机器上启动它并不重要。您可以在源主机、目标主机或甚至第三方主机上启动 Virtual Machine Manager。在后一种情况下,您需要能够打开到目标主机和源主机的远程连接。

启动 Virtual Machine Manager 并建立到目标主机或源主机的连接。如果 Virtual Machine Manager 未在目标主机或源主机上启动,则需要打开到两台主机的连接。

右键单击要迁移的虚拟机并选择 。确保虚拟机正在运行或已暂停—无法迁移已关闭的虚拟机。

提示:提高迁移速度

要提高迁移速度,请暂停虚拟机。这相当于 Virtual Machine Manager 以前所谓的 “离线迁移” 选项。

为虚拟机选择一个 。如果所需的宿主机未显示,请确保您已连接到该宿主机。

要更改连接到远程主机的默认选项,请在 下,设置 ,以及目标主机的 (IP 地址或主机名)和 。如果指定了 ,则还必须指定 。

在 下,选择移动是永久性的(默认)还是临时的,使用 。

此外,还有一个 选项,它允许在不禁用虚拟机主机服务器缓存的情况下进行迁移。这可以加快迁移速度,但仅在当前配置允许在不使用

cache="none"/0_DIRECT的情况下获得虚拟机存储的一致视图时才有效。注意:带宽选项

在 Virtual Machine Manager 的最新版本中,设置迁移带宽的选项已被移除。要设置特定带宽,请改用

virsh。要执行迁移,请单击 。

迁移完成后, 窗口关闭,虚拟机现在会列在新主机上的 Virtual Machine Manager 窗口中。原始虚拟机仍然可以在目标主机上(处于关闭状态)使用。

要使用 virsh migrate 迁移虚拟机,您需要直接或远程 shell 访问虚拟机主机服务器,因为该命令需要在主机上运行。迁移命令如下所示

> virsh migrate [OPTIONS] VM_ID_or_NAME CONNECTION_URI [--migrateuri tcp://REMOTE_HOST:PORT]最重要的选项列在下面。请参阅 virsh help migrate 获取完整列表。

--live执行实时迁移。如果未指定,则在迁移期间暂停虚拟机(“离线迁移”)。

--suspend执行离线迁移,并且不将虚拟机重新启动到目标主机。

--persistent默认情况下,迁移的虚拟机是临时迁移的,因此如果将其关闭,其配置将自动从目标主机删除。使用此开关可使迁移持久化。

--undefinesource指定时,在成功迁移后,源主机上的虚拟机定义将被删除(但是,附加到此虚拟机的虚拟磁盘不会被删除)。

--parallel --parallel-connections NUM_OF_CONNECTIONS并行迁移可用于提高迁移数据吞吐量,在单个迁移线程无法使源和目标主机之间的网络链路饱和的情况下。在具有 40 GB 网络接口的主机上,可能需要四个迁移线程才能使链路饱和。通过并行迁移,迁移大型内存虚拟机所需的时间可以显着减少。

以下示例使用 mercury.example.com 作为源系统,jupiter.example.com 作为目标系统;虚拟机的名称为 opensuse131,ID 为 37。

- 离线迁移,使用默认参数

>virsh migrate 37 qemu+ssh://tux@jupiter.example.com/system- 瞬时实时迁移,使用默认参数

>virsh migrate --live opensuse131 qemu+ssh://tux@jupiter.example.com/system- 持久实时迁移;删除源上的虚拟机定义

>virsh migrate --live --persistent --undefinesource 37 \ qemu+tls://tux@jupiter.example.com/system- 离线迁移,使用端口 49152

>virsh migrate opensuse131 qemu+ssh://tux@jupiter.example.com/system \ --migrateuri tcp://@jupiter.example.com:49152

注意:瞬时与持久迁移

默认情况下,virsh migrate 在目标主机上创建虚拟机的临时(瞬时)副本。原始虚拟机描述的已关闭版本保留在源主机上。瞬时副本在关闭后将从服务器中删除。

要创建虚拟机在目标主机上的永久副本,请使用开关 --persistent。原始虚拟机描述的已关闭版本也会保留在源主机上。将 --undefinesource 与 --persistent 选项一起使用,以实现 “真实” 移动,即在目标主机上创建永久副本,并删除源主机上的副本。

不建议在不使用 --persistent 选项的情况下使用 --undefinesource,因为这会导致虚拟机在目标主机上关闭时丢失两个虚拟机定义。

首先需要导出存储,以便在主机之间共享虚拟机映像。这可以通过 NFS 服务器完成。在以下示例中,我们希望与网络 10.0.1.0/24 上的所有机器共享 /volume1/VM 目录。我们使用的是 SUSE Linux Enterprise NFS 服务器。以 root 用户身份编辑 /etc/exports 文件并添加

/volume1/VM 10.0.1.0/24 (rw,sync,no_root_squash)

需要重启 NFS 服务器

>sudosystemctl restart nfsserver>sudoexportfs /volume1/VM 10.0.1.0/24

在您要迁移虚拟机的每个主机上,都必须定义池以能够访问(包含虚拟机映像的)卷。我们的 NFS 服务器 IP 地址是 10.0.1.99,其共享是 /volume1/VM 目录,我们希望将其挂载在 /var/lib/libvirt/images/VM 目录中。池的名称是 VM。要定义此池,请创建一个 VM.xml 文件,其中包含以下内容

<pool type='netfs'>

<name>VM</name>

<source>

<host name='10.0.1.99'/>

<dir path='/volume1/VM'/>

<format type='auto'/>

</source>

<target>

<path>/var/lib/libvirt/images/VM</path>

<permissions>

<mode>0755</mode>

<owner>-1</owner>

<group>-1</group>

</permissions>

</target>

</pool>然后使用 pool-define 命令将其加载到 libvirt 中

# virsh pool-define VM.xml定义此池的另一种方法是使用 virsh 命令

# virsh pool-define-as VM --type netfs --source-host 10.0.1.99 \

--source-path /volume1/VM --target /var/lib/libvirt/images/VM

Pool VM created以下命令假定您处于 virsh 的交互式 shell 中,该 shell 也可以通过不带参数的命令 virsh 访问。然后可以设置池以在主机启动时自动启动(autostart 选项)

virsh # pool-autostart VM

Pool VM marked as autostarted要禁用自动启动

virsh # pool-autostart VM --disable

Pool VM unmarked as autostarted检查池是否存在

virsh #pool-list --all Name State Autostart ------------------------------------------- default active yes VM active yesvirsh #pool-info VM Name: VM UUID: 42efe1b3-7eaa-4e24-a06a-ba7c9ee29741 State: running Persistent: yes Autostart: yes Capacity: 2,68 TiB Allocation: 2,38 TiB Available: 306,05 GiB

警告:池必须存在于所有目标主机上

记住:此池必须定义在您希望能够迁移虚拟机的所有主机上。

池已定义—现在我们需要一个包含磁盘映像的卷

virsh # vol-create-as VM sled12.qcow2 8G --format qcow2

Vol sled12.qcow2 created显示的卷名称稍后将用于使用 virt-install 安装虚拟机。

让我们使用 virt-install 命令创建一个 openSUSE Leap 虚拟机。--disk 选项指定 VM 池,如果不想在迁移时使用 --unsafe 选项,建议使用 cache=none。

# virt-install --connect qemu:///system --virt-type kvm --name \

sled12 --memory 1024 --disk vol=VM/sled12.qcow2,cache=none --cdrom \

/mnt/install/ISO/SLE-12-Desktop-DVD-x86_64-Build0327-Media1.iso --graphics \

vnc --os-variant sled12

Starting install...

Creating domain...启动 Virtual Machine Manager 并连接到虚拟机主机服务器后,将显示所有正在运行的虚拟机的 CPU 使用率图。

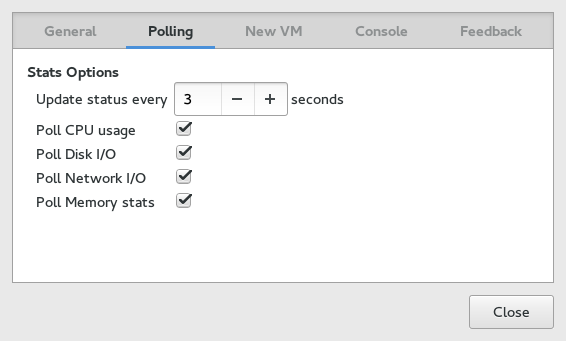

使用此工具还可以获取磁盘和网络使用情况的信息,但您必须首先在 中激活它

运行

virt-manager。选择 › 。

将选项卡从 更改为 。

激活您想看到的活动类型的复选框:、 和 。

如果需要,还可以使用 更改更新间隔。

关闭 对话框。

在 › 下激活应显示的图形。

之后,磁盘和网络统计信息也将显示在 Virtual Machine Manager 的主窗口中。

VNC 窗口提供了更精确的数据。按照 第 10.2.1 节,“打开图形控制台” 中的说明打开 VNC 窗口。从工具栏或 菜单中选择 。统计信息显示在左侧树状菜单的 条目中。

virt-top 是一个命令行工具,类似于广为人知的进程监控工具 top。virt-top 使用 libvirt,因此能够显示不同虚拟机管理器上运行的虚拟机的统计信息。建议使用 virt-top 而不是特定于虚拟机管理器的工具,如 xentop。

默认情况下,virt-top 显示所有正在运行的虚拟机的统计信息。显示的其中一项数据是内存使用百分比(%MEM)和 CPU 使用百分比(%CPU)以及虚拟机运行时间(TIME)。数据会定期更新(默认每三秒)。以下显示了在具有七个虚拟机的虚拟机主机服务器上的输出,其中四个不活动

virt-top 13:40:19 - x86_64 8/8CPU 1283MHz 16067MB 7.6% 0.5%

7 domains, 3 active, 3 running, 0 sleeping, 0 paused, 4 inactive D:0 O:0 X:0

CPU: 6.1% Mem: 3072 MB (3072 MB by guests)

ID S RDRQ WRRQ RXBY TXBY %CPU %MEM TIME NAME

7 R 123 1 18K 196 5.8 6.0 0:24.35 sled12_sp1

6 R 1 0 18K 0 0.2 6.0 0:42.51 sles12_sp1

5 R 0 0 18K 0 0.1 6.0 85:45.67 opensuse_leap

- (Ubuntu_1410)

- (debian_780)

- (fedora_21)

- (sles11sp3)默认情况下,输出按 ID 排序。使用以下组合键更改排序字段

| Shift–P:CPU 使用率 |

| Shift–M:虚拟机分配的总内存 |

| Shift–T:时间 |

| Shift–I:ID |

要使用任何其他字段进行排序,请按 Shift–F 并从列表中选择一个字段。要切换排序顺序,请使用 Shift–R。

virt-top 还支持虚拟机数据的不同视图,这些视图可以即时更改,方法是按以下键

| 0:默认视图 |

| 1:显示物理 CPU |

| 2:显示网络接口 |

| 3:显示虚拟磁盘 |

virt-top 支持更多热键来更改数据视图,以及许多影响程序行为的命令行开关。有关更多信息,请参阅 man 1 virt-top。

kvm_stat 可用于跟踪 KVM 性能事件。它监控 /sys/kernel/debug/kvm,因此需要挂载 debugfs。在 openSUSE Leap 上,它应该默认挂载。如果未挂载,请使用以下命令

>sudomount -t debugfs none /sys/kernel/debug

kvm_stat 可用于三种不同模式

kvm_stat # update in 1 second intervals

kvm_stat -1 # 1 second snapshot

kvm_stat -l > kvmstats.log # update in 1 second intervals in log format

# can be imported to a spreadsheet示例 10.1: kvm_stat 的典型输出 #

kvm statistics efer_reload 0 0 exits 11378946 218130 fpu_reload 62144 152 halt_exits 414866 100 halt_wakeup 260358 50 host_state_reload 539650 249 hypercalls 0 0 insn_emulation 6227331 173067 insn_emulation_fail 0 0 invlpg 227281 47 io_exits 113148 18 irq_exits 168474 127 irq_injections 482804 123 irq_window 51270 18 largepages 0 0 mmio_exits 6925 0 mmu_cache_miss 71820 19 mmu_flooded 35420 9 mmu_pde_zapped 64763 20 mmu_pte_updated 0 0 mmu_pte_write 213782 29 mmu_recycled 0 0 mmu_shadow_zapped 128690 17 mmu_unsync 46 -1 nmi_injections 0 0 nmi_window 0 0 pf_fixed 1553821 857 pf_guest 1018832 562 remote_tlb_flush 174007 37 request_irq 0 0 signal_exits 0 0 tlb_flush 394182 148

有关如何解释这些值的更多信息,请参阅 http://clalance.blogspot.com/2009/01/kvm-performance-tools.html。

管理多个 VM 主机服务器,每个服务器托管多个 VM 访客,很快就会变得困难。 libvirt 的一个好处是能够同时连接到多个 VM 主机服务器,从而提供一个用于管理所有 VM 访客并连接到其图形控制台的单一界面。

为确保只有授权用户才能连接,libvirt 提供了多种连接类型(通过 TLS、SSH、Unix 套接字和 TCP),这些类型可以与不同的授权机制(套接字、Polkit、SASL 和 Kerberos)结合使用。

管理虚拟机和访问其图形控制台的权限应该是限制在特定人群中的。为实现此目标,您可以在虚拟机主机服务器上使用以下身份验证技术

通过权限和组所有权控制对 Unix 套接字的访问。此方法仅适用于

libvirtd连接。通过 Polkit 控制对 Unix 套接字的访问。此方法仅适用于本地

libvirtd连接。使用 SASL(简单身份验证和安全层)的用户名和密码身份验证。此方法适用于

libvirtd和 VNC 连接。使用 SASL 不需要服务器上的实际用户帐户,因为它使用自己的数据库来存储用户名和密码。使用 SASL 身份验证的连接是加密的。Kerberos 身份验证。此方法仅适用于

libvirtd连接,本手册不涵盖。有关详细信息,请参阅 https://libvirt.org/auth.html#ACL_server_kerberos。单密码身份验证。此方法仅适用于 VNC 连接。

重要:libvirtd 和 VNC 的身份验证需要单独配置

对虚拟机管理功能(通过 libvirtd)及其图形控制台的访问始终需要单独配置。在限制对管理工具的访问时,这些限制不会自动应用于 VNC 连接!

通过 TLS/SSL 连接从远程访问虚拟机时,可以通过限制对证书密钥文件的读取权限给特定组来间接控制每个客户端的访问。有关详细信息,请参阅 第 11.3.2.5 节,“限制访问(安全注意事项)”。

libvirtd 身份验证在 /etc/libvirt/libvirtd.conf 中配置。在此处进行的配置适用于所有 libvirt 工具,例如 Virtual Machine Manager 或 virsh。

libvirt 提供两个套接字:一个用于监视目的的只读套接字,以及一个用于管理操作的读写套接字。两个套接字的访问都可以独立配置。默认情况下,两个套接字都属于 root.root。读写套接字的默认访问权限仅限于用户 root(0700),而只读套接字的权限完全开放(0777)。

以下说明描述了如何配置读写套接字的访问权限。相同的说明也适用于只读套接字。所有配置步骤都必须在虚拟机主机服务器上执行。

注意:openSUSE Leap 上的默认身份验证设置

openSUSE Leap 上的默认身份验证方法是 Unix 套接字的访问控制。只有用户 root 可以进行身份验证。当直接在虚拟机主机服务器上以非 root 用户身份访问 libvirt 工具时,您需要通过 Polkit 提供一次 root 密码。然后,您将获得当前会话和未来会话的访问权限。

或者,您可以配置 libvirt 以允许非特权用户访问““system””。有关详细信息,请参阅第 11.2.1 节,“非特权用户的““system””访问”。

推荐的授权方法 #

- 本地连接

第 11.1.1.2 节,“使用 Polkit 进行 Unix 套接字的本地访问控制” 第 11.1.1.1 节,“使用权限和组所有权进行 Unix 套接字访问控制” - 通过 SSH 的远程隧道

第 11.1.1.1 节,“使用权限和组所有权进行 Unix 套接字访问控制” - 远程 TLS/SSL 连接

第 11.1.1.3 节,“使用 SASL 进行用户名和密码身份验证” 无 (通过限制对证书的访问在客户端侧控制访问)

要授予非 root 帐户访问权限,请将套接字配置为由特定组 (libvirt,如下例所示) 拥有并可访问。此身份验证方法可用于本地和远程 SSH 连接。

如果组不存在,请创建应拥有套接字的组

>sudogroupadd libvirt重要:组必须存在

在重启

libvirtd之前,组必须存在。否则,重启将失败。将所需用户添加到组

>sudousermod --append --groups libvirt tux按如下方式修改

/etc/libvirt/libvirtd.conf中的配置unix_sock_group = "libvirt"1 unix_sock_rw_perms = "0770"2 auth_unix_rw = "none"3

重启

libvirtd>sudosystemctl start libvirtd

使用 Polkit 的 Unix 套接字访问控制是 openSUSE Leap 上非远程连接的默认身份验证方法。因此,无需进行任何 libvirt 配置更改。启用 Polkit 授权后,两个套接字的权限默认为 0777,每个尝试访问套接字的应用程序都需要通过 Polkit 进行身份验证。

重要:仅限本地连接的 Polkit 身份验证

Polkit 身份验证只能用于虚拟机主机服务器本身的本地连接,因为 Polkit 不处理远程身份验证。

存在两个用于访问 libvirt 套接字的策略

org.libvirt.unix.monitor:访问只读套接字

org.libvirt.unix.manage:访问读写套接字

默认情况下,访问读写套接字的策略是使用 root 密码进行一次身份验证,并授予当前和未来会话的权限。

要授予用户访问套接字的权限而不必提供 root 密码,您需要创建一个位于 /etc/polkit-1/rules.d 中的规则。创建 /etc/polkit-1/rules.d/10-grant-libvirt 文件,其中包含以下内容,以授予 libvirt 组所有成员对读写套接字的访问权限。

polkit.addRule(function(action, subject) {

if (action.id == "org.libvirt.unix.manage" && subject.isInGroup("libvirt")) {

return polkit.Result.YES;

}

});SASL 提供用户名和密码身份验证以及数据加密 (默认使用 digest-md5)。由于 SASL 维护自己的用户数据库,因此用户不需要存在于虚拟机主机服务器上。TCP 连接以及 TLS/SSL 连接之上都需要 SASL。

重要:纯 TCP 和带 digest-md5 加密的 SASL

在未加密的 TCP 连接上使用 digest-md5 加密,对于生产环境来说安全性不足。建议仅在测试环境中使用。

提示:TLS/SSL 之上的 SASL 身份验证

可以在客户端侧通过限制对证书密钥文件的访问来间接控制来自远程 TLS/SSL 连接的访问。但是,在处理许多客户端时,这可能会容易出错。将 SASL 与 TLS 结合使用,可以通过在服务器侧额外控制访问来增加安全性。

要配置 SASL 身份验证,请执行以下操作

按如下方式修改

/etc/libvirt/libvirtd.conf中的配置为 TCP 连接启用 SASL

auth_tcp = "sasl"

为 TLS/SSL 连接启用 SASL

auth_tls = "sasl"

重启

libvirtd>sudosystemctl restart libvirtdlibvirt SASL 配置文件位于

/etc/sasl2/libvirtd.conf。通常无需更改默认设置。但是,如果在 TLS 之上使用 SASL,则可以通过注释掉设置mech_list参数的行来关闭会话加密,以避免额外的开销 (TLS 连接已加密)。仅对 TLS/SASL 执行此操作。对于 TCP 连接,此参数必须设置为 digest-md5。#mech_list: digest-md5

默认情况下,未配置 SASL 用户,因此无法登录。使用以下命令管理用户

- 添加用户

tux saslpasswd2 -a libvirt tux

- 删除用户

tux saslpasswd2 -a libvirt -d tux

- 列出现有用户

sasldblistusers2 -f /etc/libvirt/passwd.db

- 添加用户

提示:virsh 和 SASL 身份验证

使用 SASL 身份验证时,每次发出 virsh 命令时都会提示您输入用户名和密码。通过在 shell 模式下使用 virsh 来避免此情况。

由于对虚拟机客户机的图形控制台的访问不由 libvirt 控制,而是由特定虚拟机监控程序控制,因此始终需要另外配置 VNC 身份验证。主配置文件是 /etc/libvirt/<hypervisor>.conf。本节介绍 QEMU/KVM 虚拟机监控程序,因此目标配置文件是 /etc/libvirt/qemu.conf。

注意:Xen 的 VNC 身份验证

与 KVM 不同,Xen 尚未提供比按虚拟机设置密码更复杂的 VNC 身份验证。请参阅下面的 <graphics type='vnc'... libvirt 配置选项。

有两种身份验证类型可用:SASL 和单密码身份验证。如果您正在将 SASL 用于 libvirt 身份验证,强烈建议您也将其用于 VNC 身份验证 — 可以共享同一数据库。

限制对虚拟机客户机的访问的第三种方法是启用 VNC 服务器上的 TLS 加密。这要求 VNC 客户端拥有 x509 客户端证书的访问权限。通过限制对这些证书的访问,可以间接控制客户端侧的访问。有关详细信息,请参阅第 11.3.2.4.2 节,“VNC over TLS/SSL:客户端配置”。

SASL 提供用户名和密码身份验证以及数据加密。由于 SASL 维护自己的用户数据库,因此用户不需要存在于虚拟机主机服务器上。与 libvirt 的 SASL 身份验证一样,您可以在 TLS/SSL 连接之上使用 SASL。有关配置这些连接的详细信息,请参阅第 11.3.2.4.2 节,“VNC over TLS/SSL:客户端配置”。

要为 VNC 配置 SASL 身份验证,请执行以下操作

创建 SASL 配置文件。建议使用现有的

libvirt文件。如果您已经为libvirt配置了 SASL,并且计划使用相同的设置,包括相同的用户名和密码数据库,则一个简单的链接就足够了。>sudoln -s /etc/sasl2/libvirt.conf /etc/sasl2/qemu.conf如果您只设置 VNC 的 SASL,或者您计划使用与

libvirt不同的配置,请复制现有文件作为模板>sudocp /etc/sasl2/libvirt.conf /etc/sasl2/qemu.conf然后根据您的需求进行编辑。

按如下方式修改

/etc/libvirt/qemu.conf中的配置vnc_listen = "0.0.0.0" vnc_sasl = 1 sasldb_path: /etc/libvirt/qemu_passwd.db

第一个参数使 VNC 能够监听所有公共接口 (而不是仅监听本地主机),第二个参数启用 SASL 身份验证。

默认情况下,未配置 SASL 用户,因此无法登录。使用以下命令管理用户

- 添加用户

tux >saslpasswd2 -f /etc/libvirt/qemu_passwd.db -a qemu tux- 删除用户

tux >saslpasswd2 -f /etc/libvirt/qemu_passwd.db -a qemu -d tux- 列出现有用户

>sasldblistusers2 -f /etc/libvirt/qemu_passwd.db

- 添加用户

重启

libvirtd>sudosystemctl restart libvirtd重启在更改配置前运行的所有虚拟机。尚未重启的虚拟机无法使用 VNC 连接的 SASL 身份验证。

注意:支持的 VNC 查看器

SASL 身份验证当前受虚拟机管理器和 virt-viewer 支持。这两个查看器也支持 TLS/SSL 连接。

对 VNC 服务器的访问也可以通过设置 VNC 密码来控制。您可以为所有虚拟机设置全局密码,也可以为每个虚拟机设置单独的密码。后者需要编辑虚拟机配置。文件。

注意:始终设置全局密码

如果您使用单密码身份验证,即使设置了每个虚拟机的密码,最好也设置一个全局密码。如果您忘记设置每个机器的密码,这将用““fallback””密码保护您的虚拟机。全局密码仅在未为该计算机设置其他密码时使用。

过程 11.1: 设置全局 VNC 密码 #

按如下方式修改

/etc/libvirt/qemu.conf中的配置vnc_listen = "0.0.0.0" vnc_password = "PASSWORD"

第一个参数使 VNC 能够监听所有公共接口 (而不是仅监听本地主机),第二个参数设置密码。密码的最大长度为八个字符。

重启

libvirtd>sudosystemctl restart libvirtd重启在更改配置前运行的所有虚拟机。尚未重启的虚拟机无法使用 VNC 连接的密码身份验证。

过程 11.2: 设置虚拟机特定的 VNC 密码 #

按如下方式修改

/etc/libvirt/qemu.conf中的配置,以使 VNC 能够监听所有公共接口 (而不是仅监听本地主机)。vnc_listen = "0.0.0.0"

在编辑器中打开虚拟机客户机的 XML 配置文件。在以下示例中,将 VM_NAME 替换为虚拟机客户机的名称。使用的编辑器默认为

$EDITOR。如果未设置该变量,则使用vi。>virsh edit VM_NAME搜索属性为

type='vnc'的<graphics>元素,例如<graphics type='vnc' port='-1' autoport='yes'/>

添加

passwd=PASSWORD属性,保存文件并退出编辑器。密码的最大长度为八个字符。<graphics type='vnc' port='-1' autoport='yes' passwd='PASSWORD'/>

重启

libvirtd>sudosystemctl restart libvirtd重启在更改配置前运行的所有虚拟机。尚未重启的虚拟机无法使用 VNC 连接的密码身份验证。

警告:VNC 协议的安全性

VNC 协议不被认为是安全的。虽然密码以加密方式发送,但在攻击者可以嗅探加密密码和加密密钥的情况下,它可能存在漏洞。因此,建议将 VNC 与 TLS/SSL 或通过 SSH 隧道一起使用。virt-viewer、虚拟机管理器和 Remmina (请参阅《参考》一书,第 4 章“使用 VNC 进行远程图形会话”,第 4.2 节“Remmina:远程桌面客户端”) 支持这两种方法。

要使用 libvirt 连接到虚拟机监控程序,您需要指定一个统一资源标识符 (URI)。virsh 和 virt-viewer (在作为 root 在虚拟机主机服务器上工作时除外) 都需要此 URI,而虚拟机管理器是可选的。尽管后者可以与连接参数一起调用 (例如,virt-manager -c qemu:///system),但它也提供了一个图形界面来创建连接 URI。有关详细信息,请参阅第 11.2.2 节,“使用虚拟机管理器管理连接”。

HYPERVISOR1+PROTOCOL2://USER@REMOTE3/CONNECTION_TYPE4

指定虚拟机监控程序。 openSUSE Leap 当前支持以下虚拟机监控程序: | |

连接到远程主机时,在此处指定协议。它可以是以下之一: | |

连接到远程主机时,请在此处指定用户名和远程主机名。如果未指定用户名,则使用调用命令的用户 ( | |

连接到 |

示例虚拟机监控程序连接 URI #

test:///default连接到本地虚拟驱动程序。用于测试。

qemu:///system或xen:///system连接到本地主机的 QEMU/Xen 虚拟机监控程序,并具有完全访问权限 (system 类型)。

qemu+ssh://tux@mercury.example.com/system或xen+ssh://tux@mercury.example.com/system连接到远程主机 mercury.example.com 上的 QEMU/Xen 虚拟机监控程序。连接通过 SSH 隧道建立。

qemu+tls://saturn.example.com/system或xen+tls://saturn.example.com/system连接到远程主机 mercury.example.com 上的 QEMU/Xen 虚拟机监控程序。连接使用 TLS/SSL 建立。

有关更多详细信息和示例,请参阅 libvirt 文档,网址为 https://libvirt.org/uri.html。

注意:URI 中的用户名

使用 Unix 套接字身份验证时 (无论使用用户名/密码身份验证方案还是 Polkit),都需要指定用户名。这适用于所有 SSH 和本地连接。

使用 SASL 身份验证 (TCP 或 TLS 连接) 或对 TLS 连接不进行额外服务器端身份验证时,无需指定用户名。使用 SASL 时,不评估用户名 — 无论如何都会提示您输入 SASL 用户/密码组合。

如上所述,可以通过两种不同的协议建立与 QEMU 虚拟机监控程序的连接:session 和 system。““session””连接以与客户端程序相同的权限启动。此类连接适用于桌面虚拟化,因为它受到限制 (例如,无 USB/PCI 设备分配、无虚拟网络设置、对 libvirtd 的远程访问受限)。

用于服务器虚拟化的““system””连接没有功能限制,但默认情况下只能由 root 访问。但是,通过向 libvirt 添加 DAC (Discretionary Access Control) 驱动程序,现在可以授予非特权用户““system””访问权限。要授予用户 tux““system””访问权限,请执行以下操作

过程 11.3: 授予普通用户““system””访问权限 #

启用通过 Unix 套接字的访问,如第 11.1.1.1 节,“使用权限和组所有权进行 Unix 套接字访问控制”中所述。在该示例中,将 libvirt 的访问授予了

libvirt组的所有成员,并将tux添加为该组成员。这确保了tux可以使用virsh或虚拟机管理器进行连接。编辑

/etc/libvirt/qemu.conf并按如下方式修改配置user = "tux" group = "libvirt" dynamic_ownership = 1

这可确保虚拟机由

tux启动,并且tux可以访问和修改绑定到客户机的资源 (例如虚拟磁盘)。将

tux添加到kvm组>sudousermod --append --groups kvm tux需要此步骤才能授予对

/dev/kvm的访问权限,这是启动虚拟机所必需的。重启

libvirtd>sudosystemctl restart libvirtd

虚拟机管理器为它管理的每个虚拟机主机服务器使用一个 Connection。每个连接都包含各自主机上的所有虚拟机。默认情况下,已配置并连接到本地主机的连接。

所有已配置的连接都显示在虚拟机管理器主窗口中。活动连接用小三角形标记,您可以单击该三角形来折叠或展开该连接的虚拟机列表。

非活动连接显示为灰色,并标记为“Not Connected”。您可以双击或右键单击它,然后从上下文菜单中选择。您也可以从此菜单中现有连接。

注意:编辑现有连接

无法编辑现有连接。要更改连接,请创建一个具有所需参数的新连接,然后删除““old””连接。

要添加虚拟机管理器中的新连接,请执行以下操作

选择 ›

选择主机的 ( 或 )

(可选) 要设置远程连接,请选择。有关更多信息,请参阅第 11.3 节,“配置远程连接”。

对于远程连接,请在

USERNAME@REMOTE _HOST格式中指定远程计算机的。重要:指定用户名

TCP 和 TLS 连接无需指定用户名:在这些情况下,不进行评估。但是,对于 SSH 连接,当您要以非

root用户身份连接时,必须指定用户名。如果您不希望在启动虚拟机管理器时自动启动连接,请停用。

通过单击完成配置。

libvirt 的一个主要好处是能够从中心位置管理不同远程主机上的虚拟机。本节提供了有关如何配置服务器和客户端以允许远程连接的详细说明。

在虚拟机主机服务器上启用通过 SSH 隧道的远程连接,只需要能够接受 SSH 连接即可。请确保 SSH 守护进程已启动 (systemctl status sshd),并且防火墙中已打开服务 SSH 的端口。

SSH 连接的用户身份验证可以使用传统的基于文件所有权和权限的方法,如第 11.1.1.1 节,“使用权限和组所有权进行 Unix 套接字访问控制”中所述。以用户 tux (qemu+ssh://tuxsIVname;/system 或 xen+ssh://tuxsIVname;/system) 的身份连接开箱即用,无需在 libvirt 端进行额外配置。

通过 SSH qemu+ssh://USER@SYSTEM 或 xen+ssh://USER@SYSTEM 连接时,您需要提供 USER 的密码。这可以通过将您的公钥复制到虚拟机主机服务器上的 ~USER/.ssh/authorized_keys 来避免,如《安全和加固指南》一书,第 22 章“使用 OpenSSH 保护网络操作”,第 22.6 节“公钥身份验证”中所述。在连接的机器上使用 gnome-keyring 可以提供更多便利。有关更多信息,请参阅《安全和加固指南》一书,第 22 章“使用 OpenSSH 保护网络操作”,第 22.9 节“使用 gnome-keyring 进行自动化公钥登录”。

使用带有 TLS/SSL 加密和 x509 证书身份验证的 TCP 连接比 SSH 设置要复杂得多,但可扩展性更好。如果您需要管理具有不同管理员数量的多个虚拟机主机服务器,请使用此方法。

TLS (Transport Layer Security) 通过使用证书加密两个计算机之间的通信。发起连接的计算机始终被视为“client”,使用“client certificate”,而接收计算机始终被视为“server”,使用“server certificate”。例如,如果您从中央桌面管理虚拟机主机服务器,则适用此场景。

如果从两台计算机发起连接,则每台计算机都需要客户端 和 服务器证书。例如,如果您将虚拟机客户机从一个主机迁移到另一个主机,就是这种情况。

每个 x509 证书都有一个匹配的私钥文件。只有证书和私钥文件的组合才能正确标识自身。为了确保证书是由假定的所有者颁发的,它由一个称为证书颁发机构 (CA) 的中心证书签名并颁发。客户端和服务器证书都必须由同一 CA 颁发。

重要:用户身份验证

使用远程 TLS/SSL 连接仅确保两台计算机被允许在特定方向上进行通信。可以通过在客户端限制对证书的访问来间接实现对特定用户的访问限制。有关更多信息,请参阅第 11.3.2.5 节,“限制访问 (安全注意事项)”。

libvirt 还支持在服务器上使用 SASL 进行用户身份验证。有关更多信息,请参阅第 11.3.2.6 节,“使用 SASL 为 TLS 套接字进行集中用户身份验证”。

虚拟机主机服务器是接收连接的机器。因此,需要安装服务器证书。CA 证书也需要安装。证书到位后,即可为 libvirt 启用 TLS 支持。

创建服务器证书并将其与相应的 CA 证书一起导出。

在虚拟机主机服务器上创建以下目录

>sudomkdir -p /etc/pki/CA/ /etc/pki/libvirt/private/如下安装证书

>sudo/etc/pki/CA/cacert.pem>sudo/etc/pki/libvirt/servercert.pem>sudo/etc/pki/libvirt/private/serverkey.pem通过启用相关套接字并重启

libvirtd来启用 TLS 支持>sudosystemctl stop libvirtd.service>sudosystemctl enable --now libvirtd-tls.socket>sudosystemctl start libvirtd.service默认情况下,

libvirt使用 TCP 端口 16514 来接受安全的 TLS 连接。在防火墙中打开此端口。

重要:启用 TLS 后重启 libvirtd

如果您为 libvirt 启用了 TLS,则必须已安装服务器证书,否则重启 libvirtd 将失败。如果您更改证书,还需要重启 libvirtd。

客户端是发起连接的机器。因此,需要安装客户端证书。CA 证书也需要安装。

创建客户端证书并将其与相应的 CA 证书一起导出。

在客户端上创建以下目录

>sudomkdir -p /etc/pki/CA/ /etc/pki/libvirt/private/如下安装证书

>sudo/etc/pki/CA/cacert.pem>sudo/etc/pki/libvirt/clientcert.pem>sudo/etc/pki/libvirt/private/clientkey.pem通过发出以下命令测试客户端/服务器设置。将 mercury.example.com 替换为您的虚拟机主机服务器的名称。指定与创建服务器证书时使用的完全限定主机名相同。

#QEMU/KVM virsh -c qemu+tls://mercury.example.com/system list --all #Xen virsh -c xen+tls://mercury.example.com/system list --all

如果您的设置正确,您将看到虚拟机主机服务器上注册到

libvirt的所有虚拟机列表。

目前,只有少数工具支持通过 TLS 进行 VNC 通信。常见的 VNC 查看器,如 tightvnc 或 tigervnc,不支持 TLS/SSL。虚拟机管理器和 virt-viewer 之外唯一受支持的替代方案是 remmina (请参阅《参考》一书,第 4 章“使用 VNC 进行远程图形会话”,第 4.2 节“Remmina:远程桌面客户端”)。

要通过 TLS/SSL 访问 VNC 的图形控制台,您需要按如下方式配置虚拟机主机服务器

在防火墙中为

VNC服务打开端口。创建一个目录

/etc/pki/libvirt-vnc,并将证书链接到该目录,如下所示>sudomkdir -p /etc/pki/libvirt-vnc && cd /etc/pki/libvirt-vnc>sudoln -s /etc/pki/CA/cacert.pem ca-cert.pem>sudoln -s /etc/pki/libvirt/servercert.pem server-cert.pem>sudoln -s /etc/pki/libvirt/private/serverkey.pem server-key.pem编辑

/etc/libvirt/qemu.conf并设置以下参数vnc_listen = "0.0.0.0" vnc_tls = 1 vnc_tls_x509_verify = 1重启

libvirtd>sudosystemctl restart libvirtd重要:虚拟机需要重启

VNC TLS 设置仅在启动虚拟机客户机时设置。因此,您需要重启在进行配置更改之前运行的所有虚拟机。

客户端上唯一需要的操作是将 x509 客户端证书放置在所选客户端能够识别的位置。但是,虚拟机管理器和 virt-viewer 期望在不同的位置找到证书。虚拟机管理器可以从适用于所有用户的系统范围位置读取,也可以从每个用户位置读取。Remmina (请参阅《参考》一书,第 4 章“使用 VNC 进行远程图形会话”,第 4.2 节“Remmina:远程桌面客户端”) 在初始化与远程 VNC 会话的连接时会询问证书的位置。

- 虚拟机管理器 (

virt-manager) 要连接到远程主机,虚拟机管理器需要第 11.3.2.3 节,“配置客户端并测试设置”中解释的设置。要能够通过 VNC 进行连接,还必须将客户端证书放置在以下位置

- 系统范围位置

/etc/pki/CA/cacert.pem/etc/pki/libvirt-vnc/clientcert.pem/etc/pki/libvirt-vnc/private/clientkey.pem- 每个用户位置

/etc/pki/CA/cacert.pem~/.pki/libvirt-vnc/clientcert.pem~/.pki/libvirt-vnc/private/clientkey.pem

virt-viewervirt-viewer仅接受来自系统范围位置的证书/etc/pki/CA/cacert.pem/etc/pki/libvirt-vnc/clientcert.pem/etc/pki/libvirt-vnc/private/clientkey.pem

每个 x509 证书由两部分组成:公共证书和私钥。客户端只能使用这两部分进行身份验证。因此,任何有权读取客户端证书及其私钥的用户都可以访问您的虚拟机主机服务器。另一方面,拥有完整服务器证书的任意机器都可以冒充虚拟机主机服务器。由于这不可取,因此必须尽可能限制对至少私钥文件的访问。控制对密钥文件的访问的最简单方法是使用访问权限。

- 服务器证书

QEMU 进程需要可读服务器证书。在 openSUSE Leap QEMU 上,从

libvirt工具启动的进程归root所有,因此root可以读取证书就足够了。>chmod 700 /etc/pki/libvirt/private/>chmod 600 /etc/pki/libvirt/private/serverkey.pem如果您在

/etc/libvirt/qemu.conf中更改了 QEMU 进程的所有权,您还需要调整密钥文件的所有权。- 系统范围的客户端证书

要控制对系统范围可用的密钥文件的访问,请将读取访问权限限制为某个组,以便只有该组成员才能读取密钥文件。在以下示例中,创建了一个

libvirt组,并将clientkey.pem文件及其父目录的组所有权设置为libvirt。之后,将访问权限限制为所有者和组。最后,将用户tux添加到libvirt组,从而可以访问密钥文件。CERTPATH="/etc/pki/libvirt/" # create group libvirt groupadd libvirt # change ownership to user root and group libvirt chown root.libvirt $CERTPATH/private $CERTPATH/clientkey.pem # restrict permissions chmod 750 $CERTPATH/private chmod 640 $CERTPATH/private/clientkey.pem # add user tux to group libvirt usermod --append --groups libvirt tux

- 每个用户证书

通过 VNC 访问虚拟机客户机的图形控制台的用户特定客户端证书需要放置在用户主目录的

~/.pki中。与 SSH 等不同,使用这些证书的 VNC 查看器不检查私钥文件的访问权限。因此,用户有责任确保密钥文件不被其他人读取。

默认情况下,每个拥有适当客户端证书的客户端都可以连接到接受 TLS 连接的虚拟机主机服务器。因此,可以使用 SASL 的附加服务器端身份验证,如第 11.1.1.3 节,“使用 SASL 进行用户名和密码身份验证”中所述。