- 2.1 低负载机器上的

vmstat输出 - 2.2 高负载机器(CPU 绑定)上的

vmstat输出 - 3.1

/etc/logrotate.conf示例 - 4.1 简单 SystemTap 脚本

- 4.2 带计时器事件的探针

- 4.3 带格式说明符的

printf函数 - 4.4 使用全局变量

- 4.5 使用

tcp_connections.stp监控传入的 TCP 连接 - 12.1

cpupower frequency-info的示例输出 - 12.2

cpupower idle-info的示例输出 - 12.3 示例

cpupower monitor输出 - 20.1 使用软件时间戳的从时钟

- 20.2 使用硬件时间戳的从时钟

- 20.3 使用硬件时间戳的主时钟

- 20.4 使用软件时间戳的主时钟(通常不推荐)

版权所有 © 2006–2024 SUSE LLC 及其贡献者。保留所有权利。

在 GNU 自由文档许可协议第 1.2 版或(可选)第 1.3 版的条款下,允许复制、分发和/或修改本文档,其中本版权声明和许可协议为不变部分。许可协议第 1.2 版的副本包含在题为 “GNU 自由文档许可协议” 的章节中。

有关 SUSE 商标,请参阅 https://www.suse.com/company/legal/。所有第三方商标均为其各自所有者的财产。商标符号(®、™ 等)表示 SUSE 及其关联公司的商标。星号 (*) 表示第三方商标。

本书中的所有信息均经过仔细核实。但是,这不能保证完全准确。SUSE LLC、其关联公司、作者和译者对可能出现的错误或由此产生的后果不承担任何责任。

- 在线文档

我们的文档可在 https://doc.opensuse.net.cn 上在线获取。浏览或下载各种格式的文档。

注意:最新更新

最新的更新通常可在本文档的英文版本中获得。

- SUSE 知识库

如果您遇到问题,请查看在线提供的技术信息文档 (TID),网址为 https://www.suse.com/support/kb/。搜索 SUSE 知识库,以获取由客户需求驱动的已知解决方案。

- 在您的系统中

为了离线使用,发布说明也可用在您的系统上的

/usr/share/doc/release-notes下。各个软件包的文档可用在/usr/share/doc/packages下。许多命令也在其 手册页 中进行了描述。要查看它们,请运行

man,后跟特定的命令名称。如果您的系统上未安装man命令,请使用sudo zypper install man进行安装。

欢迎您对本文档提出反馈和贡献。以下是提供反馈的渠道:

- 错误报告

请在 https://bugzilla.opensuse.org/ 上报告文档问题。

为了简化此过程,请单击 HTML 版本本文档中标题旁边的 图标。这将预先选择 Bugzilla 中的正确产品和类别,并添加指向当前章节的链接。您可以立即开始编写错误报告。

需要一个 Bugzilla 帐户。

- 贡献

要贡献本文档,请单击 HTML 版本本文档中标题旁边的 图标。这将带您到 GitHub 上的源代码,您可以在那里打开一个拉取请求。

需要一个 GitHub 帐户。

注意: 仅适用于英文

“”图标仅适用于每份文档的英文版本。对于所有其他语言,请改用“”图标。

有关用于本文档的文档环境的更多信息,请参阅存储库的 README 文件。

- 邮件

您还可以将错误报告和有关文档的反馈发送至 <doc-team@suse.com>。请包含文档标题、产品版本和文档的发布日期。此外,请包含相关的章节编号和标题(或提供 URL),并提供问题的简洁描述。

- 帮助

如果您在 openSUSE Leap 上需要进一步的帮助,请参阅 https://en.opensuse.net.cn/Portal:Support。

本文档中使用了以下通知和排版约定:

/etc/passwd:目录名和文件名占位符:将 占位符 替换为实际值

PATH:环境变量ls、--help:命令、选项和参数user:用户名或组名软件包名:软件包的名称

Alt、Alt–F1:要按下的键或键组合。键以键盘上的大写字母显示。

、 › :菜单项、按钮

第 1 章,《“示例章节”:对本指南中另一个章节的交叉引用。

必须使用

root权限运行的命令。您也可以使用sudo命令以非特权用户的身份运行这些命令。#command>sudocommand可以由非特权用户运行的命令

>command命令可以通过行尾的反斜杠字符 (

\) 分成两行或多行。反斜杠告知 shell 命令调用将在行尾之后继续。>echoa b \ c d一个代码块,显示命令(前面带有提示符)和 shell 返回的相应输出。

>commandoutput通知

警告:警告通知

在继续之前您必须了解的重要信息。警告您有关安全问题、潜在的数据丢失、硬件损坏或物理危害。

重要:重要通知

在继续之前您应该了解的重要信息。

注意:注意通知

其他信息,例如关于软件版本差异的信息。

提示:提示通知

有用的信息,例如指南或实用建议。

紧凑型通知

其他信息,例如关于软件版本差异的信息。

有用的信息,例如指南或实用建议。

- 1 系统调优通用说明

本手册讨论如何找到性能问题的根源,并提供解决这些问题的手段。在开始调优系统之前,您应该确保已排除常见问题,并找到问题的原因。您还应该有一个详细的计划来调优系统,因为应用随机调优技巧无济于事,甚至可能使情况更糟。

过程 1.1: 调优系统的一般方法 #

指定需要解决的问题。

如果降级是新发生的,则确定系统最近的任何更改。

确定为什么该问题被视为性能问题。

指定可用于分析性能的指标。此指标可以是延迟、吞吐量、同时登录的最大用户数或最大活跃用户数。

使用上一步的指标测量当前性能。

确定应用程序花费时间最多的子系统。

监控系统和/或应用程序。

分析数据,分类时间花费在哪里。

调优上一步中确定的子系统。

使用相同的指标,在不监控的情况下重新测量当前性能。

如果性能仍然不可接受,请从步骤 3 重新开始。

在开始调优系统之前,请尝试尽可能准确地描述问题。诸如“系统很慢!”之类的语句不是一个有用的问题描述。例如,是需要普遍提高系统速度,还是仅在高峰时段提高速度,这可能会有所不同。

此外,请确保您可以对您的问题进行测量,否则您无法验证调优是否成功。您应该始终能够比较“之前”和“之后”。使用哪些指标取决于您正在研究的场景或应用程序。例如,相关的 Web 服务器指标可以用以下术语表示

- 延迟

交付页面所需的时间

- 吞吐量

每秒服务的页面数或每秒传输的兆字节数

- 活跃用户

在可接受的延迟内接收页面的同时,可以下载页面的最大用户数

性能问题通常是由网络或硬件问题、错误或配置问题引起的。在尝试调优系统之前,请务必排除以下问题

检查

systemd日志的输出(请参见《参考》手册,第 11 章“journalctl:查询systemd日志”)是否存在异常条目。检查(使用

top或ps)某个进程是否行为异常,占用了异常数量的 CPU 时间或内存。通过检查

/proc/net/dev检查网络问题。如果物理磁盘出现 I/O 问题,请确保不是由硬件问题(使用

smartmontools检查磁盘)或磁盘已满引起的。确保后台作业在服务器负载较低时执行。这些作业也应以低优先级运行(通过

nice设置)。如果机器使用相同资源运行多个服务,请考虑将服务移动到另一台服务器。

最后,确保您的软件是最新的。

查找瓶颈是调优系统中最困难的部分。openSUSE Leap 提供了许多工具来帮助您完成此任务。有关通用系统监控应用程序和日志文件分析的详细信息,请参见第二部分,“系统监控”。如果问题需要长时间的深入分析,Linux 内核提供了执行此类分析的方法。有关详细信息,请参见第三部分,“内核监控”。

收集数据后,需要对其进行分析。首先,检查服务器的硬件(内存、CPU、总线)及其 I/O 容量(磁盘、网络)是否足够。如果满足这些基本条件,系统可以通过调优获益。

对于所描述的每个命令,都提供了相关输出的示例。在示例中,第一行是命令本身(在 tux > 或 root # 之后)。省略的部分用方括号 ([...]) 表示,必要时会折行。长行的换行符用反斜杠 (\) 表示。

> command -x -y

output line 1

output line 2

output line 3 is annoyingly long, so long that \

we need to break it

output line 4

[...]

output line 98

output line 99描述已尽量简短,以便我们可以包含尽可能多的实用程序。所有命令的更多信息可以在手册页中找到。大多数命令也支持参数 --help,它会生成一个简短的可能参数列表。

虽然大多数 Linux 系统监控工具只监控系统的一个方面,但也有一些工具具有更广泛的范围。要获取概述并找出需要进一步检查的系统部分,请首先使用这些工具。

vmstat 收集有关进程、内存、I/O、中断和 CPU 的信息

vmstat [options] [delay [count]]

在不带延迟和计数参数的情况下调用时,它显示自上次重新启动以来的平均值。在带延迟值(以秒为单位)调用时,它显示给定期间的值(以下示例中为两秒)。计数的值指定 vmstat 应执行的更新次数。如果未指定,它将一直运行直到手动停止。

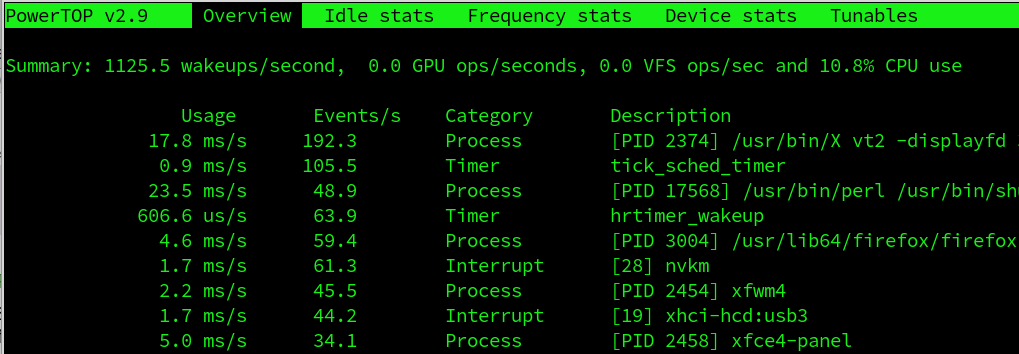

示例 2.1: 低负载机器上的 vmstat 输出 #

> vmstat 2

procs -----------memory---------- ---swap-- -----io---- -system-- ------cpu-----

r b swpd free buff cache si so bi bo in cs us sy id wa st

1 0 44264 81520 424 935736 0 0 12 25 27 34 1 0 98 0 0

0 0 44264 81552 424 935736 0 0 0 0 38 25 0 0 100 0 0

0 0 44264 81520 424 935732 0 0 0 0 23 15 0 0 100 0 0

0 0 44264 81520 424 935732 0 0 0 0 36 24 0 0 100 0 0

0 0 44264 81552 424 935732 0 0 0 0 51 38 0 0 100 0 0示例 2.2: 高负载机器(CPU 绑定)上的 vmstat 输出 #

> vmstat 2

procs -----------memory----------- ---swap-- -----io---- -system-- -----cpu------

r b swpd free buff cache si so bi bo in cs us sy id wa st

32 1 26236 459640 110240 6312648 0 0 9944 2 4552 6597 95 5 0 0 0

23 1 26236 396728 110336 6136224 0 0 9588 0 4468 6273 94 6 0 0 0

35 0 26236 554920 110508 6166508 0 0 7684 27992 4474 4700 95 5 0 0 0

28 0 26236 518184 110516 6039996 0 0 10830 4 4446 4670 94 6 0 0 0

21 5 26236 716468 110684 6074872 0 0 8734 20534 4512 4061 96 4 0 0 0提示:输出的第一行

vmstat 输出的第一行始终显示自上次重新启动以来的平均值。

列显示以下内容

显示处于可运行状态的进程数。这些进程要么正在执行,要么正在等待空闲的 CPU 插槽。如果此列中的进程数持续高于可用的 CPU 数,则可能表明 CPU 功率不足。

显示正在等待 CPU 以外资源的进程数。此列中的高数字可能表示 I/O 问题(网络或磁盘)。

当前使用的交换空间量 (KB)。

未使用的内存量 (KB)。

最近未使用的内存,可以回收。此列仅在调用

vmstat时带参数-a(推荐)时可见。最近使用的内存,通常不会被回收。此列仅在调用

vmstat时带参数-a(推荐)时可见。RAM 中的文件缓冲区缓存 (KB),包含文件系统元数据。此列在调用

vmstat时带参数-a时不可见。RAM 中的页面缓存 (KB),包含文件的实际内容。此列在调用

vmstat时带参数-a时不可见。每秒从交换空间移至 RAM (

si) 或从 RAM 移至交换空间 (so) 的数据量 (KB)。长时间的so值高可能表示应用程序内存泄漏,泄漏的内存正在被换出。长时间的si值高可能表示长时间不活动的应用程序现在又活跃了。长时间同时出现高si和so值是交换颠簸的证据,可能表示系统需要安装更多 RAM,因为没有足够的内存来容纳工作集大小。每秒从块设备接收的块数(例如,磁盘读取)。交换也会影响此处显示的值。块大小可能因文件系统而异,但可以使用 stat 实用程序确定。如果需要吞吐量数据,可以使用 iostat。

每秒发送到块设备的块数(例如,磁盘写入)。交换也会影响此处显示的值。

每秒中断数。高值可能表示高 I/O 级别(网络和/或磁盘),但也可能由其他原因触发,例如由其他活动触发的处理器间中断。务必检查

/proc/interrupts以确定中断源。每秒上下文切换数。这是内核将内存中一个程序的执行代码替换为另一个程序的执行代码的次数。

执行应用程序代码的 CPU 使用率百分比。

执行内核代码的 CPU 使用率百分比。

CPU 空闲时间百分比。如果此值在较长时间内为零,则您的 CPU 正在满负荷工作。这不一定是坏事——请参阅 和 列中的值以确定您的机器是否配备了足够的 CPU 功率。

如果“wa”时间非零,则表示由于等待 I/O 而丢失的吞吐量。这可能是不可避免的,例如,如果文件首次读取,后台回写无法跟上等等。它也可能是硬件瓶颈(网络或硬盘)的指标。最后,它可能表示虚拟内存管理器存在调优潜力(请参阅第 15 章,调优内存管理子系统)。

从虚拟机窃取的 CPU 时间百分比。

有关更多选项,请参见 vmstat --help。

dstat 是 vmstat、iostat、netstat 或 ifstat 等工具的替代品。dstat 实时显示系统资源的信息。例如,您可以将磁盘使用情况与 IDE 控制器的中断相结合进行比较,或者将网络带宽与磁盘吞吐量(在同一时间间隔内)进行比较。

默认情况下,其输出以可读表格的形式呈现。或者,可以生成 CSV 输出,适用于作为电子表格导入格式。

它用 Python 编写,可以通过插件进行增强。

这是通用语法

dstat [-afv] [OPTIONS..] [DELAY [COUNT]]

所有选项和参数都是可选的。不带任何参数时,dstat 显示有关 CPU (-c, --cpu)、磁盘 (-d, --disk)、网络 (-n, --net)、分页 (-g, --page) 以及系统中断和上下文切换 (-y, --sys) 的统计信息;它每秒刷新输出,无限期地

#dstatYou did not select any stats, using -cdngy by default. ----total-cpu-usage---- -dsk/total- -net/total- ---paging-- ---system-- usr sys idl wai hiq siq| read writ| recv send| in out | int csw 0 0 100 0 0 0| 15k 44k| 0 0 | 0 82B| 148 194 0 0 100 0 0 0| 0 0 |5430B 170B| 0 0 | 163 187 0 0 100 0 0 0| 0 0 |6363B 842B| 0 0 | 196 185

-a,--all等同于

-cdngy(默认)-f,--full扩展

-C、-D、-I、-N和-S发现列表-v,--vmstat等同于

-pmgdsc,-D total

- DELAY

每次更新之间的延迟(秒)

- COUNT

退出前要显示的更新次数

默认延迟为 1,计数未指定(无限制)。

有关更多信息,请参阅 dstat 的手册页及其网页:http://dag.wieers.com/home-made/dstat/。

sar 可以生成关于几乎所有重要系统活动的详细报告,其中包括 CPU、内存、IRQ 使用情况、I/O 和网络。它还可以实时生成报告。sar 命令从 /proc 文件系统收集数据。

注意:sysstat 包

sar 命令是 sysstat 软件包的一部分。使用 YaST 或 zypper in sysstat 命令安装它。sysstat.service 默认不启动,必须使用以下命令启用并启动

>sudosystemctl enable --now sysstat

要实时生成报告,请调用带间隔(秒)和计数的 sar。要从文件生成报告,请使用选项 -f 指定文件名,而不是间隔和计数。如果未指定文件名、间隔和计数,sar 会尝试从 /var/log/sa/saDD 生成报告,其中 DD 代表当前日期。这是 sadc(系统活动数据收集器)写入其数据的默认位置。使用多个 -f 选项查询多个文件。

sar 2 10 # real time report, 10 times every 2 seconds sar -f ~/reports/sar_2014_07_17 # queries file sar_2014_07_17 sar # queries file from today in /var/log/sa/ cd /var/log/sa && \ sar -f sa01 -f sa02 # queries files /var/log/sa/0[12]

在下方找到有用的 sar 调用及其解释的示例。有关每列含义的详细信息,请参阅 sar 的 man (1)。

注意:服务停止时的 sysstat 报告

当 sysstat 服务停止时(例如,在重启或关机期间),该工具仍会通过自动运行 /usr/lib64/sa/sa1 -S ALL 1 1 命令来收集最后时刻的统计信息。收集到的二进制数据存储在系统活动数据文件中。

在不带选项调用时,sar 显示关于 CPU 使用率的基本报告。在多处理器机器上,所有 CPU 的结果都会汇总。使用选项 -P ALL 还可以查看单个 CPU 的统计信息。

# sar 10 5

Linux 6.4.0-150600.9-default (jupiter) 03/11/2024 _x86_64_ (2 CPU)

17:51:29 CPU %user %nice %system %iowait %steal %idle

17:51:39 all 57,93 0,00 9,58 1,01 0,00 31,47

17:51:49 all 32,71 0,00 3,79 0,05 0,00 63,45

17:51:59 all 47,23 0,00 3,66 0,00 0,00 49,11

17:52:09 all 53,33 0,00 4,88 0,05 0,00 41,74

17:52:19 all 56,98 0,00 5,65 0,10 0,00 37,27

Average: all 49,62 0,00 5,51 0,24 0,00 44,62显示 CPU 在等待 I/O 请求时空闲的时间百分比。如果此值在很长一段时间内远高于零,则 I/O 系统(网络或硬盘)存在瓶颈。如果 值在很长一段时间内为零,则您的 CPU 正在满负荷工作。

使用选项 -r 生成系统内存 (RAM) 的总体情况

# sar -r 10 5

Linux 6.4.0-150600.9-default (jupiter) 03/11/2024 _x86_64_ (2 CPU)

17:55:27 kbmemfree kbmemused %memused kbbuffers kbcached kbcommit %commit kbactive kbinact kbdirty

17:55:37 104232 1834624 94.62 20 627340 2677656 66.24 802052 828024 1744

17:55:47 98584 1840272 94.92 20 624536 2693936 66.65 808872 826932 2012

17:55:57 87088 1851768 95.51 20 605288 2706392 66.95 827260 821304 1588

17:56:07 86268 1852588 95.55 20 599240 2739224 67.77 829764 820888 3036

17:56:17 104260 1834596 94.62 20 599864 2730688 67.56 811284 821584 3164

Average: 96086 1842770 95.04 20 611254 2709579 67.03 815846 823746 2309和 列显示当前工作负载可能需要的最大内存量(RAM 和交换空间)的近似值。 以千字节为单位显示绝对数字,而 显示百分比。

使用选项 -B 显示内核分页统计信息。

# sar -B 10 5

Linux 6.4.0-150600.9-default (jupiter) 03/11/2024 _x86_64_ (2 CPU)

18:23:01 pgpgin/s pgpgout/s fault/s majflt/s pgfree/s pgscank/s pgscand/s pgsteal/s %vmeff

18:23:11 366.80 11.60 542.50 1.10 4354.80 0.00 0.00 0.00 0.00

18:23:21 0.00 333.30 1522.40 0.00 18132.40 0.00 0.00 0.00 0.00

18:23:31 47.20 127.40 1048.30 0.10 11887.30 0.00 0.00 0.00 0.00

18:23:41 46.40 2.50 336.10 0.10 7945.00 0.00 0.00 0.00 0.00

18:23:51 0.00 583.70 2037.20 0.00 17731.90 0.00 0.00 0.00 0.00

Average: 92.08 211.70 1097.30 0.26 12010.28 0.00 0.00 0.00 0.00(每秒主错误)列显示从磁盘加载到内存的页面数。错误的来源可能是文件访问或错误。有时,许多主错误是正常的。例如,在应用程序启动期间。如果应用程序的整个生命周期都出现主错误,则可能表示主内存不足,特别是如果与大量直接扫描(pgscand/s)结合使用。

列显示扫描的页面数 () 与从主内存缓存或交换缓存重新使用的页面数 () 的关系。它是页面回收效率的度量。健康值要么接近 100(每个换出的非活动页面都被重新使用),要么为 0(没有页面被扫描)。该值不应低于 30。

使用选项 -d 显示块设备(硬盘、光驱、USB 存储设备等)。务必使用附加选项 -p (pretty-print) 以使 列可读。

# sar -d -p 10 5

Linux 6.4.0-150600.9-default (jupiter) 03/11/2024 _x86_64_ (2 CPU)

18:46:09 DEV tps rd_sec/s wr_sec/s avgrq-sz avgqu-sz await svctm %util

18:46:19 sda 1.70 33.60 0.00 19.76 0.00 0.47 0.47 0.08

18:46:19 sr0 0.00 0.00 0.00 0.00 0.00 0.00 0.00 0.00

18:46:19 DEV tps rd_sec/s wr_sec/s avgrq-sz avgqu-sz await svctm %util

18:46:29 sda 8.60 114.40 518.10 73.55 0.06 7.12 0.93 0.80

18:46:29 sr0 0.00 0.00 0.00 0.00 0.00 0.00 0.00 0.00

18:46:29 DEV tps rd_sec/s wr_sec/s avgrq-sz avgqu-sz await svctm %util

18:46:39 sda 40.50 3800.80 454.90 105.08 0.36 8.86 0.69 2.80

18:46:39 sr0 0.00 0.00 0.00 0.00 0.00 0.00 0.00 0.00

18:46:39 DEV tps rd_sec/s wr_sec/s avgrq-sz avgqu-sz await svctm %util

18:46:49 sda 1.40 0.00 204.90 146.36 0.00 0.29 0.29 0.04

18:46:49 sr0 0.00 0.00 0.00 0.00 0.00 0.00 0.00 0.00

18:46:49 DEV tps rd_sec/s wr_sec/s avgrq-sz avgqu-sz await svctm %util

18:46:59 sda 3.30 0.00 503.80 152.67 0.03 8.12 1.70 0.56

18:46:59 sr0 0.00 0.00 0.00 0.00 0.00 0.00 0.00 0.00

Average: DEV tps rd_sec/s wr_sec/s avgrq-sz avgqu-sz await svctm %util

Average: sda 11.10 789.76 336.34 101.45 0.09 8.07 0.77 0.86

Average: sr0 0.00 0.00 0.00 0.00 0.00 0.00 0.00 0.00比较所有磁盘的 、 和 的值。 和 列中持续高企的值可能表明 I/O 子系统是瓶颈。

如果机器使用多个磁盘,那么最好在速度和容量相同的磁盘之间均匀交错 I/O。需要考虑存储是否具有多层。此外,如果存储有多个路径,那么在平衡存储使用方式时,要考虑链路饱和的程度。

sar 报告对于人类来说并不总是容易解析的。kSar 是一个 Java 应用程序,它可视化您的 sar 数据,创建易于阅读的图表。它甚至可以生成 PDF 报告。kSar 接收实时生成的数据以及文件中的历史数据。kSar 在 BSD 许可证下获得许可,可从 https://sourceforge.net/projects/ksar/ 获取。

要监控系统设备负载,请使用 iostat。它会生成报告,有助于更好地平衡连接到系统的物理磁盘之间的负载。

要使用 iostat,请安装 sysstat 软件包。

第一个 iostat 报告显示自系统启动以来收集的统计信息。随后的报告涵盖自上次报告以来的时间。

> iostat

Linux 6.4.0-150600.9-default (jupiter) 03/11/2024 _x86_64_ (4 CPU)

avg-cpu: %user %nice %system %iowait %steal %idle

17.68 4.49 4.24 0.29 0.00 73.31

Device: tps kB_read/s kB_wrtn/s kB_read kB_wrtn

sdb 2.02 36.74 45.73 3544894 4412392

sda 1.05 5.12 13.47 493753 1300276

sdc 0.02 0.14 0.00 13641 37以这种方式调用 iostat 有助于您找出吞吐量是否与您的预期不同,但不能说明原因。通过调用 iostat -x 生成扩展报告可以更好地回答此类问题。扩展报告还包括例如平均队列大小和平均等待时间的信息。如果使用 -z 开关排除空闲块设备,评估数据也可能更容易。在 iostat 的手册页(man 1 iostat)中查找每个显示列标题的定义。

您还可以指定在指定间隔监控某个设备。例如,要为设备 sda 在三秒间隔内生成五个报告,请使用

>iostat-p sda 3 5

要显示网络文件系统 (NFS) 的统计信息,有两个类似的实用程序

nfsiostat-sysstat包含在 sysstat 软件包中。nfsiostat包含在 nfs-client 软件包中。

注意:在多路径设置中使用 iostat

iostat 命令可能不会显示 nvme list-subsys 列出的所有控制器。默认情况下,iostat 会过滤掉所有没有 I/O 的块设备。要使 iostat 显示所有设备,请使用以下命令

> iostat -p ALL实用程序 mpstat 检查每个可用处理器的活动。如果您的系统只有一个处理器,则报告全局平均统计信息。

计时参数的工作方式与 iostat 命令相同。输入 mpstat 2 5 将在两秒间隔内为所有处理器打印五个报告。

# mpstat 2 5

Linux 6.4.0-150600.9-default (jupiter) 03/11/2024 _x86_64_ (2 CPU)

13:51:10 CPU %usr %nice %sys %iowait %irq %soft %steal %guest %gnice %idle

13:51:12 all 8,27 0,00 0,50 0,00 0,00 0,00 0,00 0,00 0,00 91,23

13:51:14 all 46,62 0,00 3,01 0,00 0,00 0,25 0,00 0,00 0,00 50,13

13:51:16 all 54,71 0,00 3,82 0,00 0,00 0,51 0,00 0,00 0,00 40,97

13:51:18 all 78,77 0,00 5,12 0,00 0,00 0,77 0,00 0,00 0,00 15,35

13:51:20 all 51,65 0,00 4,30 0,00 0,00 0,51 0,00 0,00 0,00 43,54

Average: all 47,85 0,00 3,34 0,00 0,00 0,40 0,00 0,00 0,00 48,41从 mpstat 数据中,您可以看到

和 之间的比率。例如,10:1 的比率表明工作负载主要运行应用程序代码,分析应侧重于应用程序。1:10 的比率表明工作负载主要受内核限制,值得考虑调优内核。或者,确定应用程序受内核限制的原因,并查看是否可以缓解。

即使系统总体负载较轻,是否存在一部分 CPU 几乎完全利用。少数热 CPU 可能表明工作负载未并行化,并且可以通过在具有较少数量更快处理器的机器上执行而受益。

turbostat 显示 AMD64/Intel 64 处理器的频率、负载、温度和功耗。它可以在两种模式下运行:如果带命令调用,则分叉命令进程,并在命令完成后显示统计信息。如果无命令运行,则每五秒显示更新的统计信息。turbostat 需要加载内核模块 msr。

>sudoturbostat find /etc -type d -exec true {} \; 0.546880 sec CPU Avg_MHz Busy% Bzy_MHz TSC_MHz - 416 28.43 1465 3215 0 631 37.29 1691 3215 1 416 27.14 1534 3215 2 270 24.30 1113 3215 3 406 26.57 1530 3214 4 505 32.46 1556 3214 5 270 22.79 1184 3214

输出取决于 CPU 类型,并且可能会有所不同。要显示更多详细信息,例如温度和功耗,请使用 --debug 选项。有关更多命令行选项和字段说明,请参阅 man 8 turbostat。

如果您需要查看特定任务对系统造成的负载,请使用 pidstat 命令。它打印每个选定任务或如果未指定任务则打印 Linux 内核管理的所有任务的活动。您还可以设置要显示的报告数量以及它们之间的时间间隔。

例如,pidstat -C firefox 2 3 打印命令名称包含字符串“firefox”的任务的负载统计信息。每两秒打印三个报告。

# pidstat -C firefox 2 3

Linux 6.4.0-150600.9-default (jupiter) 03/11/2024 _x86_64_ (2 CPU)

14:09:11 UID PID %usr %system %guest %CPU CPU Command

14:09:13 1000 387 22,77 0,99 0,00 23,76 1 firefox

14:09:13 UID PID %usr %system %guest %CPU CPU Command

14:09:15 1000 387 46,50 3,00 0,00 49,50 1 firefox

14:09:15 UID PID %usr %system %guest %CPU CPU Command

14:09:17 1000 387 60,50 7,00 0,00 67,50 1 firefox

Average: UID PID %usr %system %guest %CPU CPU Command

Average: 1000 387 43,19 3,65 0,00 46,84 - firefox同样,pidstat -d 可用于估计 I/O 任务正在进行多少 I/O,它们是否正在该 I/O 上休眠,以及任务停滞了多少时钟周期。

Linux 内核将某些消息保存在环形缓冲区中。要查看这些消息,请输入命令 dmesg -T。

较旧的事件记录在 systemd 日志中。有关日志的更多信息,请参见《参考》手册,第 11 章“journalctl:查询 systemd 日志”。

要查看进程 ID 为 PID 的进程的所有打开文件列表,请使用 -p。例如,要查看当前 shell 使用的所有文件,请输入

# lsof -p $$

COMMAND PID USER FD TYPE DEVICE SIZE/OFF NODE NAME

bash 8842 root cwd DIR 0,32 222 6772 /root

bash 8842 root rtd DIR 0,32 166 256 /

bash 8842 root txt REG 0,32 656584 31066 /bin/bash

bash 8842 root mem REG 0,32 1978832 22993 /lib64/libc-2.19.so

[...]

bash 8842 root 2u CHR 136,2 0t0 5 /dev/pts/2

bash 8842 root 255u CHR 136,2 0t0 5 /dev/pts/2已使用特殊的 shell 变量 $$,其值为 shell 的进程 ID。

与 -i 结合使用时,lsof 还会列出当前打开的 Internet 文件

# lsof -i

COMMAND PID USER FD TYPE DEVICE SIZE/OFF NODE NAME

wickedd-d 917 root 8u IPv4 16627 0t0 UDP *:bootpc

wickedd-d 918 root 8u IPv6 20752 0t0 UDP [fe80::5054:ff:fe72:5ead]:dhcpv6-client

sshd 3152 root 3u IPv4 18618 0t0 TCP *:ssh (LISTEN)

sshd 3152 root 4u IPv6 18620 0t0 TCP *:ssh (LISTEN)

master 4746 root 13u IPv4 20588 0t0 TCP localhost:smtp (LISTEN)

master 4746 root 14u IPv6 20589 0t0 TCP localhost:smtp (LISTEN)

sshd 8837 root 5u IPv4 293709 0t0 TCP jupiter.suse.de:ssh->venus.suse.de:33619 (ESTABLISHED)

sshd 8837 root 9u IPv6 294830 0t0 TCP localhost:x11 (LISTEN)

sshd 8837 root 10u IPv4 294831 0t0 TCP localhost:x11 (LISTEN)

udevadm monitor 侦听内核 uevents 和 udev 规则发送的事件,并将事件的设备路径 (DEVPATH) 打印到控制台。这是连接 USB 记忆棒时的一系列事件

注意:监控 udev 事件

只有 root 用户被允许通过运行 udevadm 命令来监控 udev 事件。

UEVENT[1138806687] add@/devices/pci0000:00/0000:00:1d.7/usb4/4-2/4-2.2 UEVENT[1138806687] add@/devices/pci0000:00/0000:00:1d.7/usb4/4-2/4-2.2/4-2.2 UEVENT[1138806687] add@/class/scsi_host/host4 UEVENT[1138806687] add@/class/usb_device/usbdev4.10 UDEV [1138806687] add@/devices/pci0000:00/0000:00:1d.7/usb4/4-2/4-2.2 UDEV [1138806687] add@/devices/pci0000:00/0000:00:1d.7/usb4/4-2/4-2.2/4-2.2 UDEV [1138806687] add@/class/scsi_host/host4 UDEV [1138806687] add@/class/usb_device/usbdev4.10 UEVENT[1138806692] add@/devices/pci0000:00/0000:00:1d.7/usb4/4-2/4-2.2/4-2.2 UEVENT[1138806692] add@/block/sdb UEVENT[1138806692] add@/class/scsi_generic/sg1 UEVENT[1138806692] add@/class/scsi_device/4:0:0:0 UDEV [1138806693] add@/devices/pci0000:00/0000:00:1d.7/usb4/4-2/4-2.2/4-2.2 UDEV [1138806693] add@/class/scsi_generic/sg1 UDEV [1138806693] add@/class/scsi_device/4:0:0:0 UDEV [1138806693] add@/block/sdb UEVENT[1138806694] add@/block/sdb/sdb1 UDEV [1138806694] add@/block/sdb/sdb1 UEVENT[1138806694] mount@/block/sdb/sdb1 UEVENT[1138806697] umount@/block/sdb/sdb1

命令 ipcs 生成当前正在使用的 IPC 资源列表

# ipcs

------ Message Queues --------

key msqid owner perms used-bytes messages

------ Shared Memory Segments --------

key shmid owner perms bytes nattch status

0x00000000 65536 tux 600 524288 2 dest

0x00000000 98305 tux 600 4194304 2 dest

0x00000000 884738 root 600 524288 2 dest

0x00000000 786435 tux 600 4194304 2 dest

0x00000000 12058628 tux 600 524288 2 dest

0x00000000 917509 root 600 524288 2 dest

0x00000000 12353542 tux 600 196608 2 dest

0x00000000 12451847 tux 600 524288 2 dest

0x00000000 11567114 root 600 262144 1 dest

0x00000000 10911763 tux 600 2097152 2 dest

0x00000000 11665429 root 600 2336768 2 dest

0x00000000 11698198 root 600 196608 2 dest

0x00000000 11730967 root 600 524288 2 dest

------ Semaphore Arrays --------

key semid owner perms nsems

0xa12e0919 32768 tux 666 2命令 ps 生成进程列表。大多数参数必须不带减号写入。有关简要帮助,请参阅 ps --help,或有关详细帮助,请参阅手册页。

要列出所有带有用户和命令行信息的进程,请使用 ps axu

> ps axu

USER PID %CPU %MEM VSZ RSS TTY STAT START TIME COMMAND

root 1 0.0 0.3 34376 4608 ? Ss Jul24 0:02 /usr/lib/systemd/systemd

root 2 0.0 0.0 0 0 ? S Jul24 0:00 [kthreadd]

root 3 0.0 0.0 0 0 ? S Jul24 0:00 [ksoftirqd/0]

root 5 0.0 0.0 0 0 ? S< Jul24 0:00 [kworker/0:0H]

root 6 0.0 0.0 0 0 ? S Jul24 0:00 [kworker/u2:0]

root 7 0.0 0.0 0 0 ? S Jul24 0:00 [migration/0]

[...]

tux 12583 0.0 0.1 185980 2720 ? Sl 10:12 0:00 /usr/lib/gvfs/gvfs-mtp-volume-monitor

tux 12587 0.0 0.1 198132 3044 ? Sl 10:12 0:00 /usr/lib/gvfs/gvfs-gphoto2-volume-monitor

tux 12591 0.0 0.1 181940 2700 ? Sl 10:12 0:00 /usr/lib/gvfs/gvfs-goa-volume-monitor

tux 12594 8.1 10.6 1418216 163564 ? Sl 10:12 0:03 /usr/bin/gnome-shell

tux 12600 0.0 0.3 393448 5972 ? Sl 10:12 0:00 /usr/lib/gnome-settings-daemon-3.0/gsd-printer

tux 12625 0.0 0.6 227776 10112 ? Sl 10:12 0:00 /usr/lib/gnome-control-center-search-provider

tux 12626 0.5 1.5 890972 23540 ? Sl 10:12 0:00 /usr/bin/nautilus --no-default-window

[...]要检查有多少 sshd 进程正在运行,请将选项 -p 与命令 pidof 一起使用,该命令列出给定进程的进程 ID。

> ps -p $(pidof sshd)

PID TTY STAT TIME COMMAND

1545 ? Ss 0:00 /usr/sbin/sshd -D

4608 ? Ss 0:00 sshd: root@pts/0进程列表可以根据您的需要进行格式化。选项 L 返回所有关键字的列表。输入以下命令以发出按内存使用情况排序的所有进程列表

> ps ax --format pid,rss,cmd --sort rss

PID RSS CMD

PID RSS CMD

2 0 [kthreadd]

3 0 [ksoftirqd/0]

4 0 [kworker/0:0]

5 0 [kworker/0:0H]

6 0 [kworker/u2:0]

7 0 [migration/0]

8 0 [rcu_bh]

[...]

12518 22996 /usr/lib/gnome-settings-daemon-3.0/gnome-settings-daemon

12626 23540 /usr/bin/nautilus --no-default-window

12305 32188 /usr/bin/Xorg :0 -background none -verbose

12594 164900 /usr/bin/gnome-shell有用的 ps 调用 #

ps aux--sort COLUMN按 COLUMN 排序输出。将 COLUMN 替换为

pmem表示物理内存比率pcpu表示 CPU 比率rss表示常驻集大小(未交换的物理内存)ps axo pid,%cpu,rss,vsz,args,wchan显示每个进程、其 PID、CPU 使用率、内存大小(常驻和虚拟)、名称及其系统调用。

ps axfo pid,args显示进程树。

命令 pstree 生成树形进程列表

> pstree

systemd---accounts-daemon---{gdbus}

| |-{gmain}

|-at-spi-bus-laun---dbus-daemon

| |-{dconf worker}

| |-{gdbus}

| |-{gmain}

|-at-spi2-registr---{gdbus}

|-cron

|-2*[dbus-daemon]

|-dbus-launch

|-dconf-service---{gdbus}

| |-{gmain}

|-gconfd-2

|-gdm---gdm-simple-slav---Xorg

| | |-gdm-session-wor---gnome-session---gnome-setti+

| | | | |-gnome-shell+++

| | | | |-{dconf work+

| | | | |-{gdbus}

| | | | |-{gmain}

| | | |-{gdbus}

| | | |-{gmain}

| | |-{gdbus}

| | |-{gmain}

| |-{gdbus}

| |-{gmain}

[...]参数 -p 将进程 ID 添加到给定名称。要同时显示命令行,请使用参数 -a

命令 top(“进程表”的缩写)显示进程列表,每两秒刷新一次。要停止程序,请按 Q。参数 -n 1 在显示一次进程列表后停止程序。以下是命令 top -n 1 的示例输出

> top -n 1

Tasks: 128 total, 1 running, 127 sleeping, 0 stopped, 0 zombie

%Cpu(s): 2.4 us, 1.2 sy, 0.0 ni, 96.3 id, 0.1 wa, 0.0 hi, 0.0 si, 0.0 st

KiB Mem: 1535508 total, 699948 used, 835560 free, 880 buffers

KiB Swap: 1541116 total, 0 used, 1541116 free. 377000 cached Mem

PID USER PR NI VIRT RES SHR S %CPU %MEM TIME+ COMMAND

1 root 20 0 116292 4660 2028 S 0.000 0.303 0:04.45 systemd

2 root 20 0 0 0 0 S 0.000 0.000 0:00.00 kthreadd

3 root 20 0 0 0 0 S 0.000 0.000 0:00.07 ksoftirqd+

5 root 0 -20 0 0 0 S 0.000 0.000 0:00.00 kworker/0+

6 root 20 0 0 0 0 S 0.000 0.000 0:00.00 kworker/u+

7 root rt 0 0 0 0 S 0.000 0.000 0:00.00 migration+

8 root 20 0 0 0 0 S 0.000 0.000 0:00.00 rcu_bh

9 root 20 0 0 0 0 S 0.000 0.000 0:00.24 rcu_sched

10 root rt 0 0 0 0 S 0.000 0.000 0:00.01 watchdog/0

11 root 0 -20 0 0 0 S 0.000 0.000 0:00.00 khelper

12 root 20 0 0 0 0 S 0.000 0.000 0:00.00 kdevtmpfs

13 root 0 -20 0 0 0 S 0.000 0.000 0:00.00 netns

14 root 0 -20 0 0 0 S 0.000 0.000 0:00.00 writeback

15 root 0 -20 0 0 0 S 0.000 0.000 0:00.00 kintegrit+

16 root 0 -20 0 0 0 S 0.000 0.000 0:00.00 bioset

17 root 0 -20 0 0 0 S 0.000 0.000 0:00.00 crypto

18 root 0 -20 0 0 0 S 0.000 0.000 0:00.00 kblockd默认情况下,输出按 CPU 使用率( 列,快捷键 Shift–P)排序。使用以下组合键更改排序字段

| Shift–M:常驻内存 () |

| Shift–N:进程 ID () |

| Shift–T:时间 () |

要使用任何其他字段进行排序,请按 F 并从列表中选择一个字段。要切换排序顺序,请使用 Shift–R。

参数 -U UID 仅监控与特定用户关联的进程。将 UID 替换为用户的用户 ID。使用 top -U $(id -u) 显示当前用户的进程

iotop 实用程序显示进程或线程的 I/O 使用情况表。

注意:安装 iotop

iotop 默认未安装。您需要以 root 身份使用 zypper in iotop 手动安装。

iotop 显示采样期间每个进程读取和写入的 I/O 带宽列。它还显示进程在交换和等待 I/O 期间花费的时间百分比。对于每个进程,都会显示其 I/O 优先级(类/级别)。此外,采样期间读取和写入的总 I/O 带宽显示在界面的顶部。

← 和 → 键更改排序。

R 反转排序顺序。

O 在显示所有进程和线程(默认视图)和仅显示正在执行 I/O 的进程之间切换。(此功能类似于在命令行上添加

--only。)P 在显示线程(默认视图)和进程之间切换。(此功能类似于

--only。)A 在显示当前 I/O 带宽(默认视图)和

iotop启动以来累积的 I/O 操作之间切换。(此功能类似于--accumulated。)I 允许您更改线程或进程线程的优先级。

Q 退出

iotop。按任何其他键强制刷新。

以下是 iotop --only 命令的示例输出,同时 find 和 emacs 正在运行

# iotop --only

Total DISK READ: 50.61 K/s | Total DISK WRITE: 11.68 K/s

TID PRIO USER DISK READ DISK WRITE SWAPIN IO> COMMAND

3416 be/4 tux 50.61 K/s 0.00 B/s 0.00 % 4.05 % find /

275 be/3 root 0.00 B/s 3.89 K/s 0.00 % 2.34 % [jbd2/sda2-8]

5055 be/4 tux 0.00 B/s 3.89 K/s 0.00 % 0.04 % emacs

iotop 也可以在批处理模式 (-b) 下使用,其输出可以存储在文件中以供以后分析。有关完整的选项集,请参阅手册页 (man 8 iotop)。

内核通过进程的 nice 级别(也称为 niceness)来确定哪些进程需要比其他进程更多的 CPU 时间。进程的“nice”级别越高,它从其他进程占用的 CPU 时间就越少。Nice 级别范围从 -20(最“不nice”的级别)到 19。负值只能由 root 设置。

当运行一个不重要的、持续时间长且使用大量 CPU 时间的进程时,调整 niceness 级别很有用。例如,在同时执行其他任务的系统上编译内核。使此类进程“更nice”可确保其他任务(例如 Web 服务器)具有更高的优先级。

不带任何参数调用 nice 会打印当前 niceness

> nice

0运行 nice COMMAND 会将给定命令的当前 nice 级别增加 10。使用 nice -n LEVEL COMMAND 允许您指定相对于当前级别的新 nice 级别。

要更改正在运行的进程的 niceness,请使用 renice PRIORITY -p PROCESS_ID,例如

> renice +5 3266要恢复特定用户拥有的所有进程的 niceness,请使用选项 -u USER。进程组通过选项 -g PROCESS_GROUP_ID 进行 renice。

实用程序 free 检查 RAM 和交换空间使用情况。显示了空闲和已用内存以及交换区域的详细信息

> free

total used free shared buffers cached

Mem: 32900500 32703448 197052 0 255668 5787364

-/+ buffers/cache: 26660416 6240084

Swap: 2046972 304680 1742292选项 -b、-k、-m、-g 分别以字节、KB、MB 或 GB 显示输出。参数 -s delay 确保显示每 DELAY 秒刷新一次。例如,free -s 1.5 每 1.5 秒更新一次。

使用 /proc/meminfo 获取比 free 更详细的内存使用信息。实际上,free 使用此文件中的某些数据。以下是 64 位系统的示例输出,它在 32 位系统上因内存管理不同而略有不同

MemTotal: 1942636 kB MemFree: 1294352 kB MemAvailable: 1458744 kB Buffers: 876 kB Cached: 278476 kB SwapCached: 0 kB Active: 368328 kB Inactive: 199368 kB Active(anon): 288968 kB Inactive(anon): 10568 kB Active(file): 79360 kB Inactive(file): 188800 kB Unevictable: 80 kB Mlocked: 80 kB SwapTotal: 2103292 kB SwapFree: 2103292 kB Dirty: 44 kB Writeback: 0 kB AnonPages: 288592 kB Mapped: 70444 kB Shmem: 11192 kB Slab: 40916 kB SReclaimable: 17712 kB SUnreclaim: 23204 kB KernelStack: 2000 kB PageTables: 10996 kB NFS_Unstable: 0 kB Bounce: 0 kB WritebackTmp: 0 kB CommitLimit: 3074608 kB Committed_AS: 1407208 kB VmallocTotal: 34359738367 kB VmallocUsed: 145996 kB VmallocChunk: 34359588844 kB HardwareCorrupted: 0 kB AnonHugePages: 86016 kB HugePages_Total: 0 HugePages_Free: 0 HugePages_Rsvd: 0 HugePages_Surp: 0 Hugepagesize: 2048 kB DirectMap4k: 79744 kB DirectMap2M: 2017280 kB

这些条目代表以下内容

RAM 总量。

未使用的 RAM 量。

不进行交换即可启动新应用程序的可用内存估计值。

RAM 中的文件缓冲区缓存,包含文件系统元数据。

RAM 中的页面缓存。这不包括缓冲区缓存和交换缓存,但包括 内存。

已换出内存的页面缓存。

- , ,

最近使用的内存,除非必要或显式请求,否则不会回收。 是 和 的总和

跟踪交换支持的内存。这包括私有和共享匿名映射以及写时复制后的私有文件页面。

跟踪其他文件系统支持的内存。

- , ,

较少使用的内存,通常会首先回收。 是 和 的总和

跟踪交换支持的内存。这包括私有和共享匿名映射以及写时复制后的私有文件页面。

跟踪其他文件系统支持的内存。

无法回收的内存量(例如,因为它已 或用作 RAM 磁盘)。

由

mlock系统调用支持的内存量。mlock允许进程定义其虚拟内存应映射到物理 RAM 的哪个部分。但是,mlock不保证此放置。交换空间量。

未使用的交换空间量。

等待写入磁盘的内存量,因为它包含与后端存储相比的更改。脏数据可以通过应用程序或内核在短时间延迟后显式同步。大量的脏数据可能需要相当长的时间才能写入磁盘,从而导致停滞。任何时候可以存在的脏数据总量可以通过

sysctl参数vm.dirty_ratio或vm.dirty_bytes进行控制(有关更多详细信息,请参阅第 15.1.5 节,“回写”)。当前正在写入磁盘的内存量。

使用

mmap系统调用声明的内存。进程组之间共享的内存,例如 IPC 数据、

tmpfs数据和共享匿名内存。用于内核内部数据结构的内存分配。

可以回收的 Slab 部分,例如缓存(inode、dentry 等)。

无法回收的 Slab 部分。

应用程序通过系统调用使用的内核空间内存量。

所有进程的页表专用内存量。

已发送到服务器但尚未提交的 NFS 页面。

用于块设备的跳板缓冲区内存。

FUSE 用于临时回写缓冲区的内存。

根据过量提交比率设置,系统可用的内存量。仅在启用严格过量提交记账时才强制执行。

在最坏情况下,当前工作负载所需的内存总量(RAM 和交换空间)的近似值。

分配的内核虚拟地址空间量。

已使用的内核虚拟地址空间量。

可用内核虚拟地址空间中最大的连续块。

故障内存量(只能在使用 ECC RAM 时检测到)。

映射到用户空间页表的匿名大页。这些是为进程透明分配的,无需专门请求,因此也称为透明大页 (THP)。

为

SHM_HUGETLB和MAP_HUGETLB或通过hugetlbfs文件系统预分配的大页数量,如/proc/sys/vm/nr_hugepages中定义。可用大页的数量。

已提交大页的数量。

超出 的可用大页数量(“过剩”),如

/proc/sys/vm/nr_overcommit_hugepages中定义。大页的大小——在 AMD64/Intel 64 上,默认值为 2048 KB。

- 等

映射到给定大小页面(在本例中:4 kB)的内核内存量。

使用 top 或 ps 等标准工具无法精确确定某个进程正在消耗多少内存。如果需要精确数据,请使用内核 2.6.14 中引入的 smaps 子系统。它位于 /proc/PID/smaps,它会显示 ID 为 PID 的进程当时正在使用的干净和脏内存页数。它区分共享内存和私有内存,因此您可以查看进程正在使用的内存量,而不包括与其他进程共享的内存。有关更多信息,请参阅 /usr/src/linux/Documentation/filesystems/proc.txt(需要安装 kernel-source 软件包)。

smaps 读取起来开销很大。因此,不建议定期监控它,而只在密切监控某个进程时使用。

numaTOP 是 NUMA(非统一内存访问)系统的一个工具。该工具通过提供 NUMA 系统的实时分析来帮助识别 NUMA 相关的性能瓶颈。

一般来说,numaTOP 允许您通过分析远程内存访问 (RMA) 的数量、本地内存访问 (LMA) 的数量以及 RMA/LMA 比率来识别和调查局部性差(即本地与远程内存使用率低)的进程和线程。

numaTOP 支持 PowerPC 和以下 Intel Xeon 处理器:5500 系列、6500/7500 系列、5600 系列、E7-x8xx 系列和 E5-16xx/24xx/26xx/46xx 系列。

numaTOP 在官方软件仓库中提供,您可以使用 sudo zypper in numatop 命令安装该工具。要启动 numaTOP,请运行 numatop 命令。要获取 numaTOP 功能和用法的概述,请使用 man numatop 命令。

提示:流量整形

如果网络带宽低于预期,您应该首先检查您的网络段是否激活了任何流量整形规则。

ip 是一个功能强大的工具,用于设置和控制网络接口。您还可以使用它快速查看有关系统网络接口的基本统计信息。例如,接口是否已启动,或者有多少错误、丢弃的数据包或数据包冲突。

如果您不带附加参数运行 ip,它会显示帮助输出。要列出所有网络接口,请输入 ip addr show(或缩写为 ip a)。ip addr show up 仅列出正在运行的网络接口。ip -s link show DEVICE 仅列出指定接口的统计信息

# ip -s link show br0

6: br0: <BROADCAST,MULTICAST,UP,LOWER_UP> mtu 1500 qdisc noqueue state UP mode DEFAULT

link/ether 00:19:d1:72:d4:30 brd ff:ff:ff:ff:ff:ff

RX: bytes packets errors dropped overrun mcast

6346104756 9265517 0 10860 0 0

TX: bytes packets errors dropped carrier collsns

3996204683 3655523 0 0 0 0

ip 还可以显示接口 (link)、路由表 (route) 以及更多内容——有关详细信息,请参阅 man 8 ip。

# ip route

default via 192.168.2.1 dev eth1

192.168.2.0/24 dev eth0 proto kernel scope link src 192.168.2.100

192.168.2.0/24 dev eth1 proto kernel scope link src 192.168.2.101

192.168.2.0/24 dev eth2 proto kernel scope link src 192.168.2.102# ip link

1: lo: <LOOPBACK,UP,LOWER_UP> mtu 65536 qdisc noqueue state UNKNOWN mode DEFAULT group default

link/loopback 00:00:00:00:00:00 brd 00:00:00:00:00:00

2: eth0: <BROADCAST,MULTICAST,UP,LOWER_UP> mtu 1500 qdisc pfifo_fast state UP mode DEFAULT group default qlen 1000

link/ether 52:54:00:44:30:51 brd ff:ff:ff:ff:ff:ff

3: eth1: <BROADCAST,MULTICAST,UP,LOWER_UP> mtu 1500 qdisc pfifo_fast state UP mode DEFAULT group default qlen 1000

link/ether 52:54:00:a3:c1:fb brd ff:ff:ff:ff:ff:ff

4: eth2: <BROADCAST,MULTICAST,UP,LOWER_UP> mtu 1500 qdisc pfifo_fast state UP mode DEFAULT group default qlen 1000

link/ether 52:54:00:32:a4:09 brd ff:ff:ff:ff:ff:ff在某些情况下,例如网络流量突然变得过高时,希望快速找出哪些应用程序正在导致流量。nethogs 是一个设计类似于 top 的工具,显示所有相关进程的传入和传出流量

PID USER PROGRAM DEV SENT RECEIVED 27145 root zypper eth0 5.719 391.749 KB/sec ? root ..0:113:80c0:8080:10:160:0:100:30015 0.102 2.326 KB/sec 26635 tux /usr/lib64/firefox/firefox eth0 0.026 0.026 KB/sec ? root ..0:113:80c0:8080:10:160:0:100:30045 0.000 0.021 KB/sec ? root ..0:113:80c0:8080:10:160:0:100:30045 0.000 0.018 KB/sec ? root ..0:113:80c0:8080:10:160:0:100:30015 0.000 0.018 KB/sec ? root ..0:113:80c0:8080:10:160:0:100:30045 0.000 0.017 KB/sec ? root ..0:113:80c0:8080:10:160:0:100:30045 0.000 0.017 KB/sec ? root ..0:113:80c0:8080:10:160:0:100:30045 0.069 0.000 KB/sec ? root unknown TCP 0.000 0.000 KB/sec TOTAL 5.916 394.192 KB/sec

与 top 一样,nethogs 具有交互式命令

| M:在显示模式之间切换(kb/s、kb、b、mb) |

| R:按排序 |

| S:按排序 |

| Q:退出 |

ethtool 可以显示和更改您的以太网网络设备的详细方面。默认情况下,它会打印指定设备的当前设置。

# ethtool eth0

Settings for eth0:

Supported ports: [ TP ]

Supported link modes: 10baseT/Half 10baseT/Full

100baseT/Half 100baseT/Full

1000baseT/Full

Supports auto-negotiation: Yes

Advertised link modes: 10baseT/Half 10baseT/Full

100baseT/Half 100baseT/Full

1000baseT/Full

Advertised pause frame use: No

[...]

Link detected: yes下表显示了您可以用来查询设备的特定信息的 ethtool 选项

表 2.1: ethtool 的查询选项列表 #

|

|

它查询设备以获取 |

|---|---|

|

-a |

暂停参数信息 |

|

-c |

中断合并信息 |

|

-g |

Rx/Tx(接收/发送)环参数信息 |

|

-i |

相关驱动程序信息 |

|

-k |

卸载信息 |

|

-S |

NIC 和驱动程序特定统计信息 |

ss 是一个用于转储套接字统计信息的工具,它取代了 netstat 命令。要列出所有连接,请不带参数使用 ss

# ss

Netid State Recv-Q Send-Q Local Address:Port Peer Address:Port

u_str ESTAB 0 0 * 14082 * 14083

u_str ESTAB 0 0 * 18582 * 18583

u_str ESTAB 0 0 * 19449 * 19450

u_str ESTAB 0 0 @/tmp/dbus-gmUUwXABPV 18784 * 18783

u_str ESTAB 0 0 /var/run/dbus/system_bus_socket 19383 * 19382

u_str ESTAB 0 0 @/tmp/dbus-gmUUwXABPV 18617 * 18616

u_str ESTAB 0 0 @/tmp/dbus-58TPPDv8qv 19352 * 19351

u_str ESTAB 0 0 * 17658 * 17657

u_str ESTAB 0 0 * 17693 * 17694

[..]要显示当前所有打开的网络端口,请使用以下命令

# ss -l

Netid State Recv-Q Send-Q Local Address:Port Peer Address:Port

nl UNCONN 0 0 rtnl:4195117 *

nl UNCONN 0 0 rtnl:wickedd-auto4/811 *

nl UNCONN 0 0 rtnl:wickedd-dhcp4/813 *

nl UNCONN 0 0 rtnl:4195121 *

nl UNCONN 0 0 rtnl:4195115 *

nl UNCONN 0 0 rtnl:wickedd-dhcp6/814 *

nl UNCONN 0 0 rtnl:kernel *

nl UNCONN 0 0 rtnl:wickedd/817 *

nl UNCONN 0 0 rtnl:4195118 *

nl UNCONN 0 0 rtnl:nscd/706 *

nl UNCONN 4352 0 tcpdiag:ss/2381 *

[...]显示网络连接时,您可以指定要显示的套接字类型:例如 TCP (-t) 或 UDP (-u)。-p 选项显示每个套接字所属程序的 PID 和名称。

以下示例列出所有 TCP 连接以及使用这些连接的程序。-a 选项确保显示所有已建立的连接(监听和非监听)。-p 选项显示每个套接字所属程序的 PID 和名称。

# ss -t -a -p

State Recv-Q Send-Q Local Address:Port Peer Address:Port

LISTEN 0 128 *:ssh *:* users:(("sshd",1551,3))

LISTEN 0 100 127.0.0.1:smtp *:* users:(("master",1704,13))

ESTAB 0 132 10.120.65.198:ssh 10.120.4.150:55715 users:(("sshd",2103,5))

LISTEN 0 128 :::ssh :::* users:(("sshd",1551,4))

LISTEN 0 100 ::1:smtp :::* users:(("master",1704,14))/proc 文件系统是一个伪文件系统,内核以虚拟文件的形式在其中保留重要信息。例如,使用此命令显示 CPU 类型

> cat /proc/cpuinfo

processor : 0

vendor_id : GenuineIntel

cpu family : 6

model : 30

model name : Intel(R) Core(TM) i5 CPU 750 @ 2.67GHz

stepping : 5

microcode : 0x6

cpu MHz : 1197.000

cache size : 8192 KB

physical id : 0

siblings : 4

core id : 0

cpu cores : 4

apicid : 0

initial apicid : 0

fpu : yes

fpu_exception : yes

cpuid level : 11

wp : yes

flags : fpu vme de pse tsc msr pae mce cx8 apic sep mtrr pge mca cmov pat pse36 clflush dts acpi mmx fxsr sse sse2 ss ht tm pbe syscall nx rdtscp lm constant_tsc arch_perfmon pebs bts rep_good nopl xtopology nonstop_tsc aperfmperf pni dtes64 monitor ds_cpl vmx smx est tm2 ssse3 cx16 xtpr pdcm sse4_1 sse4_2 popcnt lahf_lm ida dtherm tpr_shadow vnmi flexpriority ept vpid

bogomips : 5333.85

clflush size : 64

cache_alignment : 64

address sizes : 36 bits physical, 48 bits virtual

power management:

[...]提示:详细处理器信息

关于 AMD64/Intel 64 架构上处理器的详细信息也可以通过运行 x86info 获得。

使用以下命令查询中断的分配和使用

> cat /proc/interrupts

CPU0 CPU1 CPU2 CPU3

0: 121 0 0 0 IO-APIC-edge timer

8: 0 0 0 1 IO-APIC-edge rtc0

9: 0 0 0 0 IO-APIC-fasteoi acpi

16: 0 11933 0 0 IO-APIC-fasteoi ehci_hcd:+

18: 0 0 0 0 IO-APIC-fasteoi i801_smbus

19: 0 117978 0 0 IO-APIC-fasteoi ata_piix,+

22: 0 0 3275185 0 IO-APIC-fasteoi enp5s1

23: 417927 0 0 0 IO-APIC-fasteoi ehci_hcd:+

40: 2727916 0 0 0 HPET_MSI-edge hpet2

41: 0 2749134 0 0 HPET_MSI-edge hpet3

42: 0 0 2759148 0 HPET_MSI-edge hpet4

43: 0 0 0 2678206 HPET_MSI-edge hpet5

45: 0 0 0 0 PCI-MSI-edge aerdrv, P+

46: 0 0 0 0 PCI-MSI-edge PCIe PME,+

47: 0 0 0 0 PCI-MSI-edge PCIe PME,+

48: 0 0 0 0 PCI-MSI-edge PCIe PME,+

49: 0 0 0 387 PCI-MSI-edge snd_hda_i+

50: 933117 0 0 0 PCI-MSI-edge nvidia

NMI: 2102 2023 2031 1920 Non-maskable interrupts

LOC: 92 71 57 41 Local timer interrupts

SPU: 0 0 0 0 Spurious interrupts

PMI: 2102 2023 2031 1920 Performance monitoring int+

IWI: 47331 45725 52464 46775 IRQ work interrupts

RTR: 2 0 0 0 APIC ICR read retries

RES: 472911 396463 339792 323820 Rescheduling interrupts

CAL: 48389 47345 54113 50478 Function call interrupts

TLB: 28410 26804 24389 26157 TLB shootdowns

TRM: 0 0 0 0 Thermal event interrupts

THR: 0 0 0 0 Threshold APIC interrupts

MCE: 0 0 0 0 Machine check exceptions

MCP: 40 40 40 40 Machine check polls

ERR: 0

MIS: 0可执行文件和库的地址分配包含在 maps 文件中

> cat /proc/self/maps

08048000-0804c000 r-xp 00000000 03:03 17753 /bin/cat

0804c000-0804d000 rw-p 00004000 03:03 17753 /bin/cat

0804d000-0806e000 rw-p 0804d000 00:00 0 [heap]

b7d27000-b7d5a000 r--p 00000000 03:03 11867 /usr/lib/locale/en_GB.utf8/

b7d5a000-b7e32000 r--p 00000000 03:03 11868 /usr/lib/locale/en_GB.utf8/

b7e32000-b7e33000 rw-p b7e32000 00:00 0

b7e33000-b7f45000 r-xp 00000000 03:03 8837 /lib/libc-2.3.6.so

b7f45000-b7f46000 r--p 00112000 03:03 8837 /lib/libc-2.3.6.so

b7f46000-b7f48000 rw-p 00113000 03:03 8837 /lib/libc-2.3.6.so

b7f48000-b7f4c000 rw-p b7f48000 00:00 0

b7f52000-b7f53000 r--p 00000000 03:03 11842 /usr/lib/locale/en_GB.utf8/

[...]

b7f5b000-b7f61000 r--s 00000000 03:03 9109 /usr/lib/gconv/gconv-module

b7f61000-b7f62000 r--p 00000000 03:03 9720 /usr/lib/locale/en_GB.utf8/

b7f62000-b7f76000 r-xp 00000000 03:03 8828 /lib/ld-2.3.6.so

b7f76000-b7f78000 rw-p 00013000 03:03 8828 /lib/ld-2.3.6.so

bfd61000-bfd76000 rw-p bfd61000 00:00 0 [stack]

ffffe000-fffff000 ---p 00000000 00:00 0 [vdso]可以从 /proc 文件系统获取更多信息。一些重要的文件及其内容是

/proc/devices可用设备

/proc/modules已加载的内核模块

/proc/cmdline内核命令行

/proc/meminfo内存使用情况的详细信息

/proc/config.gz当前运行的内核的

gzip压缩配置文件- /proc/PID/

在

/proc/NNN 目录中查找有关当前运行进程的信息,其中 NNN 是相关进程的进程 ID (PID)。每个进程都可以在/proc/self/中找到自己的特性。

更多信息可在文本文件 /usr/src/linux/Documentation/filesystems/proc.txt 中获得(安装 kernel-source 软件包时此文件可用)。

procinfo 命令总结了 /proc 文件系统中的重要信息

> procinfo

Linux 3.11.10-17-desktop (geeko@buildhost) (gcc 4.8.1 20130909) #1 4CPU [jupiter.example.com]

Memory: Total Used Free Shared Buffers Cached

Mem: 8181908 8000632 181276 0 85472 2850872

Swap: 10481660 1576 10480084

Bootup: Mon Jul 28 09:54:13 2014 Load average: 1.61 0.85 0.74 2/904 25949

user : 1:54:41.84 12.7% page in : 2107312 disk 1: 52212r 20199w

nice : 0:00:00.46 0.0% page out: 1714461 disk 2: 19387r 10928w

system: 0:25:38.00 2.8% page act: 466673 disk 3: 548r 10w

IOwait: 0:04:16.45 0.4% page dea: 272297

hw irq: 0:00:00.42 0.0% page flt: 105754526

sw irq: 0:01:26.48 0.1% swap in : 0

idle : 12:14:43.65 81.5% swap out: 394

guest : 0:02:18.59 0.2%

uptime: 3:45:22.24 context : 99809844

irq 0: 121 timer irq 41: 3238224 hpet3

irq 8: 1 rtc0 irq 42: 3251898 hpet4

irq 9: 0 acpi irq 43: 3156368 hpet5

irq 16: 14589 ehci_hcd:usb1 irq 45: 0 aerdrv, PCIe PME

irq 18: 0 i801_smbus irq 46: 0 PCIe PME, pciehp

irq 19: 124861 ata_piix, ata_piix, f irq 47: 0 PCIe PME, pciehp

irq 22: 3742817 enp5s1 irq 48: 0 PCIe PME, pciehp

irq 23: 479248 ehci_hcd:usb2 irq 49: 387 snd_hda_intel

irq 40: 3216894 hpet2 irq 50: 1088673 nvidia要查看所有信息,请使用参数 -a。参数 -nN 会每 N 秒更新一次信息。在这种情况下,按 Q 停止程序。

默认情况下,显示累积值。参数 -d 生成差分值。procinfo -dn5 显示过去五秒内更改的值

系统控制参数用于在运行时修改 Linux 内核参数。它们位于 /proc/sys/ 中,可以使用 sysctl 命令进行查看和修改。要列出所有参数,请运行 sysctl -a。可以使用 sysctl PARAMETER_NAME 列出单个参数。

参数按类别分组,可以使用 sysctl CATEGORY 或列出相应目录的内容来列出。下面列出了最重要的类别。要查看进一步阅读的链接,需要安装 kernel-source 软件包。

sysctl dev(/proc/sys/dev/)设备特定信息。

sysctl fs(/proc/sys/fs/)使用的文件句柄、配额和其他面向文件系统的参数。有关详细信息,请参阅

/usr/src/linux/Documentation/sysctl/fs.txt。sysctl kernel(/proc/sys/kernel/)有关任务调度程序、系统共享内存和其他内核相关参数的信息。有关详细信息,请参阅

/usr/src/linux/Documentation/sysctl/kernel.txtsysctl net(/proc/sys/net/)有关网络桥接器和通用网络参数的信息(主要是

ipv4/子目录)。有关详细信息,请参阅/usr/src/linux/Documentation/sysctl/net.txtsysctl vm(/proc/sys/vm/)此路径中的条目与虚拟内存、交换和缓存的信息相关。有关详细信息,请参阅

/usr/src/linux/Documentation/sysctl/vm.txt

要设置或更改当前会话的参数,请使用命令 sysctl -w PARAMETER=VALUE。要永久更改设置,请将一行 PARAMETER=VALUE 添加到 /etc/sysctl.conf。

注意:访问 PCI 配置。

大多数操作系统要求 root 用户权限才能授予对计算机 PCI 配置的访问权限。

命令 lspci 列出 PCI 资源

# lspci

00:00.0 Host bridge: Intel Corporation 82845G/GL[Brookdale-G]/GE/PE \

DRAM Controller/Host-Hub Interface (rev 01)

00:01.0 PCI bridge: Intel Corporation 82845G/GL[Brookdale-G]/GE/PE \

Host-to-AGP Bridge (rev 01)

00:1d.0 USB Controller: Intel Corporation 82801DB/DBL/DBM \

(ICH4/ICH4-L/ICH4-M) USB UHCI Controller #1 (rev 01)

00:1d.1 USB Controller: Intel Corporation 82801DB/DBL/DBM \

(ICH4/ICH4-L/ICH4-M) USB UHCI Controller #2 (rev 01)

00:1d.2 USB Controller: Intel Corporation 82801DB/DBL/DBM \

(ICH4/ICH4-L/ICH4-M) USB UHCI Controller #3 (rev 01)

00:1d.7 USB Controller: Intel Corporation 82801DB/DBM \

(ICH4/ICH4-M) USB2 EHCI Controller (rev 01)

00:1e.0 PCI bridge: Intel Corporation 82801 PCI Bridge (rev 81)

00:1f.0 ISA bridge: Intel Corporation 82801DB/DBL (ICH4/ICH4-L) \

LPC Interface Bridge (rev 01)

00:1f.1 IDE interface: Intel Corporation 82801DB (ICH4) IDE \

Controller (rev 01)

00:1f.3 SMBus: Intel Corporation 82801DB/DBL/DBM (ICH4/ICH4-L/ICH4-M) \

SMBus Controller (rev 01)

00:1f.5 Multimedia audio controller: Intel Corporation 82801DB/DBL/DBM \

(ICH4/ICH4-L/ICH4-M) AC'97 Audio Controller (rev 01)

01:00.0 VGA compatible controller: Matrox Graphics, Inc. G400/G450 (rev 85)

02:08.0 Ethernet controller: Intel Corporation 82801DB PRO/100 VE (LOM) \

Ethernet Controller (rev 81)使用 -v 会生成更详细的列表

# lspci -v

[...]

00:03.0 Ethernet controller: Intel Corporation 82540EM Gigabit Ethernet \

Controller (rev 02)

Subsystem: Intel Corporation PRO/1000 MT Desktop Adapter

Flags: bus master, 66MHz, medium devsel, latency 64, IRQ 19

Memory at f0000000 (32-bit, non-prefetchable) [size=128K]

I/O ports at d010 [size=8]

Capabilities: [dc] Power Management version 2

Capabilities: [e4] PCI-X non-bridge device

Kernel driver in use: e1000

Kernel modules: e1000设备名称解析的信息从文件 /usr/share/pci.ids 中获取。未在此文件中列出的 PCI ID 被标记为“未知设备”。

参数 -vv 生成程序可以查询的所有信息。要查看纯数字值,请使用参数 -n。

命令 lsusb 列出所有 USB 设备。使用选项 -v,打印更详细的列表。详细信息从目录 /proc/bus/usb/ 读取。以下是 lsusb 在连接了这些 USB 设备(集线器、记忆棒、硬盘和鼠标)时的输出。

# lsusb

Bus 004 Device 007: ID 0ea0:2168 Ours Technology, Inc. Transcend JetFlash \

2.0 / Astone USB Drive

Bus 004 Device 006: ID 04b4:6830 Cypress Semiconductor Corp. USB-2.0 IDE \

Adapter

Bus 004 Device 005: ID 05e3:0605 Genesys Logic, Inc.

Bus 004 Device 001: ID 0000:0000

Bus 003 Device 001: ID 0000:0000

Bus 002 Device 001: ID 0000:0000

Bus 001 Device 005: ID 046d:c012 Logitech, Inc. Optical Mouse

Bus 001 Device 001: ID 0000:0000

tmon 是一个工具,用于帮助可视化、调优和测试复杂的热子系统。不带参数启动时,tmon 以监控模式运行

┌──────THERMAL ZONES(SENSORS)──────────────────────────────┐ │Thermal Zones: acpitz00 │ │Trip Points: PC │ └──────────────────────────────────────────────────────────┘ ┌─────────── COOLING DEVICES ──────────────────────────────┐ │ID Cooling Dev Cur Max Thermal Zone Binding │ │00 Processor 0 3 ││││││││││││ │ │01 Processor 0 3 ││││││││││││ │ │02 Processor 0 3 ││││││││││││ │ │03 Processor 0 3 ││││││││││││ │ │04 intel_powerc -1 50 ││││││││││││ │ └──────────────────────────────────────────────────────────┘ ┌──────────────────────────────────────────────────────────┐ │ 10 20 30 40 │ │acpitz 0:[ 8][>>>>>>>>>P9 C31 │ └──────────────────────────────────────────────────────────┘ ┌────────────────── CONTROLS ──────────────────────────────┐ │PID gain: kp=0.36 ki=5.00 kd=0.19 Output 0.00 │ │Target Temp: 65.0C, Zone: 0, Control Device: None │ └──────────────────────────────────────────────────────────┘ Ctrl-c - Quit TAB - Tuning

有关如何解释数据、如何记录热数据以及如何使用 tmon 测试和调优冷却设备和传感器的详细信息,请参阅手册页:man 8 tmon。tmon 软件包默认不安装。

注意:可用性

此工具仅在 AMD64/Intel 64 系统上可用。

mcelog 软件包可记录并解析/转换硬件错误(包括 I/O、CPU 和内存错误)导致的机器检查异常 (MCE)。此外,mcelog 还会处理预测性坏页脱机和发生缓存错误时的自动核心脱机。以前,这些功能通过每小时执行一次的 cron 作业来管理。现在,硬件错误由 mcelog 守护进程立即处理。

注:支持 AMD 可扩展 MCA

openSUSE Leap 支持 AMD 的可扩展机器检查架构 (Scalable MCA)。Scalable MCA 改进了 AMD Zen 处理器中的硬件错误报告。它扩展了 MCA 库中记录的信息,以改进错误处理和诊断能力。

mcelog 捕获 MCA 消息(rasdaemon 和 dmesg 也会捕获 MCA 消息)。有关详细信息,请参阅《适用于 AMD Family 17h Model 01h, Revision B1 处理器的处理器编程参考 (PPR)》第 3.1 节“机器检查架构”,https://developer.amd.com/wordpress/media/2017/11/54945_PPR_Family_17h_Models_00h-0Fh.pdf。

mcelog 在 /etc/mcelog/mcelog.conf 中配置。配置选项在 man mcelog 和 https://mcelog.org/ 中有说明。以下示例仅显示对默认文件的更改

daemon = yes filter = yes filter-memory-errors = yes no-syslog = yes logfile = /var/log/mcelog run-credentials-user = root run-credentials-group = nobody client-group = root socket-path = /var/run/mcelog-client

mcelog 服务默认未启用。该服务可以通过 YaST 系统服务编辑器启用和启动,也可以通过命令行启用和启动

#systemctl enable mcelog#systemctl start mcelog

dmidecode 显示机器的 DMI 表,其中包含硬件的序列号和 BIOS 修订版等信息。

# dmidecode

# dmidecode 2.12

SMBIOS 2.5 present.

27 structures occupying 1298 bytes.

Table at 0x000EB250.

Handle 0x0000, DMI type 4, 35 bytes

Processor Information

Socket Designation: J1PR

Type: Central Processor

Family: Other

Manufacturer: Intel(R) Corporation

ID: E5 06 01 00 FF FB EB BF

Version: Intel(R) Core(TM) i5 CPU 750 @ 2.67GHz

Voltage: 1.1 V

External Clock: 133 MHz

Max Speed: 4000 MHz

Current Speed: 2667 MHz

Status: Populated, Enabled

Upgrade: Other

L1 Cache Handle: 0x0004

L2 Cache Handle: 0x0003

L3 Cache Handle: 0x0001

Serial Number: Not Specified

Asset Tag: Not Specified

Part Number: Not Specified

[..]file 命令通过检查 /usr/share/misc/magic 来确定文件或文件列表的类型。

> file /usr/bin/file

/usr/bin/file: ELF 64-bit LSB executable, x86-64, version 1 (SYSV), \

for GNU/Linux 2.6.4, dynamically linked (uses shared libs), stripped参数 -f LIST 指定一个包含要检查的文件名列表的文件。-z 允许 file 查看压缩文件

>file /usr/share/man/man1/file.1.gz /usr/share/man/man1/file.1.gz: gzip compressed data, from Unix, max compression>file -z /usr/share/man/man1/file.1.gz /usr/share/man/man1/file.1.gz: troff or preprocessor input text \ (gzip compressed data, from Unix, max compression)

参数 -i 输出 MIME 类型字符串而不是传统描述。

> file -i /usr/share/misc/magic

/usr/share/misc/magic: text/plain charset=utf-8mount 命令显示哪个文件系统(设备和类型)挂载在哪个挂载点上

# mount

/dev/sda2 on / type ext4 (rw,acl,user_xattr)

proc on /proc type proc (rw)

sysfs on /sys type sysfs (rw)

debugfs on /sys/kernel/debug type debugfs (rw)

devtmpfs on /dev type devtmpfs (rw,mode=0755)

tmpfs on /dev/shm type tmpfs (rw,mode=1777)

devpts on /dev/pts type devpts (rw,mode=0620,gid=5)

/dev/sda3 on /home type ext3 (rw)

securityfs on /sys/kernel/security type securityfs (rw)

fusectl on /sys/fs/fuse/connections type fusectl (rw)

gvfs-fuse-daemon on /home/tux/.gvfs type fuse.gvfs-fuse-daemon \

(rw,nosuid,nodev,user=tux)使用 df 命令获取有关文件系统总使用情况的信息。参数 -h(或 --human-readable)将输出转换为普通用户可理解的形式。

> df -h

Filesystem Size Used Avail Use% Mounted on

/dev/sda2 20G 5,9G 13G 32% /

devtmpfs 1,6G 236K 1,6G 1% /dev

tmpfs 1,6G 668K 1,6G 1% /dev/shm

/dev/sda3 208G 40G 159G 20% /home使用 du 命令显示给定目录及其子目录中所有文件的总大小。参数 -s 抑制详细信息的输出,只给出每个参数的总大小。-h 再次将输出转换为人类可读的形式

> du -sh /opt

192M /opt使用 readelf 实用程序读取二进制文件的内容。即使是为其他硬件架构构建的 ELF 文件也适用

> readelf --file-header /bin/ls

ELF Header:

Magic: 7f 45 4c 46 02 01 01 00 00 00 00 00 00 00 00 00

Class: ELF64

Data: 2's complement, little endian

Version: 1 (current)

OS/ABI: UNIX - System V

ABI Version: 0

Type: EXEC (Executable file)

Machine: Advanced Micro Devices X86-64

Version: 0x1

Entry point address: 0x402540

Start of program headers: 64 (bytes into file)

Start of section headers: 95720 (bytes into file)

Flags: 0x0

Size of this header: 64 (bytes)

Size of program headers: 56 (bytes)

Number of program headers: 9

Size of section headers: 64 (bytes)

Number of section headers: 32

Section header string table index: 31stat 命令显示文件属性

> stat /etc/profile

File: `/etc/profile'

Size: 9662 Blocks: 24 IO Block: 4096 regular file

Device: 802h/2050d Inode: 132349 Links: 1

Access: (0644/-rw-r--r--) Uid: ( 0/ root) Gid: ( 0/ root)

Access: 2009-03-20 07:51:17.000000000 +0100

Modify: 2009-01-08 19:21:14.000000000 +0100

Change: 2009-03-18 12:55:31.000000000 +0100参数 --file-system 生成指定文件所在文件系统属性的详细信息

> stat /etc/profile --file-system

File: "/etc/profile"

ID: d4fb76e70b4d1746 Namelen: 255 Type: ext2/ext3

Block size: 4096 Fundamental block size: 4096

Blocks: Total: 2581445 Free: 1717327 Available: 1586197

Inodes: Total: 655776 Free: 490312确定哪些进程或用户当前正在访问某些文件可能很有用。例如,假设您想要卸载挂载在 /mnt 上的文件系统。umount 返回“device is busy”。然后可以使用 fuser 命令来确定哪些进程正在访问该设备

> fuser -v /mnt/*

USER PID ACCESS COMMAND

/mnt/notes.txt tux 26597 f.... less在终止在另一个终端上运行的 less 进程后,文件系统可以成功卸载。当与 -k 选项一起使用时,fuser 也会停止访问该文件的进程。

使用 w 命令,查明谁登录到系统以及每个用户正在做什么。例如

> w

16:00:59 up 1 day, 2:41, 3 users, load average: 0.00, 0.01, 0.05

USER TTY FROM LOGIN@ IDLE JCPU PCPU WHAT

tux :0 console Wed13 ?xdm? 8:15 0.03s /usr/lib/gdm/gd

tux console :0 Wed13 26:41m 0.00s 0.03s /usr/lib/gdm/gd

tux pts/0 :0 Wed13 20:11 0.10s 2.89s /usr/lib/gnome-如果有其他系统的用户远程登录,参数 -f 显示他们建立连接的计算机。

使用 time 实用程序确定命令花费的时间。此实用程序有两个版本:作为 Bash 内置命令和作为程序 (/usr/bin/time)。

> time find . > /dev/null

real 0m4.051s1

user 0m0.042s2

sys 0m0.205s3/usr/bin/time 的输出要详细得多。建议使用 -v 开关运行它以生成人类可读的输出。

/usr/bin/time -v find . > /dev/null

Command being timed: "find ."

User time (seconds): 0.24

System time (seconds): 2.08

Percent of CPU this job got: 25%

Elapsed (wall clock) time (h:mm:ss or m:ss): 0:09.03

Average shared text size (kbytes): 0

Average unshared data size (kbytes): 0

Average stack size (kbytes): 0

Average total size (kbytes): 0

Maximum resident set size (kbytes): 2516

Average resident set size (kbytes): 0

Major (requiring I/O) page faults: 0

Minor (reclaiming a frame) page faults: 1564

Voluntary context switches: 36660

Involuntary context switches: 496

Swaps: 0

File system inputs: 0

File system outputs: 0

Socket messages sent: 0

Socket messages received: 0

Signals delivered: 0

Page size (bytes): 4096

Exit status: 0您周围有很多数据可以轻松地随时间测量。例如,温度变化,或者计算机网络接口发送或接收的数据量。RRDtool 可以帮助您将此类数据存储并可视化为详细且可自定义的图表。

RRDtool 适用于大多数 Unix 平台和 Linux 发行版。openSUSE® Leap 也附带 RRDtool。您可以使用 YaST 安装它,或者在命令行中以 root 身份输入

zypper install rrdtool。

提示:绑定

RRDtool 提供了 Perl、Python、Ruby 和 PHP 绑定,因此您可以使用自己喜欢的脚本语言编写自己的监控脚本。

RRDtool 是 Round Robin Database tool 的缩写。Round Robin 是一种处理恒定数据量的方法。它使用循环缓冲区的原理,其中正在读取的数据行没有结束也没有开始。RRDtool 使用 Round Robin 数据库来存储和读取其数据。

如上所述,RRDtool 旨在处理随时间变化的数据。理想情况是传感器以恒定的时间周期重复读取测量数据(如温度、速度等),然后以给定格式导出。此类数据非常适合 RRDtool,并且易于处理并创建所需的输出。

有时无法自动定期获取数据。在将其提供给 RRDtool 之前,需要对其格式进行预处理,并且通常您需要手动操作 RRDtool。

以下是 RRDtool 基本用法的简单示例。它说明了通常 RRDtool 工作流程的所有三个重要阶段:创建数据库、更新测量值以及查看输出。

假设我们想要收集和查看 Linux 系统中内存使用情况随时间变化的信息。为了使示例更生动,我们以 4 秒的间隔测量 40 秒内当前可用内存。启动并关闭了通常会消耗大量系统内存的三个应用程序:Firefox Web 浏览器、Evolution 电子邮件客户端和 Eclipse 开发框架。

RRDtool 经常用于测量和可视化网络流量。在这种情况下,使用简单网络管理协议 (SNMP)。该协议可以查询网络设备的相关内部计数器值。正是这些值要用 RRDtool 存储。有关 SNMP 的更多信息,请参阅 http://www.net-snmp.org/。

我们的情况不同——我们需要手动获取数据。一个辅助脚本 free_mem.sh 重复读取当前可用内存的状态并将其写入标准输出。

> cat free_mem.sh

INTERVAL=4

for steps in {1..10}

do

DATE=`date +%s`

FREEMEM=`free -b | grep "Mem" | awk '{ print $4 }'`

sleep $INTERVAL

echo "rrdtool update free_mem.rrd $DATE:$FREEMEM"

done时间间隔设置为 4 秒,并使用

sleep命令实现。RRDtool 接受特殊格式的时间信息——即所谓的Unix 时间。它定义为自 1970 年 1 月 1 日午夜 (UTC) 以来的秒数。例如,1272907114 表示 2010-05-03 17:18:34。

可用内存信息以字节为单位报告,使用

free-b。首选提供基本单位(字节)而不是多个单位(如千字节)。带有

echo ...命令的行包含数据库文件的未来名称 (free_mem.rrd),并一起创建用于更新 RRDtool 值的命令行。

运行 free_mem.sh 后,您会看到类似于此的输出

> sh free_mem.sh

rrdtool update free_mem.rrd 1272974835:1182994432

rrdtool update free_mem.rrd 1272974839:1162817536

rrdtool update free_mem.rrd 1272974843:1096269824

rrdtool update free_mem.rrd 1272974847:1034219520

rrdtool update free_mem.rrd 1272974851:909438976

rrdtool update free_mem.rrd 1272974855:832454656

rrdtool update free_mem.rrd 1272974859:829120512

rrdtool update free_mem.rrd 1272974863:1180377088

rrdtool update free_mem.rrd 1272974867:1179369472

rrdtool update free_mem.rrd 1272974871:1181806592方便地将命令的输出重定向到文件,如下所示

sh free_mem.sh > free_mem_updates.log

以简化其未来的执行。

使用以下命令为我们的示例创建初始 Round Robin 数据库

> rrdtool create free_mem.rrd --start 1272974834 --step=4 \

DS:memory:GAUGE:600:U:U RRA:AVERAGE:0.5:1:24需要注意的地方 #

此命令创建名为

free_mem.rrd的文件,用于将测量值存储在 Round Robin 类型数据库中。--start选项指定将第一个值添加到数据库的时间(以 Unix 时间表示)。在此示例中,它比free_mem.sh输出的第一个时间值 (1272974835) 少一。--step指定将测量数据提供给数据库的时间间隔(以秒为单位)。DS:memory:GAUGE:600:U:U部分为数据库引入了一个新的数据源。它名为memory,类型为gauge,两次更新之间的最大秒数为 600 秒,测量范围内的最小值和最大值未知 (U)。RRA:AVERAGE:0.5:1:24创建 Round Robin 档案 (RRA),其存储数据通过合并函数 (CF) 处理,该函数计算数据点的平均值。合并函数的 3 个参数附加到行尾。

如果没有显示错误消息,则会在当前目录中创建 free_mem.rrd 数据库

> ls -l free_mem.rrd

-rw-r--r-- 1 tux users 776 May 5 12:50 free_mem.rrd创建数据库后,需要用测量数据填充它。在第 2.11.2.1 节 “收集数据”中,我们已经准备好了文件 free_mem_updates.log,它由 rrdtool update 命令组成。这些命令为我们更新数据库值。

> sh free_mem_updates.log; ls -l free_mem.rrd

-rw-r--r-- 1 tux users 776 May 5 13:29 free_mem.rrd如您所见,即使更新了数据,free_mem.rrd 的大小也保持不变。

我们已经测量了值,创建了数据库,并将测量值存储在其中。现在我们可以使用数据库,并检索或查看其值。

要从数据库中检索所有值,请在命令行中输入以下内容

> rrdtool fetch free_mem.rrd AVERAGE --start 1272974830 \

--end 1272974871

memory

1272974832: nan

1272974836: 1.1729059840e+09

1272974840: 1.1461806080e+09

1272974844: 1.0807572480e+09

1272974848: 1.0030243840e+09

1272974852: 8.9019289600e+08

1272974856: 8.3162112000e+08

1272974860: 9.1693465600e+08

1272974864: 1.1801251840e+09

1272974868: 1.1799787520e+09

1272974872: nan需要注意的地方 #

AVERAGE从数据库中获取平均值点,因为只定义了一个数据源(第 2.11.2.2 节 “创建数据库”)并使用AVERAGE处理,没有其他函数可用。输出的第一行打印在第 2.11.2.2 节 “创建数据库”中定义的数据源名称。

左侧结果列表示单个时间点,而右侧结果列表示科学记数法中相应的测量平均值。

最后一行的

nan表示“非数字”。

现在绘制表示数据库中存储值的图表

> rrdtool graph free_mem.png \

--start 1272974830 \

--end 1272974871 \

--step=4 \

DEF:free_memory=free_mem.rrd:memory:AVERAGE \

LINE2:free_memory#FF0000 \

--vertical-label "GB" \

--title "Free System Memory in Time" \

--zoom 1.5 \

--x-grid SECOND:1:SECOND:4:SECOND:10:0:%X需要注意的地方 #

free_mem.png是要创建的图表的文件名。--start和--end限制绘制图表的时间范围。--step指定图表的时间分辨率(以秒为单位)。DEF:...部分是名为free_memory的数据定义。其数据从free_mem.rrd数据库及其名为memory的数据源读取。平均值点已计算,因为在第 2.11.2.2 节 “创建数据库”中未定义其他值。LINE...部分指定要绘制到图表中的线的属性。它宽 2 像素,其数据来自free_memory定义,颜色为红色。--vertical-label设置沿y轴打印的标签,--title设置整个图表的主标签。--zoom指定图表的缩放因子。此值必须大于零。--x-grid指定如何在图表中绘制网格线及其标签。我们的示例将其每秒放置一次,而主要网格线每 4 秒放置一次。标签每 10 秒放置一次在主要网格线下方。

图 2.1: 使用 RRDtool 创建的示例图表 #

RRDtool 是一个复杂的工具,包含许多子命令和命令行选项。有些很容易理解,但要使它们产生您想要的结果并根据您的喜好进行微调可能需要付出很多努力。

除了 RRDtool 的手册页 (man 1 rrdtool) 仅提供基本信息外,您还应该查看 RRDtool 主页。那里有关于 rrdtool 命令及其所有子命令的详细文档。还有几个教程可以帮助您了解常见的 RRDtool 工作流程。

如果您对监控网络流量感兴趣,请查看 MRTG (Multi Router Traffic Grapher)。MRTG 可以绘制许多网络设备的活动图。它可以使用 RRDtool。

系统日志文件分析是分析系统最重要的任务之一。实际上,在维护或排除系统故障时,查看系统日志文件应该是首要任务。openSUSE Leap 会自动详细记录系统上发生的所有事件。自迁移到 systemd 以来,内核消息和使用 systemd 注册的系统服务的消息都记录在 systemd 日志中(请参阅《参考》一书,第 11 章“journalctl:查询 systemd 日志”)。其他日志文件(主要是系统应用程序的日志文件)以纯文本形式写入,可以使用编辑器或分页器轻松读取。也可以使用脚本解析它们。这允许您过滤其内容。

系统日志文件始终位于 /var/log 目录下。以下列表概述了默认安装后 openSUSE Leap 中的所有系统日志文件。根据您的安装范围,/var/log 还包含此处未列出的其他服务和应用程序的日志文件。下面描述的一些文件和目录是“占位符”,仅在安装相应应用程序时使用。大多数日志文件只对 root 用户可见。

apparmor/AppArmor 日志文件。有关 AppArmor 的更多信息,请参阅《安全和强化指南》。

audit/审计框架的日志。有关详细信息,请参阅《安全和强化指南》。

ConsoleKit/ConsoleKit守护进程的日志(用于跟踪哪些用户已登录以及他们如何与计算机交互的守护进程)。cups/通用 Unix 打印系统 (

cups) 的访问和错误日志。firewall防火墙日志。

gdm/GNOME 显示管理器中的日志文件。

krb5/Kerberos 网络认证系统中的日志文件。

lastlog包含每个用户上次登录信息的数据库。使用

lastlog命令查看。有关更多信息,请参阅man 8 lastlog。localmessages某些启动脚本的日志消息,例如 DHCP 客户端的日志。

mail*邮件服务器 (

postfix,sendmail) 日志。messages这是所有内核和系统日志消息的默认存放位置,在出现问题时应首先查看此处(以及

/var/log/warn)。NetworkManagerNetworkManager 日志文件。

news/新闻服务器的日志消息。

chrony/网络时间协议守护进程 (

chrony) 的日志。pk_backend_zypp*PackageKit(带有

libzypp后端)日志文件。samba/Samba(Windows SMB/CIFS 文件服务器)的日志文件。

warn所有系统警告和错误的日志。在出现问题时,此处(以及

systemd日志的输出)应该是首先查看的地方。wtmp所有登录/注销活动和远程连接的数据库。使用

last命令查看。有关更多信息,请参阅man 1 last。Xorg.NUMBER.logX.Org 启动日志文件。如果启动 X.Org 时遇到问题,请查阅这些文件。

文件名中的 NUMBER 是显示器编号。例如,默认的

Xorg.0.log是显示器编号0的日志,Xorg.1.log是显示器编号1的日志。先前 X.Org 启动的副本命名为Xorg.NUMBER.log.old。注意

X.Org 日志文件仅在您以

root身份启动 X.Org 会话时才在/var/log/目录中可用。如果您以任何其他用户身份启动 X.Org 会话,则可以在~/.local/share/xorg/目录中找到日志文件。YaST2/所有 YaST 日志文件。

zypp/libzypp日志文件。有关软件包安装历史记录,请参阅这些文件。zypper.log命令行安装程序

zypper的日志。

要查看日志文件,您可以使用任何文本编辑器。YaST 控制中心中的 › 下也提供了一个用于查看系统日志的简单 YaST 模块。

要在文本控制台中查看日志文件,请使用 less 或 more 命令。使用 head 和 tail 查看日志文件的开头或结尾。要实时查看附加到日志文件的条目,请使用 tail -f。有关如何使用这些工具的信息,请参阅其手册页。

要在日志文件中搜索字符串或正则表达式,请使用 grep。awk 对于解析和重写日志文件很有用。

/var/log 下的日志文件每天都会增长,并很快变得很大。logrotate 是一个帮助您管理日志文件及其增长的工具。它允许自动轮换、删除、压缩和邮寄日志文件。日志文件可以定期处理(每日、每周或每月)或在超过特定大小时处理。

logrotate 每天由 systemd 运行,因此每天只修改日志文件一次。但是,如果日志文件因其大小而修改,或者 logrotate 每天运行多次,或者启用 --force,则会发生例外。使用 /var/lib/misc/logrotate.status 查找特定文件上次轮换的时间。

logrotate 的主配置文件是 /etc/logrotate.conf。生成日志文件的系统软件包和程序(例如,apache2)将其自己的配置文件放在 /etc/logrotate.d/ 目录中。/etc/logrotate.d/ 的内容通过 /etc/logrotate.conf 包含。

示例 3.1: /etc/logrotate.conf 示例 #

# see "man logrotate" for details # rotate log files weekly weekly # keep 4 weeks worth of backlogs rotate 4 # create new (empty) log files after rotating old ones create # use date as a suffix of the rotated file dateext # uncomment this if you want your log files compressed #compress # comment these to switch compression to use gzip or another # compression scheme compresscmd /usr/bin/bzip2 uncompresscmd /usr/bin/bunzip2 # RPM packages drop log rotation information into this directory include /etc/logrotate.d

重要:避免权限冲突

create 选项会考虑 /etc/permissions* 中指定的文件模式和所有权。如果您修改这些设置,请确保不会出现冲突。

logwatch 是一个可自定义、可插拔的日志监控脚本。它解析系统日志,提取重要信息并以人类可读的方式呈现。要使用 logwatch,请安装 logwatch 软件包。

logwatch 可以在命令行上用于即时生成报告,也可以通过 cron 定期创建自定义报告。报告可以打印在屏幕上,保存到文件,或邮寄到指定地址。后者在使用 cron 自动生成报告时特别有用。

在命令行上,您可以告诉 logwatch 为哪个服务和时间范围生成报告,以及应包含多少细节

# Detailed report on all kernel messages from yesterday logwatch --service kernel --detail High --range Yesterday --print # Low detail report on all sshd events recorded (incl. archived logs) logwatch --service sshd --detail Low --range All --archives --print # Mail a report on all smartd messages from May 5th to May 7th to root@localhost logwatch --service smartd --range 'between 5/5/2005 and 5/7/2005' \ --mailto root@localhost --print

--range 选项具有复杂的语法——有关详细信息,请参阅 logwatch --range help。可以使用以下命令获取可查询的所有服务列表

> ls /usr/share/logwatch/default.conf/services/ | sed 's/\.conf//g'

logwatch 可以进行非常详细的自定义。但是,默认配置应该足够了。默认配置文件位于 /usr/share/logwatch/default.conf/。切勿更改它们,因为它们会在下次更新时被覆盖。相反,将自定义配置放置在 /etc/logwatch/conf/ 中(您可以使用默认配置文件作为模板)。有关自定义 logwatch 的详细操作方法可在 /usr/share/doc/packages/logwatch/HOWTO-Customize-LogWatch 中找到。存在以下配置文件

logwatch.conf主配置文件。默认版本注释详细。每个配置选项都可以在命令行上覆盖。

ignore.conf过滤掉

logwatch应全局忽略的所有行。services/*.conf服务目录包含每个可以生成报告的服务的配置文件。

logfiles/*.conf指定每个服务应解析的日志文件。

系统守护程序、cron 作业、systemd 计时器和其他应用程序可以生成消息并将其发送给系统的 root 用户。默认情况下,每个用户帐户都拥有一个本地邮箱,并在登录时收到新邮件消息的通知。

这些消息可能包含与安全相关的报告和事件,需要系统管理员快速响应。为了及时收到这些消息的通知,强烈建议将这些邮件转发到定期检查的专用远程电子邮件帐户。

过程 3.1: 为 root 用户配置邮件转发 #

要转发 root 用户的邮件,请执行以下步骤

安装 yast2-mail 软件包

#zypper in yast2-mail运行交互式 YaST 邮件配置

#yast mail选择作为,然后继续。

输入的地址。如有必要,配置。强烈建议以防止潜在的敏感系统数据通过网络未加密发送。继续。

输入要的电子邮件地址,然后配置。

重要提示:不要接受远程 SMTP 连接

不要启用,否则本地机器将充当邮件中继。

发送消息以测试邮件转发是否正常工作

>mail rootsubject: test test .使用

mailq命令验证测试消息是否已发送。成功后,队列应为空。消息应由先前配置的专用邮件地址接收。

根据管理机器的数量和需要通知系统事件的人员数量,可以建立不同的电子邮件地址模型

将不同系统中的消息收集到一个电子邮件帐户中,该帐户仅由一个人访问。

将不同系统中的消息收集到可以由所有相关人员访问的群组电子邮件帐户(别名或邮件列表)中。

为每个系统创建单独的电子邮件帐户。

管理员定期检查相关电子邮件帐户至关重要。为方便此项工作并识别重要事件,请避免发送不必要的信息。配置应用程序仅发送相关信息。

系统日志数据可以从各个系统转发到网络上的中央 syslog 服务器。这允许管理员全面了解所有主机上的事件,并防止成功控制系统的攻击者操纵系统日志以掩盖他们的踪迹。

设置中央 syslog 服务器包括两个部分。首先配置中央日志服务器,然后配置客户端进行远程日志记录。

过程 3.2: 配置中央 rsyslog 服务器 #

要设置中央 syslog 服务器,请执行以下步骤

编辑配置文件

/etc/rsyslog.d/remote.conf。取消注释配置文件中

UDP Syslog Server或TCP Syslog Server部分的以下行。为rsyslogd分配 IP 地址和端口。TCP 示例

$ModLoad imtcp.so $UDPServerAddress IP1 $InputTCPServerRun PORT2

UDP 示例

重要:TCP 与 UDP 协议

传统上,syslog 使用 UDP 协议通过网络传输日志消息。这涉及的开销较小,但缺乏可靠性。在高负载下,日志消息可能会丢失。

TCP 协议更可靠,应优先于 UDP。

注意:带 TCP 的

UDPServerAddressTCP 示例中的

$UDPServerAddress配置参数没有错误。尽管其名称如此,但它同时用于 TCP 和 UDP。保存文件。

重启

rsyslog服务>sudosystemctl restart rsyslog.service在防火墙中打开相应的端口。对于在端口 514 上使用 TCP 的

firewalld,运行>sudofirewall-cmd --add-port 514/tcp --permanent>sudofirewall-cmd --reload

您现在已配置中央 syslog 服务器。接下来,配置客户端进行远程日志记录。

过程 3.3: 配置 rsyslog 实例进行远程日志记录 #

要配置机器以远程日志记录到中央 syslog 服务器,请执行以下步骤

编辑配置文件

/etc/rsyslog.d/remote.conf。取消注释相应的行(TCP 或 UDP),并将

remote-host替换为在第 3.6.1 节 “设置中央 syslog 服务器”中设置的中央 syslog 服务器的地址。TCP 示例

# Remote Logging using TCP for reliable delivery # remote host is: name/ip:port, e.g. 192.168.0.1:514, port optional *.* @@remote-host

UDP 示例

# Remote Logging using UDP # remote host is: name/ip:port, e.g. 192.168.0.1:514, port optional *.* @remote-host

保存文件。

重启

rsyslog服务>sudosystemctl restart rsyslog.service验证 syslog 转发是否正常工作

>logger "hello world"日志消息

hello world现在应该出现在中央 syslog 服务器上。

您现在已配置系统以远程日志记录到您的中央 syslog 服务器。对所有需要远程日志记录的系统重复此过程。

此基本设置不包括加密,仅适用于受信任的内部网络。强烈建议使用 TLS 加密,但需要证书基础设施。

在此配置中,来自远程主机的所有消息在中央 syslog 服务器上都以相同的方式处理。考虑按远程主机将消息过滤到单独的文件中,或按消息类别对其进行分类。

有关加密、过滤和其他高级主题的更多信息,请参阅 RSyslog 文档,网址为 https://www.rsyslog.com/doc/master/index.html#manual。

- 4 SystemTap—过滤和分析系统数据

SystemTap 提供命令行接口和脚本语言,用于详细检查运行中的 Linux 系统(特别是内核)的活动。SystemTap 脚本以 SystemTap 脚本语言编写,然后编译为 C 代码内核模块并插入到内核中…

- 5 内核探针

内核探针是一组用于收集 Linux 内核调试和性能信息的工具。开发人员和系统管理员使用它们来调试内核,或查找系统性能瓶颈。报告的数据然后可以用于调整系统以获得更好的性能。

- 6 使用 Perf 进行基于硬件的性能监控

Perf 是一个用于访问处理器性能监控单元 (PMU) 并记录和显示软件事件(如页面错误)的接口。它支持全系统、每个线程和 KVM 虚拟化客户机监控。

- 7 OProfile—全系统分析器

OProfile 是一个用于动态程序分析的分析器。它调查正在运行的程序的行为并收集信息。这些信息可以查看,并为进一步优化提供提示。

使用 OProfile 无需重新编译或使用包装库。甚至不需要内核补丁。在分析应用程序时,您可以期望有少量开销,具体取决于工作负载和采样频率。

- 8 动态调试—内核调试消息

动态调试是 Linux 内核中的一项强大的调试功能,它允许您在运行时启用和禁用调试消息,而无需重新编译内核或重新启动系统。

SystemTap 提供命令行接口和脚本语言,用于详细检查运行中的 Linux 系统(特别是内核)的活动。SystemTap 脚本以 SystemTap 脚本语言编写,然后编译为 C 代码内核模块并插入到内核中。脚本可以设计用于提取、过滤和汇总数据,从而诊断复杂的性能问题或功能问题。SystemTap 提供的信息类似于 netstat、ps、top 和 iostat 等工具的输出。但是,可以对收集到的信息使用更多的过滤和分析选项。

每次运行 SystemTap 脚本时,都会启动一个 SystemTap 会话。在允许脚本运行之前,会对其进行几次传递。然后,脚本被编译成内核模块并加载。如果脚本之前已执行过,并且没有系统组件发生变化(例如,不同的编译器或内核版本、库路径或脚本内容),SystemTap 不会再次编译脚本。相反,它使用存储在 SystemTap 缓存 (~/.systemtap) 中的 *.c 和 *.ko 数据。

当探针运行结束后,模块将被卸载。有关示例,请参阅第 4.2 节 “安装和设置”中的测试运行和相应的解释。

SystemTap 的使用基于 SystemTap 脚本 (*.stp)。它们告诉 SystemTap 收集哪种类型的信息,以及一旦收集到信息后该怎么做。脚本以 SystemTap 脚本语言编写,该语言类似于 AWK 和 C。有关语言定义,请参阅 https://sourceware.org/systemtap/langref/。许多有用的示例脚本可在 https://www.sourceware.org/systemtap/examples/ 获取。

SystemTap 脚本的基本思想是命名 events,并为它们提供 handlers。当 SystemTap 运行脚本时,它会监控某些事件。当事件发生时,Linux 内核会作为子例程运行处理程序,然后继续执行。因此,事件充当处理程序运行的触发器。处理程序可以记录指定数据并以特定方式打印。

SystemTap 语言只使用少量数据类型(整数、字符串和它们的关联数组)和完整的控制结构(块、条件、循环、函数)。它具有轻量级标点符号(分号是可选的),并且不需要详细声明(类型会自动推断和检查)。

有关 SystemTap 脚本及其语法的更多信息,请参阅第 4.3 节 “脚本语法”以及 systemtap-docs 软件包提供的 stapprobes 和 stapfuncs 手册页。

Tapsets 是预先编写的探测器和函数库,可在 SystemTap 脚本中使用。当用户运行 SystemTap 脚本时,SystemTap 会对照 tapset 库检查脚本的探测事件和处理程序。然后 SystemTap 会加载相应的探测器和函数,然后将脚本转换为 C。与 SystemTap 脚本本身一样,tapsets 使用文件扩展名 *.stp。

然而,与 SystemTap 脚本不同,tapsets 不用于直接执行。它们构成了其他脚本可以从中提取定义的库。因此,tapset 库是一个抽象层,旨在方便用户定义事件和函数。Tapsets 为用户可能希望指定为事件的函数提供别名。了解正确的别名通常比记住可能因内核版本而异的特定内核函数更容易。

与 SystemTap 相关的主要命令是 stap 和 staprun。要执行它们,您需要 root 权限,或者必须是 stapdev 或 stapusr 组的成员。

stapSystemTap 前端。运行 SystemTap 脚本(无论是来自文件还是来自标准输入)。它将脚本翻译成 C 代码,编译它,并将生成的内核模块加载到运行中的 Linux 内核中。然后,执行请求的系统跟踪或探测功能。

staprunSystemTap 后端。加载和卸载 SystemTap 前端生成的内核模块。

要获取每个命令的选项列表,请使用 --help。有关详细信息,请参阅 stap 和 staprun 手册页。

为了避免仅为使用 SystemTap 而向用户授予 root 访问权限,请使用以下 SystemTap 组之一。它们在 openSUSE Leap 上默认不可用,但您可以创建这些组并相应地修改访问权限。此外,如果安全影响适合您的环境,请调整 staprun 命令的权限。

stapdev此组的成员可以使用

stap运行 SystemTap 脚本,或使用staprun运行 SystemTap 检测模块。由于运行stap涉及将脚本编译成内核模块并加载到内核中,因此此组的成员仍然拥有有效的root访问权限。stapusr此组的成员只允许使用

staprun运行 SystemTap 检测模块。此外,他们只能从/lib/modules/KERNEL_VERSION/systemtap/运行这些模块。此目录必须由root拥有,并且只能由root用户写入。

以下列表概述了 SystemTap 的主要文件和目录。

/lib/modules/KERNEL_VERSION/systemtap/保存 SystemTap 检测模块。

/usr/share/systemtap/tapset/保存标准 tapset 库。

/usr/share/doc/packages/systemtap/examples保存各种用途的 SystemTap 示例脚本。仅当安装了

systemtap-docs软件包时才可用。~/.systemtap/cache缓存 SystemTap 文件的目录。

/tmp/stap*SystemTap 文件的临时目录,包括翻译后的 C 代码和内核对象。

由于 SystemTap 需要有关内核的信息,因此必须安装一些额外的内核相关软件包。对于您想要使用 SystemTap 探测的每个内核,您需要安装一组以下软件包。这组软件包应该与内核版本和类型(如下概述中用 * 表示)完全匹配。

重要:包含调试信息的软件包的存储库

如果你已订阅系统的在线更新,你可以在 openSUSE Leap 15.6 相关的 *-Debuginfo-Updates 在线安装存储库中找到“debuginfo”包。使用 YaST 启用存储库。

对于经典的 SystemTap 设置,安装以下软件包(使用 YaST 或 zypper)。

systemtapsystemtap-serversystemtap-docs(可选)kernel-*-basekernel-*-debuginfokernel-*-develkernel-source-*gcc

要访问手册页和有用的各种 SystemTap 示例脚本集合,请另外安装 systemtap-docs 软件包。

要检查机器上是否正确安装了所有软件包以及 SystemTap 是否可供使用,请以 root 身份执行以下命令。

# stap -v -e 'probe vfs.read {printf("read performed\n"); exit()}'它通过运行脚本探测当前使用的内核并返回输出。如果输出与以下内容相似,则 SystemTap 已成功部署并可供使用

Pass 1: parsed user script and 59 library script(s) in 80usr/0sys/214real ms. Pass 2: analyzed script: 1 probe(s), 11 function(s), 2 embed(s), 1 global(s) in 140usr/20sys/412real ms. Pass 3: translated to C into "/tmp/stapDwEk76/stap_1856e21ea1c246da85ad8c66b4338349_4970.c" in 160usr/0sys/408real ms. Pass 4: compiled C into "stap_1856e21ea1c246da85ad8c66b4338349_4970.ko" in 2030usr/360sys/10182real ms. Pass 5: starting run. read performed Pass 5: run completed in 10usr/20sys/257real ms.

对照 | |

检查脚本的组件。 | |

将脚本翻译成 C。运行系统 C 编译器从中创建内核模块。生成的 C 代码 ( | |

加载模块并通过挂接到内核来启用脚本中的所有探测器(事件和处理程序)。正在探测的事件是虚拟文件系统 (VFS) 读取。当事件在任何处理器上发生时,执行一个有效的处理程序(打印文本 | |

SystemTap 会话终止后,探测器将被禁用,并且内核模块将被卸载。 |

如果在测试过程中出现任何错误消息,请检查输出以获取有关任何缺失软件包的提示,并确保它们已正确安装。可能还需要重新启动并加载适当的内核。

SystemTap 脚本由以下两个组件组成

- SystemTap 事件(探测点)

命名内核事件,关联的处理程序应执行。事件示例包括进入或退出某个函数、计时器到期或启动或终止会话。

- SystemTap 处理程序(探测主体)

一系列脚本语言语句,用于指定每当某个事件发生时要完成的工作。这通常包括从事件上下文中提取数据、将它们存储到内部变量或打印结果。

一个事件及其对应的处理程序统称为 probe。SystemTap 事件也称为 probe points。探测的处理程序也称为 probe body。

注释可以以不同样式插入到 SystemTap 脚本的任何位置:使用 #、/* */ 或 // 作为标记。

一个 SystemTap 脚本可以有多个探测。它们必须以以下格式编写

probe EVENT {STATEMENTS}每个探测都有一个相应的语句块。此语句块必须用 { } 括起来,并包含要为每个事件执行的语句。

示例 4.1: 简单的 SystemTap 脚本 #

以下示例显示了一个简单的 SystemTap 脚本。

probe1 begin2 {3 printf4 ("hello world\n")5 exit ()6 }7

探测开始。 | |

事件 | |

处理程序定义开始,由 | |

处理程序中定义的第一个函数: | |

要由 | |

处理程序中定义的第二个函数: | |

处理程序定义结束,由 |

事件 begin 2(SystemTap 会话开始)触发 { } 中包含的处理程序。这里是 printf 函数 4。在这种情况下,它打印 hello world 后跟一个新行 5。然后,脚本退出。

如果您的语句块包含多个语句,SystemTap 将按顺序执行这些语句——您无需在多个语句之间插入特殊的分隔符或终止符。语句块也可以嵌套在其他语句块中。通常,SystemTap 脚本中的语句块使用与 C 编程语言相同的语法和语义。

SystemTap 支持多个内置事件。

通用事件语法是点符号序列。这允许将事件命名空间分解为多个部分。每个组件标识符都可以通过字符串或数字字面量进行参数化,其语法类似于函数调用。组件可以包含 * 字符,以扩展到其他匹配的探测点。探测点后面可以跟着 ? 字符,表示它是可选的,如果扩展失败则不应导致错误。或者,探测点后面可以跟着 ! 字符,表示它既可选又充分。

SystemTap 支持每个探测有多个事件——它们需要用逗号 (,) 分隔。如果在单个探测中指定了多个事件,SystemTap 将在任何指定事件发生时执行处理程序。

事件可分为以下几类

同步事件:当任何进程在内核代码中的特定位置执行指令时发生。这为其他事件提供了一个参考点(指令地址),从中可以获得更多上下文数据。

同步事件的一个例子是

vfs.FILE_OPERATION:进入虚拟文件系统 (VFS) 的 FILE_OPERATION 事件。例如,在第 4.2 节 “安装和设置”中,read是用于 VFS 的 FILE_OPERATION 事件。异步事件:不与代码中的特定指令或位置相关联。此探测点系列主要由计数器、计时器和类似构造组成。

异步事件的示例包括:

begin(SystemTap 会话开始时——当 SystemTap 脚本运行时)、end(SystemTap 会话结束时)或计时器事件。计时器事件指定一个定期执行的处理程序,例如example timer.s(SECONDS),或timer.ms(MILLISECONDS)。当与其他收集信息的探测器一起使用时,计时器事件允许您打印定期更新并查看信息如何随时间变化。

示例 4.2: 带计时器事件的探测 #

例如,以下探测器将每 4 秒打印一次文本“hello world”

probe timer.s(4)

{

printf("hello world\n")

}有关支持事件的详细信息,请参阅 stapprobes 手册页。手册页的另请参阅部分还包含指向讨论特定子系统和组件支持事件的其他手册页的链接。

每个 SystemTap 事件都伴随着为该事件定义的相应处理程序,由一个语句块组成。

如果您需要在多个探测中执行相同的语句集,则可以将它们放在函数中以便轻松重用。函数由关键字 function 后跟名称定义。它们接受任意数量的字符串或数字参数(按值),并可能返回单个字符串或数字。

function FUNCTION_NAME(ARGUMENTS) {STATEMENTS}

probe EVENT {FUNCTION_NAME(ARGUMENTS)}当 EVENT 的探测执行时,FUNCTION_NAME 中的语句将执行。ARGUMENTS 是传递给函数的可选值。

函数可以在脚本中的任何位置定义。它们可以接受任意数量的

在示例 4.1 “简单的 SystemTap 脚本”中已经介绍了经常需要的一个函数:用于格式化打印数据的 printf 函数。使用 printf 函数时,您可以使用格式字符串指定参数的打印方式。格式字符串包含在引号中,并且可以包含由 % 字符引入的更多格式说明符。

要使用哪种格式字符串取决于您的参数列表。格式字符串可以有多个格式说明符——每个说明符匹配一个相应的参数。多个参数可以用逗号分隔。

示例 4.3: 带格式说明符的 printf 函数 #

上面的示例将当前可执行名称 (execname()) 打印为字符串,将进程 ID (pid()) 打印为括号中的整数。然后,跟着一个空格、单词 open 和一个换行符

[...] vmware-guestd(2206) open held(2360) open [...]

除了在示例 4.3 “带格式说明符的 printf 函数”中使用的两个函数 execname() 和 pid() 之外,还可以将各种其他函数用作 printf 参数。

SystemTap 最常用的函数包括以下这些

- tid()

当前线程的 ID。

- pid()

当前线程的进程 ID。

- uid()

当前用户的 ID。

- cpu()

当前 CPU 编号。

- execname()

当前进程的名称。

- gettimeofday_s()

自 Unix 纪元(1970 年 1 月 1 日)以来的秒数。

- ctime()

将时间转换为字符串。

- pp()

描述当前正在处理的探测点的字符串。

- thread_indent()

用于组织打印结果的有用函数。它(内部)为每个线程 (

tid()) 存储一个缩进计数器。该函数接受一个参数,即缩进增量,指示要从线程的缩进计数器中添加或删除多少个空格。它返回一个字符串,其中包含一些通用跟踪数据以及适当数量的缩进空格。返回的通用数据包括时间戳(自线程初始缩进以来的微秒数)、进程名称和线程 ID 本身。这允许您识别调用了哪些函数、谁调用了它们以及它们花费了多长时间。调用入口和出口通常不会立即相互前置(否则很容易匹配它们)。在第一次调用入口和其出口之间,通常会进行其他调用入口和出口。缩进计数器通过缩进下一个函数调用来帮助您将入口与其对应的出口匹配,以防它不是上一个函数的出口。

有关支持的 SystemTap 函数的更多信息,请参阅 stapfuncs 手册页。

除了函数之外,您还可以在 SystemTap 处理程序中使用其他常见的构造,包括变量、条件语句(如 if/else、while 循环、for 循环、数组或命令行参数。

变量可以在脚本中的任何位置定义。要定义变量,只需选择一个名称并为其分配一个来自函数或表达式的值

foo = gettimeofday( )

然后您可以在表达式中使用该变量。SystemTap 会根据分配给变量的值的类型自动推断每个标识符的类型(字符串或数字)。任何不一致之处都将报告为错误。在上面的示例中,foo 将自动分类为数字,并且可以使用 printf() 通过整数格式说明符 (%d) 打印。

但是,默认情况下,变量是它们所包含的探测的局部变量。它们在每次处理程序调用时初始化、使用和处置。要在探测之间共享变量,请在脚本中的任何位置声明它们为全局变量。为此,请在探测外部使用 global 关键字

示例 4.4: 使用全局变量 #

global count_jiffies, count_ms

probe timer.jiffies(100) { count_jiffies ++ }

probe timer.ms(100) { count_ms ++ }

probe timer.ms(12345)

{

hz=(1000*count_jiffies) / count_ms

printf ("jiffies:ms ratio %d:%d => CONFIG_HZ=%d\n",

count_jiffies, count_ms, hz)

exit ()

}此示例脚本通过使用计时器计算 jiffies 和毫秒,然后相应地计算,来计算内核的 CONFIG_HZ 设置。(jiffy 是系统计时器中断一个时钟周期持续的时间。它不是一个绝对时间间隔单位,因为其持续时间取决于特定硬件平台的时钟中断频率)。使用 global 语句,可以在探测 timer.ms(12345) 中使用变量 count_jiffies 和 count_ms。使用 ++,变量的值会增加 1。

您可以在 SystemTap 脚本中使用多种条件语句。最常见的条件语句如下

- If/else 语句

它们以以下格式表示

if (CONDITION)1STATEMENT12 else3STATEMENT24

if语句将整数值表达式与零进行比较。如果条件表达式 1 非零,则执行第一个语句 2。如果条件表达式为零,则执行第二个语句 4。else 子句(3 和 4)是可选的。 2 和 4 都可以是语句块。- While 循环

它们以以下格式表示

while (CONDITION)1STATEMENT2

当

condition非零时,执行语句 2。 2 也可以是语句块。它必须改变一个值,以便condition最终为零。- For 循环

它们是

while循环的快捷方式,采用以下格式表示for (INITIALIZATION1; CONDITIONAL2; INCREMENT3) statement

1 中指定的表达式用于初始化循环迭代次数的计数器,并在循环开始执行前执行。循环的执行持续到循环条件 2 为假。(此表达式在每次循环迭代开始时检查)。3 中指定的表达式用于递增循环计数器。它在每次循环迭代结束时执行。

- 条件运算符

以下运算符可在条件语句中使用

==: 等于

!=: 不等于

>=: 大于或等于

<=: 小于或等于

如果您已安装 systemtap-docs 软件包,您可以在 /usr/share/doc/packages/systemtap/examples 中找到几个有用的 SystemTap 示例脚本。

本节将更详细地描述一个相当简单的示例脚本:/usr/share/doc/packages/systemtap/examples/network/tcp_connections.stp。

示例 4.5: 使用 tcp_connections.stp 监视传入的 TCP 连接 #

#! /usr/bin/env stap

probe begin {

printf("%6s %16s %6s %6s %16s\n",

"UID", "CMD", "PID", "PORT", "IP_SOURCE")

}

probe kernel.function("tcp_accept").return?,

kernel.function("inet_csk_accept").return? {

sock = $return

if (sock != 0)

printf("%6d %16s %6d %6d %16s\n", uid(), execname(), pid(),

inet_get_local_port(sock), inet_get_ip_source(sock))

}这个 SystemTap 脚本监视传入的 TCP 连接,并帮助实时识别未经授权或不需要的网络访问请求。它显示计算机接受的每个新传入 TCP 连接的以下信息

用户 ID (

UID)接受连接的命令 (

CMD)命令的进程 ID (

PID)连接使用的端口 (

PORT)TCP 连接源 IP 地址 (

IP_SOURCE)

要运行脚本,请执行

stap /usr/share/doc/packages/systemtap/examples/network/tcp_connections.stp

并跟随屏幕上的输出。要手动停止脚本,请按 Ctrl–C。

为了调试用户空间应用程序(如 DTrace 可以做到的),openSUSE Leap 15.6 支持使用 SystemTap 进行用户空间探测。可以在任何用户空间应用程序中插入自定义探测点。因此,SystemTap 允许您使用内核空间和用户空间探测来调试整个系统的行为。

要获取用户空间探测所需的 utrace 基础设施和 uprobes 内核模块,除了 第 4.2 节 “安装和设置” 中列出的软件包外,您还需要安装 kernel-trace 软件包。

utrace 实现了一个用于控制用户空间任务的框架。它提供了一个接口,可以被各种跟踪“引擎”使用,这些引擎以可加载的内核模块的形式实现。引擎为特定事件注册回调函数,然后附加到它们想要跟踪的线程。由于回调是从内核中的“安全”位置进行的,这使得函数可以进行各种处理。可以通过 utrace 监视多个事件。例如,您可以观察系统调用进入和退出、fork() 和发送到任务的信号等事件。有关 utrace 基础设施的更多详细信息,请访问 https://sourceware.org/systemtap/wiki/utrace。

SystemTap 支持探测用户空间进程中函数的进入和返回,探测用户空间代码中预定义的标记,以及监视用户进程事件。

要检查当前运行的内核是否提供所需的 utrace 支持,请使用以下命令

>sudogrep CONFIG_UTRACE /boot/config-`uname -r`

有关用户空间探测的更多详细信息,请参阅 https://sourceware.org/systemtap/SystemTap_Beginners_Guide/userspace-probing.html。

本章仅提供 SystemTap 的简要概述。有关 SystemTap 的更多信息,请参阅以下链接

- https://sourceware.org/systemtap/

SystemTap 项目主页。

- https://sourceware.org/systemtap/wiki/

大量有用的 SystemTap 信息集合,包括详细的用户和开发者文档,以及与其他工具的评论和比较,或常见问题和提示。还包含 SystemTap 脚本、示例和使用案例的集合,并列出了关于 SystemTap 的最新讲座和论文。

- https://sourceware.org/systemtap/documentation.html

提供 PDF 和 HTML 格式的SystemTap 教程、SystemTap 初学者指南、Tapset 开发者指南和SystemTap 语言参考。还列出了相关的手册页。

您还可以在已安装系统上的 /usr/share/doc/packages/systemtap 中找到 SystemTap 语言参考和 SystemTap 教程。示例 SystemTap 脚本可在 example 子目录中找到。

内核探针是一组用于收集 Linux 内核调试和性能信息的工具。开发人员和系统管理员使用它们来调试内核,或查找系统性能瓶颈。报告的数据然后可以用于调整系统以获得更好的性能。

您可以将这些探测插入任何内核例程中,并指定在特定断点命中后调用的处理程序。内核探测的主要优点是,在探测中进行更改后,您不再需要重新构建内核并重新启动系统。

要使用内核探测,您通常需要编写或获取一个特定的内核模块。此类模块包括 init 和 exit 函数。init 函数(例如 register_kprobe())注册一个或多个探测,而 exit 函数注销它们。注册函数定义了探测插入的位置以及探测命中后调用哪个处理程序。要一次注册或注销一组探测,您可以使用相关的 register_<PROBE_TYPE>probes() 或 unregister_<PROBE_TYPE>probes() 函数。

调试和状态消息通常通过 printk 内核例程报告。printk 是用户空间 printf 例程的内核空间等效项。有关 printk 的更多信息,请参阅 记录内核消息。通常,您可以通过检查 systemd 日志的输出来查看这些消息(请参阅 书籍“参考”,第 11 章 “journalctl:查询 systemd 日志”)。有关日志文件的更多信息,请参阅 第 3 章 “系统日志文件”。

内核探测在以下架构上完全实现

x86

AMD64/Intel 64

Arm

POWER

内核探测在以下架构上部分实现

IA64 (不支持指令

slot1上的探测)sparc64 (返回探测尚未实现)

内核探测有三种类型:Kprobes、Jprobes 和 Kretprobes。Kretprobes 有时称为返回探测。您可以在 Linux 内核中找到所有三种类型探测的源代码示例。请参阅目录 /usr/src/linux/samples/kprobes/ (软件包 kernel-source)。

Kprobes 可以附加到 Linux 内核中的任何指令。注册 Kprobes 时,它会在被探测指令的第一个字节处插入一个断点。当处理器命中此断点时,处理器寄存器被保存,处理传递给 Kprobes。首先,执行一个前处理程序,然后单步执行被探测指令,最后执行一个后处理程序。然后控制权传递给探测点后面的指令。

Jprobes 通过 Kprobes 机制实现。它插入到函数的入口点,并允许直接访问被探测函数的参数。其处理例程必须与被探测函数具有相同的参数列表和返回值。要结束它,请调用 jprobe_return() 函数。

当命中 jprobe 时,处理器寄存器被保存,指令指针被指向 jprobe 处理例程。然后控制权以与被探测函数相同的寄存器内容传递给处理程序。最后,处理程序调用 jprobe_return() 函数,并将控制权切换回控制函数。

通常,您可以在一个函数上插入多个探测。然而,Jprobe 限制为每个函数只能有一个实例。

Kprobes 的编程接口由用于注册和注销所有使用的内核探测以及相关探测处理程序的函数组成。有关这些函数及其参数的更详细描述,请参阅 第 5.5 节 “更多信息” 中的信息源。

register_kprobe()在指定地址插入一个断点。当命中断点时,调用

pre_handler和post_handler。register_jprobe()在指定地址插入一个断点。该地址需要是被探测函数第一个指令的地址。当命中断点时,运行指定的处理程序。处理程序应该具有与被探测函数相同的参数列表和返回类型。

register_kretprobe()为指定的函数插入一个返回探测。当被探测函数返回时,运行指定的处理程序。此函数成功返回 0,失败返回负错误号。

unregister_kprobe()、unregister_jprobe()、unregister_kretprobe()移除指定的探测。您可以在探测注册后的任何时候使用它。

register_kprobes()、register_jprobes()、register_kretprobes()插入指定数组中的每个探测。

unregister_kprobes()、unregister_jprobes()、unregister_kretprobes()移除指定数组中的每个探测。

disable_kprobe()、disable_jprobe()、disable_kretprobe()暂时禁用指定的探测。

enable_kprobe()、enable_jprobe()、enable_kretprobe()暂时启用已禁用的探测。

在最新的 Linux 内核中,Kprobes 检测使用内核的 debugfs 接口。它可以列出所有已注册的探测并全局开启或关闭所有探测。

所有当前注册的探测列表在 /sys/kernel/debug/kprobes/list 文件中。

saturn.example.com:~ # cat /sys/kernel/debug/kprobes/list c015d71a k vfs_read+0x0 [DISABLED] c011a316 j do_fork+0x0 c03dedc5 r tcp_v4_rcv+0x0

第一列列出探测插入的内核地址。第二列打印探测的类型:k 代表 kprobe,j 代表 jprobe,r 代表返回探测。第三列指定探测的符号、偏移量和可选模块名称。接下来的可选列包括探测的状态信息。如果探测插入的虚拟地址不再有效,则用 [GONE] 标记。如果探测暂时禁用,则用 [DISABLED] 标记。

要了解有关内核探测的更多信息,请查看以下信息来源

有关内核探测的详细但技术性更强的信息可在

/usr/src/linux/Documentation/trace/kprobes.txt(软件包kernel-source) 中找到。所有三种类型探测的示例(以及相关的

Makefile)在/usr/src/linux/samples/kprobes/目录中(软件包kernel-source)。有关 Linux 内核模块和

printk内核例程的深入信息可在 The Linux Kernel Module Programming Guide 找到。

您可以将结果信息存储在报告中。此报告包含有关指令指针或线程正在执行的代码等信息。

Perf 由两部分组成

集成到 Linux 内核中,用于指示硬件的代码。

perf用户空间实用程序,允许您使用内核代码并帮助您分析收集到的数据。

性能监控意味着收集与应用程序或系统性能相关的信息。这些信息可以通过基于软件的方式或从 CPU 或芯片组获取。Perf 集成了这两种方法。

许多现代处理器包含一个性能监控单元 (PMU)。PMU 的设计和功能是 CPU 特定的。例如,寄存器、计数器和支持的功能数量因 CPU 实现而异。

每个 PMU 模型都包含一组寄存器:性能监控配置 (PMC) 和性能监控数据 (PMD)。两者都可以读取,但只有 PMC 是可写的。这些寄存器存储配置信息和数据。

Perf 支持几种分析模式

计数。 统计事件发生的次数。

基于事件的采样。 一种不太精确的计数方法:每当达到一定数量的事件时,就会记录一个样本。

基于时间的采样。 一种不太精确的计数方法:以定义的频率记录样本。

基于指令的采样(仅限 AMD64)。 处理器跟踪给定间隔内出现的指令,并采样它们产生的事件。这允许跟踪单个指令,并查看其中哪些对性能至关重要。

为了收集所需信息,perf 工具包含多个子命令。本节概述了最常用的命令。

要以手册页的形式查看任何子命令的帮助,请使用 perf helpSUBCOMMAND 或 man perf-SUBCOMMAND。

perf stat启动一个程序并创建一个统计概述,该概述在程序退出后显示。

perf stat用于计数事件。perf record启动一个程序并创建一个包含性能计数器信息的报告。报告以

perf.data存储在当前目录中。perf record用于采样事件。perf report显示先前使用

perf record创建的报告。perf annotate显示报告文件和执行代码的注释版本。如果安装了调试符号,还会显示源代码。

perf list列出 Perf 可以使用当前内核和您的 CPU 报告的事件类型。您可以按类别筛选事件类型。例如,要仅查看硬件事件,请使用

perf list hw。perf_event_open的手册页包含最重要事件的简短描述。例如,要查找事件branch-misses的描述,请搜索BRANCH_MISSES(注意拼写差异)。>manperf_event_open |grep-A5 BRANCH_MISSES有时,事件可能模棱两可。小写硬件事件名称不是原始硬件事件的名称,而是 Perf 创建的别名名称。这些别名映射到每个支持的处理器上命名不同但定义相似的硬件事件。

例如,

cpu-cycles事件在 Intel 处理器上映射到硬件事件UNHALTED_CORE_CYCLES。然而,在 AMD 处理器上,它映射到硬件事件CPU_CLK_UNHALTED。Perf 还允许测量特定于您硬件的原始事件。要查找它们的描述,请参阅您的 CPU 供应商的架构软件开发人员手册。有关 AMD64/Intel 64 处理器的相关文档已链接在 第 6.7 节 “更多信息” 中。